Halkın tıp mesleğine olan güvenini kullanan AI tarafından üretilen ‘Tikdocs’a, kabataslak takviyelerin satışlarını artırmak için dikkat edin

25 Nis 2025

•

–

3 dk. Okumak

Araştırma laboratuarlarıyla sınırlı bir kez, üretken AI artık herkes için kullanılabilir – kötü niyetleri olan, AI araçlarını yaratıcılığı ateşlememek için değil, bunun yerine aldatmayı beslemek için kullanılabilir. Oldukça gerçekçi videolar, görüntüler ve ses üretebilen Deep Pheake teknolojisi, sadece ünlü kimliğe bürünme dublörleri veya kamuoyunu sallama çabaları için değil, aynı zamanda kimlik hırsızlığı ve her türlü dolandırıcılık için gittikçe daha da ilerliyor.

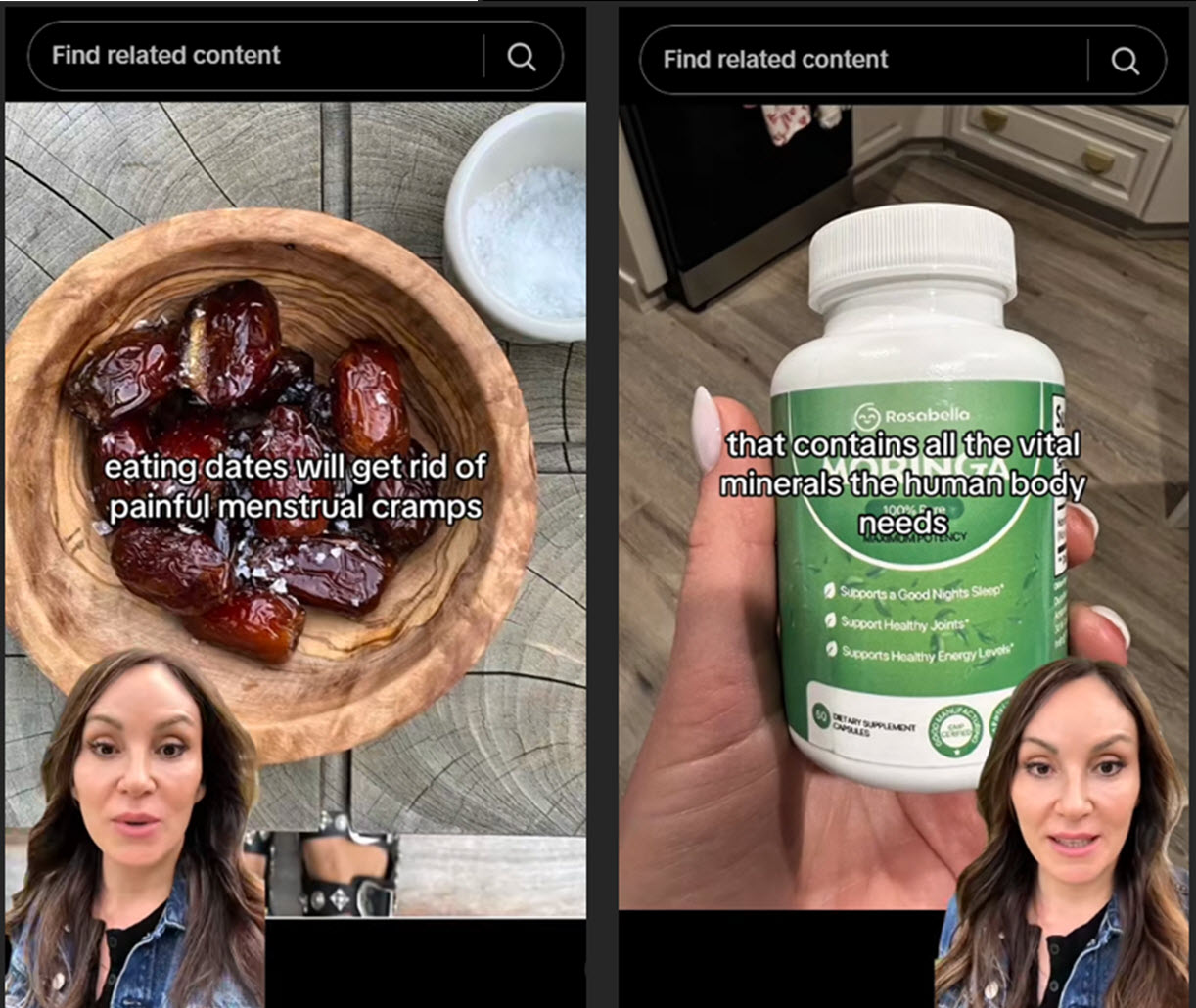

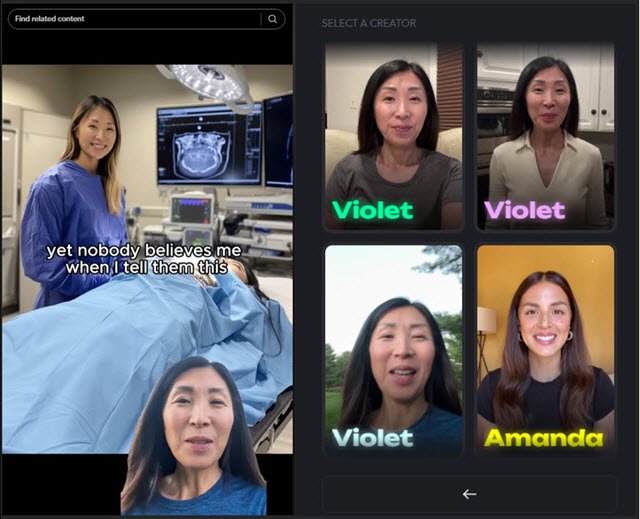

Tiktok ve Instagram gibi sosyal medya platformlarında, DeepFakes’in erişimi, zarar potansiyelleriyle birlikte özellikle şaşırtıcı olabilir. Latin Amerika’daki ESET araştırmacıları kısa süre önce Tiktok ve Instagram’da yapay zeka tarafından üretilen avatarların takviyeler ve sağlıklı yaşam ürünlerini tanıtmak için jinekologlar, diyetisyenler ve diğer sağlık profesyonelleri olarak poz verdiği bir kampanya ile karşılaştı. Genellikle son derece cilalı ve ikna edici olan bu videolar, satış konuşmalarını tıbbi tavsiye olarak gizler, şüpheli ve potansiyel olarak açıkça riskli alımlar yapmaya dikkatsizdir.

Bir aldatma anatomisi

Her video benzer bir senaryoyu takip eder: genellikle ekranın bir köşesine sıkışmış bir konuşan avatar, sağlık veya güzellik ipuçları sunar. Bir otorite havasıyla dağıtılan tavsiye, izleyicileri satışa sunan belirli ürünlere doğru iterek “doğal” ilaçlara büyük ölçüde eğilir. Uzman tavsiyeleri kisvesiyle sahalarını gizleyerek, bu derin yapraklar, etkili olduğu kadar etik olmayan bir taktik olan satışları artırmak için tıp mesleğine olan güvenden yararlanır.

Bir durumda, “Doktor”, Ozempik’e üstün bir alternatif olarak “doğal bir ekstrakt” ı, kilo kaybına yardım etmek için kutladı. Video, dramatik sonuçlar vaat ediyor ve sizi hiper faydalarla hiçbir bağlantı olmadan ürünün “gevşeme düşüşleri” veya “büyüme karşıtı yardımlar” olarak tanımlandığı bir Amazon sayfasına yönlendiriyor.

Diğer videolar, riskleri daha da arttırır, onaylanmamış ilaçları veya ciddi hastalıklar için sahte tedavileri zorlar, hatta bazen gerçek, tanınmış doktorların benzerliğini kaçırır.

AI “kurtarma”

Videolar, herkesin kısa görüntüler göndermesine ve cilalı bir avatara dönüştürmesine izin veren meşru AI araçlarıyla oluşturulur. Bu, çıktılarını ölçeklendirmek isteyen etkileyiciler için bir nimet olmakla birlikte, aynı teknoloji yanıltıcı iddialar ve aldatma için ortak olarak seçilebilir-başka bir deyişle, bir pazarlama hilesi olarak işe yarayabilir, yanlışlıkları yaymak için bir mekanizmaya hızla dönüşür.

Ürünlerini zorlamak için DeepFake doktorlarını kullanarak 20’den fazla Tiktok ve Instagram hesaplarını gördük. Birincisi, kemerinin altında 13 yıllık deneyime sahip bir jinekolog olarak poz vermek, doğrudan uygulamanın avatar kütüphanesine kadar izlendi. Bu kötüye kullanım ortak AI araçlarının hüküm ve koşullarını ihlal etse de, ne kadar kolay silahlandırılabileceklerini de vurgulamaktadır.

Sonuçta, bu değersiz takviyeler hakkında “sadece” olmayabilir. Sonuçlar daha korkunç olabilir, çünkü bu derin hatlar çevrimiçi sağlık tavsiyesine olan güveni aşındırabilir, zararlı “ilaçları” teşvik edebilir ve uygun tedaviyi geciktirebilir.

Sahte doktorları uzak tutmak

Yapay zeka daha erişilebilir hale geldikçe, bu sahte tespit etmek daha zorlaşır ve teknoloji meraklı insanlar için bile daha geniş bir zorluk oluşturur. Bununla birlikte, derin peynir videolarını tespit etmenize yardımcı olabilecek birkaç işaret:

- Sesle senkronize olmayan eşleşmeyen dudak hareketleri veya sert ve doğal olmayan yüz ifadeleri için,

- Bulanık kenarlar veya ani aydınlatma vardiyaları gibi görsel aksaklıklar da genellikle sahte olana ihanet eder,

- Robotik veya aşırı cilalı bir ses başka bir kırmızı bayrak,

- Ayrıca, hesabın kendisini kontrol edin: az sayıda takipçisi olan veya geçmişi olmayan yeni profiller şüphe uyandırır,

- “Mucize Tedaviler”, “Garantili Sonuçlar” ve “Doktorlar bu numaradan nefret” gibi hiperbolik iddialara dikkat edin, özellikle de güvenilir kaynaklardan yoksunlarsa,

- Her zaman güvenilir tıbbi kaynaklarla iddiaları doğrulayın, şüpheli videoları paylaşmaktan kaçının ve yanıltıcı içeriği platforma bildirin.

Yapay zeka araçları ilerlemeye devam ettikçe, otantik ve imal edilmiş içerik arasında ayrım yapmak daha kolay olmaktan çok zorlaşacaktır. Bu tehdit, hem teknolojik önlemlerin geliştirilmesinin hem de bizi sağlık ve finansal refahımızı etkileyebilecek yanlış bilgi ve dolandırıcılıktan korumaya yardımcı olacak kolektif dijital okuryazarlığımızı geliştirmenin öneminin altını çiziyor.