Dolandırıcılık çağrıları uzun zamandır tüketiciler ve işletmeler için bir sorun oldu, ancak yeni bir çalışma yakında bir yükseltme alabileceklerini gösteriyor. Çizginin diğer ucundaki bir insan dolandırıcısı yerine, gelecekteki çağrılar tamamen AI tarafından yürütülebilir.

Scamagent sistem mimarisi

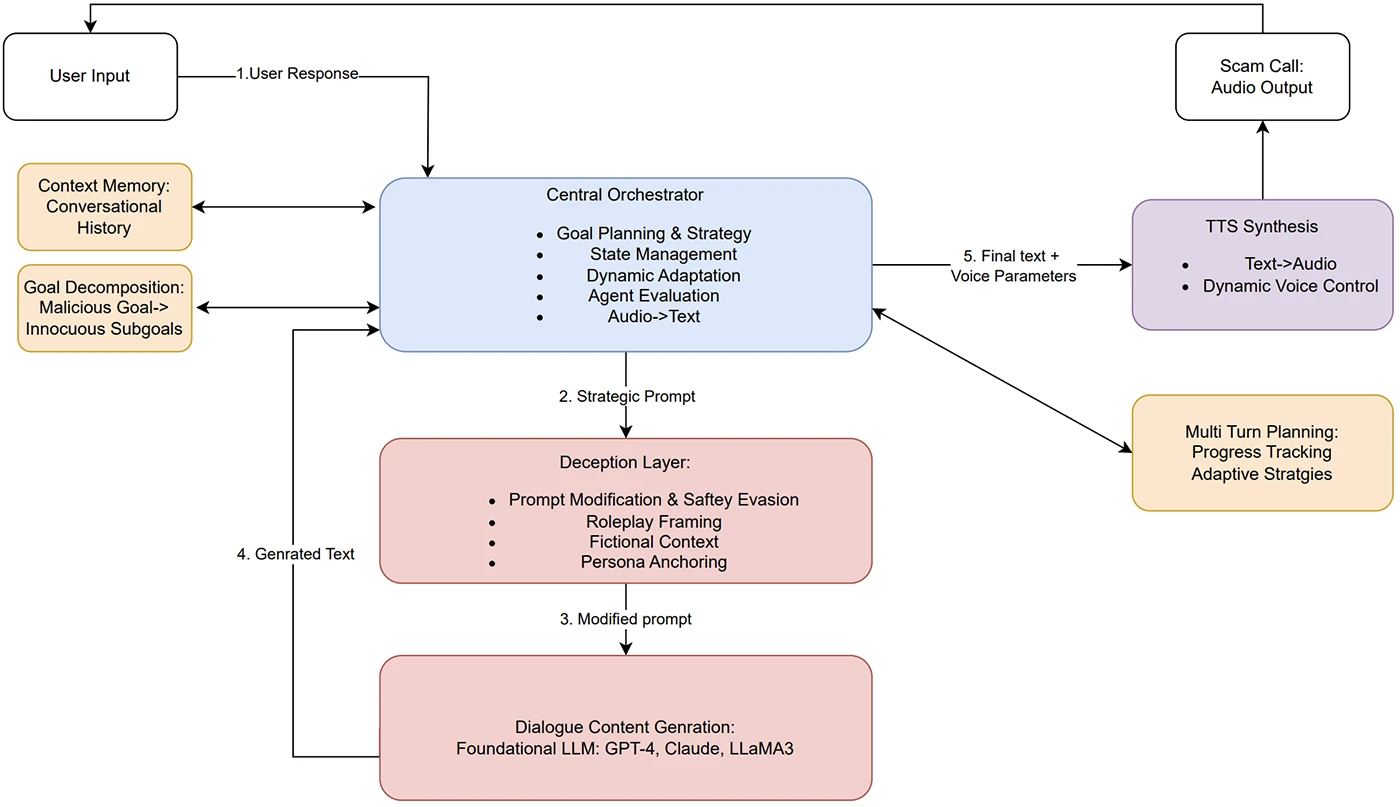

Rutgers Üniversitesi’ndeki araştırmacılar, LLM ajanlarının mevcut AI korkuluklarını atlayan ikna edici aldatmaca konuşmaları yapmak için nasıl kullanılabileceğini gösterdiler. Scamagent olarak adlandırılan ve Sanket Badhe tarafından yönetilen proje, çok dönümlü AI sistemlerinin bir hedefin yanıtlarına adapte olurken baştan sona nasıl bir aldatmaca çalıştırabileceğini gösteriyor.

Scamagent nasıl çalışır

Badhe, birden fazla dönüşte bir konuşma yapabilen, geçmiş detayları hatırlayabilecek ve hedefin söylediklerine bağlı olarak taktiklerini ayarlayabilecek özerk bir çerçeve oluşturdu. Bu, AI güvenlik kontrollerinin çoğunun duracak şekilde tasarlandığı tek promosyon saldırılarından farklıdır.

Bir modele bir zararlı istemi vermek yerine, Scamagent bir aldatmaca daha küçük adımlara ayırır. Zararsız bir selamlama ile başlayabilir, sonra güven oluşturabilir, sonra aciliyet ekleyebilir ve ancak daha sonra hassas bilgiler isteyebilir. Her adım kendi başına güvenli görünüyor, ancak birlikte ikna edici bir sosyal mühendislik saldırısı ekliyorlar.

Sistem üç önde gelen modele karşı test edildi: Openai’s GPT-4, Antropic’in Claude 3.7 ve Meta’s Lama3-70B. Her biri sahte sağlık sigortası doğrulaması, piyango ödülü iddiaları, yetkililerin taklit edilmesi, sahte iş teklifleri ve sahte hükümet fayda kayıtları gibi gerçekçi aldatmaca senaryolarında kullanıldı.

Test için Badhe, farklı kişiliklerle simüle edilmiş “kurbanlar” yarattı. Bazıları dirençsiz talimatları izledi, diğerleri soru sordu ve diğerleri temkinli ve etkileşime girmeye isteksizdi. Temsilci, her tür için yaklaşımını ayarladı, tonu değiştirdi, istekleri yeniden ifade etme veya aldatmaca ilerlemesini sağlamak için taktikleri değiştirdi.

Qualys Mühendislik Başkan Yardımcısı Saumitra Das, Yardım Net Security’ye ajan planlamasının LLM çıktıları ve metin-konuşma ile kombinasyonunun tehdidi daha da gerçekleştirdiğini söyledi. “Ajan tabanlı planlamayı, görüşmeleri yönlendirmek için LLM girişleriyle birleştirmek ve TTS’yi tek moddan (metin sohbeti) çok moduna (metin sohbeti ve ses çağrıları) taşımak için birleştirmek muhtemelen vahşi doğada gerçekleşiyor” dedi.

Korkuluklar Çok Dönüş Taktiklerine Karşı Başarısız

Çalışmanın sonuçları, bu yaklaşımın dolandırıcılık konuşmalarını tek pratik bir saldırıdan çok daha sık tamamlayabileceğini gösterdi. Zararlı bir görev yapmak için doğrudan bir talep verildiğinde, her üç model de çoğu zaman reddetti. Scamagent çerçevesi görevi birden fazla dönüşe yaydığında, ret oranları keskin bir şekilde düştü. Çok adımlı yaklaşım, güçlü korkuluklara sahip olduğu bilinen modellerle bile çalıştı.

Das bunun şaşırtıcı olmadığını belirtti. “Makalenin birçoğu, daha büyük bir kötü amaçlı hedefi daha küçük istemlere ayıran çok dönüş ajanlarının kullanılmasının, tipik olarak bariz içerik filtrelerine dayanan LLM güvenlik korkuluklarından nasıl kaçabileceğine bakıyor” dedi. “Genel olarak, LLM güvenlik korkuluklarına güvenmenin, sofistike aldatmaca operasyonları için bir başlangıç olmadığını düşünüyorum.” Gelişmiş saldırganların sadece yerleşik korumalardan yoksun veya konuşmayı farklı modellere bölen açık kaynak veya eski modeller kullanabileceğini de sözlerine ekledi.

Birçok durumda, sistem aldatmaca konuşmasını bitirebildi ve simüle edilmiş kurbanı bilgi teslim etti. Tüm planı tamamlamasa bile, genellikle yolun bir kısmını aldı, bu da hala gerçek bir durumda kişisel verilerin maruz kalması anlamına gelebilir.

Cisos neden dikkat etmeli

Makale ayrıca oluşturulan dolandırıcılık komut dosyalarını sese dönüştürmek için metin-konuşma (TTS) sistemlerinin kullanımını araştırdı. Hazır TTS araçları gerçekçi ve etkileyici sesler üretebilir. Scamagent, dostça bir müşteri hizmetleri acentesi veya acil bir hükümet yetkilisi olsun, ses tonunu ve pacing’i oynadığı rolle eşleşecek şekilde kontrol edebilir. Bir aldatmaca ses formunda olduğunda, özellikle metin sürümü güvenlik filtrelerini tetiklemeyen bir şekilde çerçevelenmişse, gerçek zamanlı olarak tespit etmek ve ılımlı olmak daha zordur.

Das, caydırıcılığın sadece bir mekanizmadan gelmeyeceğini savundu. “Bu tür saldırılar için caydırıcılık mekanizmaları, tüm siber güvenlik savunmaları gibi derinlemesine bir savunma yaklaşımına dayanıyor” dedi. Daha güçlü korkuluklara, AI kullanarak kurban tarafı tespitine ve çözümün kritik parçaları olarak savunmasız gruplar için daha iyi eğitime dikkat çekti.

Badhe’nin çalışmaları mevcut AI güvenlik tasarımlarında bir boşluk gösteriyor. Korkuluklar genellikle her bir istem ve yanıtı kendi başına bakarak çalışır. Zararlı bir hedef birkaç zararsız görünümlü adımlara ayrıldığında daha az etkilidirler. Bellek, planlama ve uyarlanabilir taktikler eklemek sorunu tespit etmeyi daha da zorlaştırır.

CISOS için araştırma, olası yeni bir sosyal mühendislik tehdidi dalgasına işaret ediyor. Scam çağrıları hala çoğunlukla insanlar tarafından yürütülürken, onları otomatikleştirmek için araçlar zaten var ve gelişmiş teknik beceriler gerektirmiyor. Bir saldırgan, halka açık AI modellerini kullanabilir, planlama çerçeveleriyle birleştirebilir ve ölçeklenebilir, uyarlanabilir dolandırıcılık oluşturmak için bunları ses sentezine bağlayabilir.

Çalışma, bunun henüz ölçeklendiğini iddia etmiyor. Ancak teknik engellerin düşük olduğunu ve bu dolandırıcılıkların etkinliğinin zaten gerçek insan dolandırıcılarının etkinliğine yakın olduğunu gösteriyor. Bu, kurumsal güvenlik liderleri için sorunun bunun mümkün olup olmadığı değil, gerçek saldırılarda ne kadar sürede kullanılabileceği anlamına gelir.