Siber güvenlik araştırmacıları, yapay zeka tedarik zincirinde, saldırganların Microsoft Azure AI Foundry, Google Vertex AI ve binlerce açık kaynaklı proje de dahil olmak üzere büyük bulut platformlarında uzaktan kod yürütülmesini sağlayan kritik bir güvenlik açığı ortaya çıkardılar.

“Model Ad Alanı Yeniden Kullanımı” olarak adlandırılan yeni keşfedilen saldırı yöntemi, AI platformlarının kucaklama yüz ekosistemindeki model tanımlayıcılarını nasıl yönetip güvenle ilgili temel bir kusurdan yararlanıyor.

Güvenlik açığı, modellerin iki parçalı bir adlandırma sözleşmesi kullanılarak tanımlandığı Yüzün Ad alanı yönetim sisteminden kaynaklanmaktadır: Yazar/ModelName.

Kuruluşlar veya yazarlar hesaplarını sarılma yüzünden sildiğinde, benzersiz ad alanları kalıcı olarak ayrılmak yerine mevcut bir havuza geri döner.

Bu, kötü niyetli aktörlerin daha önce kullanılan ad alanlarını kaydetme ve güvenilir adlar altında uzlaşmış modelleri yükleme ve modelleri tek başına adlandıran modelleri etkileyen herhangi bir sistemi etkileme fırsatı yaratır.

Palo Alto Networks analistleri, AI platform güvenlik uygulamalarının kapsamlı bir araştırması sırasında bu tedarik zinciri saldırısı vektörünü belirledi.

.webp)

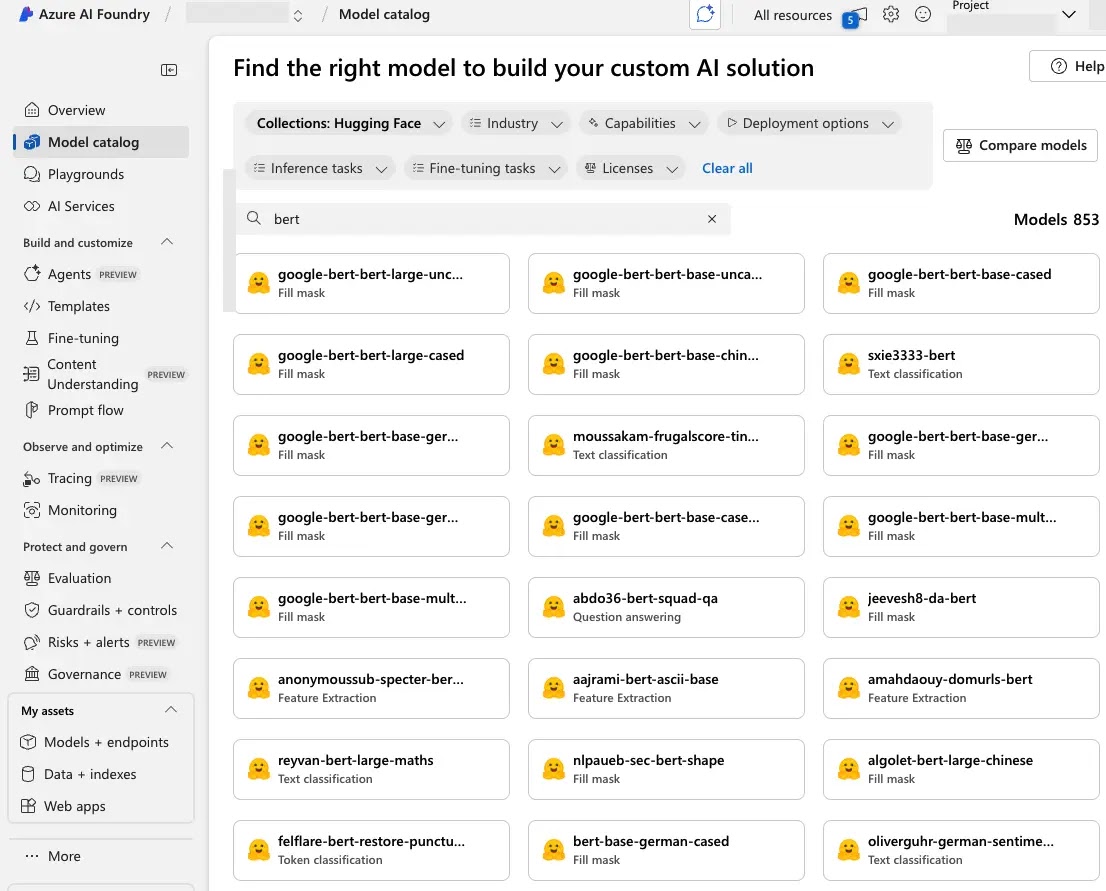

Araştırma, kırılganlığın sadece sarılma yüzü ile doğrudan entegrasyonları değil, aynı zamanda sarılma yüz modellerini kataloglarına dahil eden Major Cloud AI hizmetlerine de yayıldığını ortaya koydu.

.webp)

Saldırının kapsamı, AI modellerinin kurumsal ortamlarda yaygın olarak benimsenmesi ve model adlandırma kurallarına yerleştirilen örtük güven göz önüne alındığında, özellikle ilgilidir.

Saldırı mekanizması iki temel senaryo aracılığıyla çalışır. Birincisi, bir model yazarın hesabı silindiğinde, ad alanı hemen yeniden kayıt için kullanılabilir hale gelir.

İkinci senaryo, modellerin yeni kuruluşlara taşındığı sahiplik transferlerini ve ardından orijinal yazar hesabının silinmesini içerir.

Her iki durumda da, kötü niyetli aktörler, meşru modelleri yerine kötü amaçlı yükler içeren uzlaşmış sürümlerle değiştirecek şekilde ad alanı yeniden kullanımından yararlanabilir.

Teknik uygulama ve saldırı vektörleri

Araştırmacılar, Google Vertex AI ve Microsoft Azure AI Foundry’ye yönelik kontrollü kavram kanıtı saldırıları yoluyla güvenlik açığının pratik etkisini gösterdiler.

.webp)

Testlerinde, terk edilmiş ad alanları ve ters kabuk yükleriyle gömülü yüklenmiş modelleri başarıyla kaydettiler.

Bulut platformları bu görünüşte meşru modelleri dağıttığında, saldırganlara altta yatan altyapıya erişim sağladığında kötü amaçlı kod otomatik olarak yürütüldü.

from transformers import AutoTokenizer, AutoModelForCausalLM

# Vulnerable code pattern found in thousands of repositories

tokenizer = AutoTokenizer.from_pretrained("AIOrg/Translator_v1")

model = AutoModelForCausalLM.from_pretrained("AIOrg/Translator_v1")Saldırının etkinliği, otomatik dağıtım süreçlerinden faydalanmasında yatmaktadır. Vertex AI’s Model Garden veya Azure AI Foundry’nin Model Katalog Referans Modelleri gibi platformlar adına göre, yanlışlıkla kalıcı saldırı yüzeyleri oluştururlar.

Araştırmacılar, Google Cloud platformunda ve Azure ortamlarında yüksek izinleri olan özel kaplara erişim kazandığını ve potansiyel ihlallerin şiddetini gösterdiğini belgelediler.

Kuruluşlar, sürüm sabitleme, revizyon parametresini modelleri belirli taahhütlere kilitlemek ve kritik yapay zeka varlıkları için kontrollü depolama ortamları oluşturarak bu riski azaltabilir.

Keşif, organizasyonlar giderek daha fazla makine öğrenme yeteneklerini üretim sistemlerine entegre ettikçe, AI tedarik zinciri güvenlik açıklarını ele alan kapsamlı güvenlik çerçevelerine acil ihtiyacın altını çiziyor.

Boost your SOC and help your team protect your business with free top-notch threat intelligence: Request TI Lookup Premium Trial.