GenAI, görüntü oluşturmayı basitleştirir ancak fikri mülkiyet, özgünlük ve hesap verebilirlik konusunda zorlu sorunlar yaratır. Kanada’daki Queen’s Üniversitesi’ndeki araştırmacılar, filigranı, yapay zeka görüntülerini etiketlemenin ve böylece köken ve bütünlüğün kontrol edilebilmesinin bir yolu olarak inceledi.

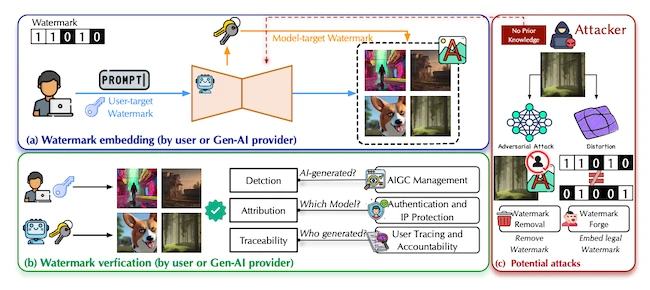

GenAI için filigran senaryosuna genel bakış

Çerçeveyi oluşturmak

Filigranlama sistemi, birkaç temel parçadan oluşan eksiksiz bir güvenlik süreci olarak çalışır: yerleştirme, doğrulama, saldırı kanalları ve tespit. Oluşturulma sırasında veya sonrasında bir görüntünün içine kodlanmış bir mesaj yerleştirildiğinde başlar. Bu sinyal daha sonra çıkarılabilir ve görüntünün nereden geldiğini doğrulamak için bir anahtarla eşleştirilebilir.

Bazı işaretler görüntü tamamlandıktan sonra eklenir, bazıları ise oluşturma sırasında gömülür. İşaret, modelin içine yerleştirildiğinde görüntü oluşturma sürecinin bir parçası haline gelir ve sıkıştırma, kırpma veya genellikle harici işaretleyicileri yok eden diğer küçük düzenlemelerden sağ çıkma şansı artar.

Her sistem kriptografik anahtarlara, yerleştirme prosedürlerine ve istatistiksel kontrollere dayanır. Filigranın izleyiciler tarafından görülmemesi, ancak yetkili kullanıcılar tarafından okunabilmesi gerekir. Sıradan görüntü işleme yoluyla bozulmadan kalmalı ve kimsenin kopyalayamayacağı kadar gizli kalmalıdır.

Anket, filigranı tanımlanmış bir güvenlik süreci olarak görmenin, tıpkı şifreleme veya kimlik doğrulama sistemleri gibi test edilmesine ve geliştirilmesine olanak sağladığını belirtiyor. Bu yapı araştırmacılara güvenilirliği ve izlenebilirliği ölçmek için ortak bir dil sağlar.

Ana tekniklerin karşılaştırılması

Filigranlama, ayrık kosinüs veya dalgacık analizi gibi dönüşümler kullanılarak piksel değerlerini veya frekans katsayılarını değiştiren sinyal işleme yöntemleriyle başladı. Bu tekniklerin uygulanması basitti ancak üretken modellerin görüntü oluşturmasındaki karmaşık yöntemlerle eşleşmedi.

Derin öğrenmenin yükselişi yeni olasılıkları beraberinde getirdi. HiDDeN, RivaGAN ve StegaStamp gibi kodlayıcı-kod çözücü ağları, işaretlerin otomatik olarak nasıl gizleneceğini ve alınacağını öğrendi. Dengeli görünmezlik ve iyileşme eğitimi, bazen gürültüye veya bulanıklığa dayanmayı öğrenmeyle birlikte.

Stabil Difüzyon ve Midjourney gibi yayılma modelleri başka bir değişimi beraberinde getirdi. Araştırmacılar işaretleri doğrudan bu sistemlerin içine yerleştirmeye başladı ve iki ana yaklaşım ürettiler: ince ayar tabanlı ve başlangıçtaki gürültü tabanlı.

Stabil İmza ve WOUAF gibi ince ayar yöntemleri, bir yayılma modelinin bölümlerini değiştirerek ürettiği her resmin bir tanımlayıcı kod taşımasını sağlar. Kod, model oluşturucuya veya belirli bir kullanıcıya işaret edebilir. Bu, fikri mülkiyeti korur ancak büyük modellerin yeniden eğitilmesini gerektirir ve önemli miktarda bilgi işlem kaynağı tüketir.

Başlangıçtaki gürültüye dayalı yöntemler, yayılma modellerinin başlangıç noktası olarak kullandığı rastgele gürültüyü değiştirir. Her görüntü bu gürültüden başlar, dolayısıyla onu ayarlamak, filigranın tüm oluşturma yolu boyunca ilerlemesine olanak tanır. TreeRing, RingID ve PRC önde gelen örneklerdir. TreeRing, frekans alanına dairesel desenler yerleştirirken, PRC, doğal gürültüye benzeyen bir şifreleme kodu kullanır. Bu yaklaşımların uygulanması daha hızlıdır ve yeni zayıflıklar getirse de daha fazla bilgi taşıyabilir.

Sistemlerin test edilmesi

Araştırmacılar filigranı değerlendirmek için üç ana kriter kullanıyor: görsel kalite, kapasite ve tespit edilebilirlik.

Görsel kalite, işaretin resmin kalitesini bozmadığını kontrol eder. Yapısal Benzerlik İndeksi (SSIM) ve Fréchet Başlangıç Mesafesi (FID) gibi ölçümler yaygın olarak kullanılmaktadır. Ses filigranı görünmez kalmalı ve görüntünün görünümünü veya mesajını değiştirmemelidir.

Kapasite ne kadar verinin depolanabileceğini ölçer. Eski teknikler yalnızca birkaç biti gizleyebilirken, PRC gibi yöntemler 2.500 bit’e kadar gömebilir. Bu, tanımlama kodlarına, zaman verilerine veya politika etiketlerine izin verir, ancak ne kadar çok bilgi depolanırsa, işaretin fark edilme veya değiştirilme şansı da o kadar artar.

Tespit edilebilirlik, bir filigranın değişiklik veya saldırı sonrasında ne kadar güvenilir bir şekilde kurtarılabileceğini ifade eder. Sistemler yanlış pozitiflerden ve yanlış negatiflerden kaçınmalıdır. Çok geniş resim kütüphaneleri taranırken küçük bir hata oranı bile ciddi sorunlara neden olabilir. Yanlış sınıflandırmaların önlenmesi için tespit eşiklerinin doğru ayarlanması önemlidir.

Zayıf noktaları ortaya çıkarmak

Birçok filigranlama şeması baskı altında kırılgan kalır. Saldırganlar, gizli deseni kaldırmak için bir görüntüyü başka bir model aracılığıyla kırpabilir, sıkıştırabilir veya yeniden oluşturabilir. Diğerleri, sahiplik iddiasında bulunmak veya sahte güvenilirlik sağlamak için sahte markalar oluşturabilir.

Yazarlar bu tehditleri iki gruba ayırıyor: dayanıklılık ve güvenlik. Dayanıklılık, bir işaretin sıkıştırma veya rastgele gürültü gibi kasıtsız bozulmalara karşı dayanıklı olup olmadığını ölçer. Güvenlik, anahtarların sahteciliği veya çalınması gibi hedefe yönelik eylemlerle ilgilenir. Bir işaret kopyalanabiliyor veya yeniden kullanılabiliyorsa değeri kaybolur.

Yeni saldırı stratejileri, yayılma modellerinin çalışma şeklinden yararlanıyor. Rejenerasyon saldırıları, neredeyse aynı görüntüleri model üzerinden geri çalıştırarak hiçbir iz bırakmadan yeniden oluşturur. Dedektör farkında saldırılar, resmi görsel olarak aynı tutarken doğrulama araçlarını yanıltmak için küçük piksel değişiklikleri kullanır. Bu taktikler, makine öğrenimi güvenliğinin diğer alanlarında görülen rakip teknikleri yansıtıyor.

Savunma fikirleri arasında filigran anahtarlarının şifrelenmesi, işaretlerin yerleştirildiği yerlerin değiştirilmesi ve filigranların oluşturulması sırasında tanınması ve korunması için eğitim modelleri yer alır. Bu önlemler, saldırganlar yöntemlerini uyarlasa bile işareti sağlam tutmayı amaçlamaktadır.

Filigranlı yapay zeka içeriği için küresel ivme artıyor

Filigranlama hem hükümetlerin hem de özel şirketlerin ilgisini çekmektedir. Çin zaten yapay zeka tarafından üretilen materyaller üzerinde not almayı zorunlu kılıyor. AB’nin Yapay Zeka Yasası, makine tarafından okunabilen işaretlere atıfta bulunan şeffaflık kurallarını içerir.

ABD’de Beyaz Saray ve Ulusal Standartlar ve Teknoloji Enstitüsü’nün federal rehberliği gönüllü kullanımı desteklemektedir. Büyük firmalar da denemeler yapıyor. Google’ın SynthID’si görüntü oluşturma sırasında görünmez işaretler yerleştirirken OpenAI, araçlar arasında paylaşılan meta veriler için C2PA çerçevesini destekler.