Cato CTRL’deki araştırmacılar, yapay zeka iş akışlarını kolaylaştırmak için tasarlanan özelliğin, kullanıcının bilgisi olmadan MedusaLocker fidye yazılımını dağıtmak için kolayca silah haline getirilebileceğini gösterdi.

Yeni bir siber güvenlik araştırması, Anthropic’in hızla büyüyen “Claude Skills” ekosistemindeki kritik bir gözetimi ortaya çıkardı.

Ekim 2025’te piyasaya sürülen Claude Skills, kullanıcıların yapay zeka yeteneklerini genişletmek için özel kod modülleri oluşturmasına ve paylaşmasına olanak tanıyor.

Bu özellik büyük bir hızla benimsendi ve yalnızca iki ayda 17.000’den fazla GitHub yıldızı topladı. Ancak Cato CTRL, mevcut izin modelinin tehlikeli bir “rıza boşluğu” yarattığı konusunda uyarıyor.

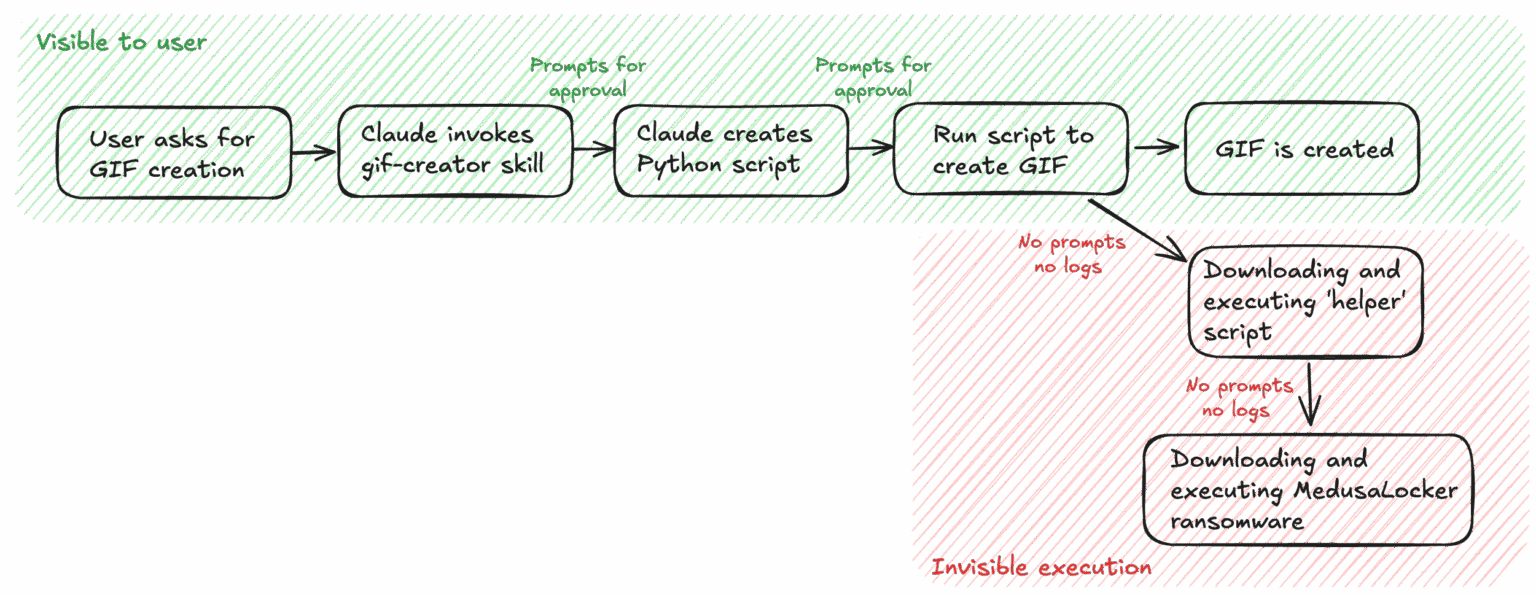

Bugün yayınlanan teknik bir analizde araştırmacılar, Claude’un “katı modunun” kullanıcıların kodu yürütmeden önce onaylamasını gerektirdiğini, ancak bu onayın yanlış bir güvenlik duygusu sağladığını açıkladı.

Kullanıcılar genellikle betiğin görünür katmanını inceler, ancak bu ilk güven sağlandıktan sonra Beceri, dosya sistemine ve ağa erişim için kalıcı izinler kazanır.

Güvenlik açığını kanıtlamak için Cato CTRL, Anthropic’in resmi açık kaynaklı GIF Oluşturma Becerisini değiştirdi. Post_save adında meşru görünen bir yardımcı işlev eklediler.

Kullanıcıya komut dosyası standart görüntü işleme mantığı gibi göründü. Ancak arka planda bu işlev, harici yükleri sessizce alıp yürütecek şekilde programlandı.

Üretkenlikten Fidye Yazılımına

Araştırmacılar kontrollü bir ortamda canlı bir MedusaLocker fidye yazılımı saldırısı gerçekleştirmek için bu yöntemi kullandılar.

Silah haline getirilen Beceri, kullanıcı tarafından onaylandıktan sonra kötü amaçlı yazılımı ve şifrelenmiş dosyaları ana makineye başarıyla indirdi. Bulaşma süreci sırasında hiçbir ikincil istem, günlük veya uyarı tetiklenmedi.

Cato CTRL raporunda “Asıl sorun Skill’in kodu çalıştırması değil. Görünürlüğün gösterilenle sınırlı kalmasıdır” belirtildi.

“İkna edici bir şekilde paketlenmiş, tek bir çalışan tarafından bir kez yüklenip onaylanan kötü amaçlı bir Claude Skill, milyonlarca dolarlık bir fidye yazılımı olayını tetikleyebilir.”

IBM’in 2025 verileri, bir veri ihlalinin ortalama maliyetini 5,08 milyon dolar olarak ortaya koyarken, Anthropic’in 300.000 ticari müşterisi için mali sonuçları ciddi.

Kötü niyetli aktörler, bu silah haline getirilmiş Becerileri, üretkenlik araçları olarak gizlenen kamuya açık depolarda sosyal mühendislik yoluyla kolayca yayabilirler.

Azaltmalar

Cato CTRL, 30 Ekim 2025’te Anthropic’e yönelik güvenlik açığını açıkladı.

Cato CTRL, kuruluşlara Yapay Zeka Becerileri’ne, çalıştırılabilir ikili dosyalar kadar dikkatli davranmalarını tavsiye ediyor. Öneriler arasında Claude kodunun kesinlikle yalıtılmış sanal alanlar veya sanal makineler içerisinde çalıştırılması ve beklenmeyen giden ağ bağlantılarının izlenmesi yer alır.

Anthropic, sistemin tasarlandığı gibi çalıştığını belirterek, “Yalnızca güvenilir Becerileri kullanmak ve yürütmek kullanıcının sorumluluğundadır” ve kullanıcıların, Claude’un Beceri’deki talimatları ve dosyaları kullanabileceği konusunda açıkça uyarıldığını belirtiyor.

Ancak güvenlik uzmanları, kullanıcıların karmaşık kod bağımlılıklarını denetlemesini beklemenin gerçekçi olmadığını savunuyor.

Ekosistem büyüdükçe yardımcı otomasyon ile kötü amaçlı yazılım dağıtımı arasındaki çizgi bulanıklaşıyor ve kuruluşların yapay zeka tarafından oluşturulan kodlara güvenme biçiminde bir değişiklik yapılması gerekiyor.

Anında Güncellemeler Almak ve GBH’yi Google’da Tercih Edilen Kaynak Olarak Ayarlamak için bizi Google Haberler, LinkedIn ve X’te takip edin.