Facebook’ta yıllardır dolaşan bir aldatmacanın yeni versiyonu Instagram’a da sıçradı.

Son birkaç gündür bu gönderiyi Instagram Hikayeleri’nde aniden çok görüyoruz. Gönderi genellikle Instagram Hikayeleri’nde paylaşılabilir bir ekran görüntüsü olarak yayınlanıyor ancak Facebook ve Threads’te kopyala-yapıştır metni olarak da görüldü.

“Cumhuriyet

Hoşça kal Meta AI. Lütfen bir avukatın bunu takmamızı tavsiye ettiğini unutmayın, bunu yapmamak yasal sonuçlara yol açabilir. Meta artık kamusal bir kuruluş olduğundan tüm üyeler benzer bir açıklama yayınlamalıdır. En azından bir kez yayınlamazsanız, bilgilerinizi ve fotoğraflarınızı kullanmalarına izin verdiğiniz varsayılacaktır. Met’e veya başka birine kişisel verilerimi, profil bilgilerimi veya fotoğraflarımı kullanma izni vermiyorum.”

Bu gönderinin bazı ünlüler tarafından paylaşılmış olması, ani popülerliğinin olası bir açıklamasıdır. Ve sıklıkla olduğu gibi, Facebook’un Yapay Zekasını (AI) eğitmek için fotoğrafları kazıdığıyla ilgili gerçek hikayeler, bu tür işe yaramaz bildirimleri yayınlamanın popülerliğini ve aciliyetini yeniden canlandırabilir.

Instagram, gönderinin sürümlerini yanlış bilgi olarak işaretlemeye başladı, bu da insanların gönderiyi görüntülemek için ‘gönderiyi gör’e tıklaması gerektiği anlamına geliyor. Ancak sıklıkla olan şey, birisinin işaretlenmeyecek hafifçe yenilenmiş bir sürümle sıfırdan başlamasıdır.

Bazıları bu gönderileri yalnızca emin olmak için paylaşmanın bir zararı olmayacağını düşünebilir, ancak bu gerçekten iyi bir fikir değildir. Sahte gönderileri daha da yayar ve insanlar bunu yayınladıktan sonra görüntülerinin kullanılmasını devre dışı bıraktıklarını düşünebilirler, ancak gerçekte öyle değildir. Birçok durumda, üzerinde anlaştıkları şartlar ve koşullarla bile çelişir.

Facebook ve Instagram’ın sahibi olan şirket Meta, 26 Haziran 2024’te yürürlüğe giren yeni şartlar ve koşullar yayınladı. Bu şartlar, şirketin LLaMa 3 adlı yapay zeka büyük dil modelini eğitmek için gönderileri, görselleri ve çevrimiçi izleme verilerini kullanmasına izin veriyor.

Bildirimdeki bağlantıların incelenmesi sonucunda şirketin, kişisel verileri herhangi bir kaynaktan toplayabilen ve her türlü bilgiyi tanımlanmamış “üçüncü taraflarla” paylaşabilen bir “yapay zeka teknolojisi” için yıllarca saklanan kişisel paylaşımları, özel görüntüleri veya çevrimiçi izleme verilerini kullanacağı ortaya çıktı.

Avrupa ve İngiltere kullanıcıları bundan vazgeçebilir. Diğerleri için ise ne yazık ki bu o kadar kolay değil.

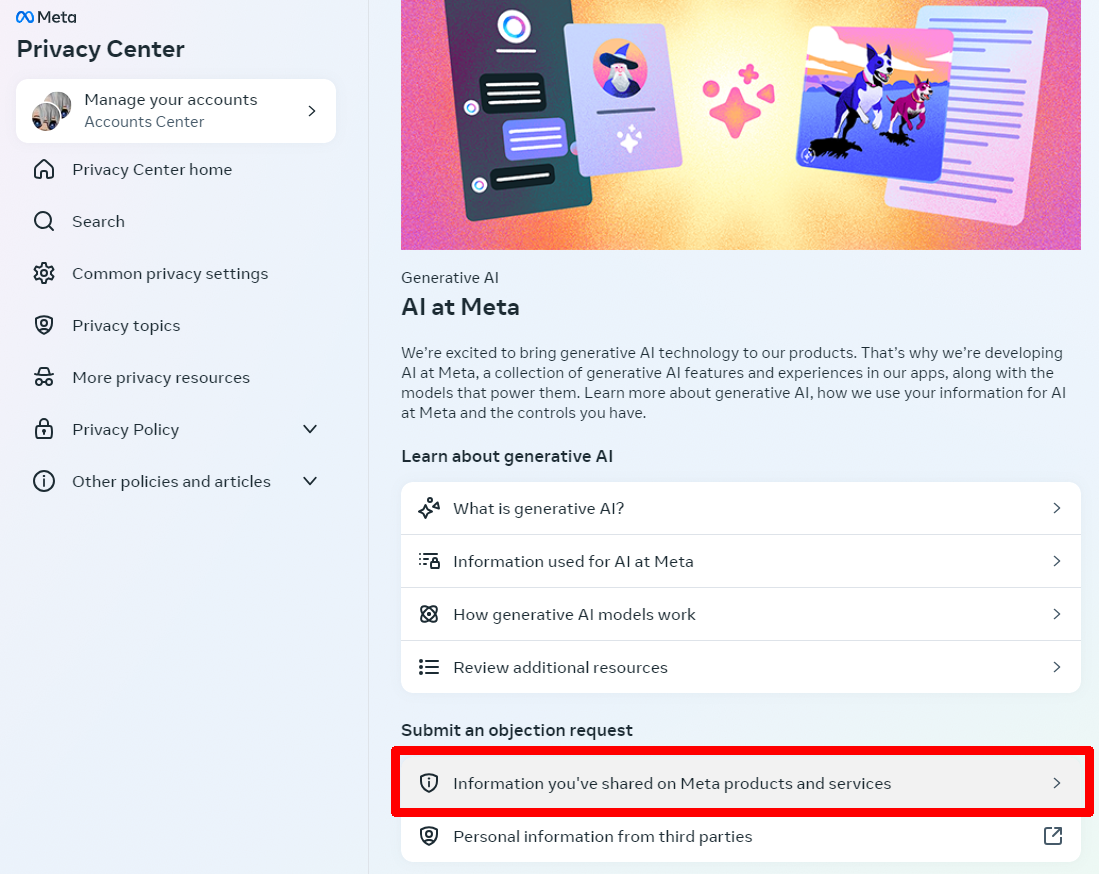

AB ve İngiltere vatandaşları, Meta Gizlilik Merkezi’ni Facebook hesaplarından veya Instagram hesaplarından ziyaret edebilirler.

Meta’nın Facebook’ta AI’yı eğitmek için verilerinizi kullanmasını nasıl devre dışı bırakabilirsiniz?

- Giriş yaptıktan sonra profil resminize dokunun

- Musluk Ayarlar ve Gizlilik

- Aşağı kaydırın Gizlilik Merkezi

- Altında Gizlilik konularımusluk Meta’da Yapay Zeka

- Musluk Meta ürünleri ve hizmetleri hakkında paylaştığınız bilgiler

- Oradan doldurmanız gereken bir form karşınıza çıkacak ve Göndermek bitirdiğinizde.

Meta’nın Instagram’da AI’yı eğitmek için verilerinizi kullanmasını nasıl devre dışı bırakabilirsiniz?

- Profilinizden hamburger menüsüne dokunun (üç üst üste çizgi)

- Aşağı kaydırın Gizlilik Merkezi

- Altında Gizlilik konularımusluk Meta’da Yapay Zeka

- Musluk Meta ürünleri ve hizmetleri hakkında paylaştığınız bilgiler

- Oradan doldurmanız gereken bir form karşınıza çıkacak ve Göndermek bitirdiğinizde.

Facebook veya Instagram’ı kullanarak aboneliğinizi iptal ettiğinizde, isteğinizin başarılı olup olmadığını teyit eden bir e-posta ve hesabınızda bir bildirim almanız gerekir.

ABD’de veya ulusal veri gizliliği yasaları olmayan diğer ülkelerdeki kullanıcıların, Meta’nın verilerini yapay zekayı eğitmek için kullanmasını önleyecek kesin bir yolu bulunmuyor.

Benim tavsiyem: Politikacılarınızın biraz ses çıkarması ve size benzer muafiyet seçenekleri sunması konusunda ısrarcı olun.