Siber güvenlik araştırmacıları, hizmet sağlayıcı olarak yapay zeka (AI) replikasında, tehdit aktörlerinin özel AI modellerine ve hassas bilgilere erişmesine izin verebilecek kritik bir güvenlik açığı keşfettiler.

Bulut güvenlik firması Wiz, bu hafta yayınlanan bir raporda, “Bu güvenlik açığından yararlanılması, Replicate’in tüm platform müşterilerinin AI istemlerine ve sonuçlarına yetkisiz erişime izin verebilirdi.” dedi.

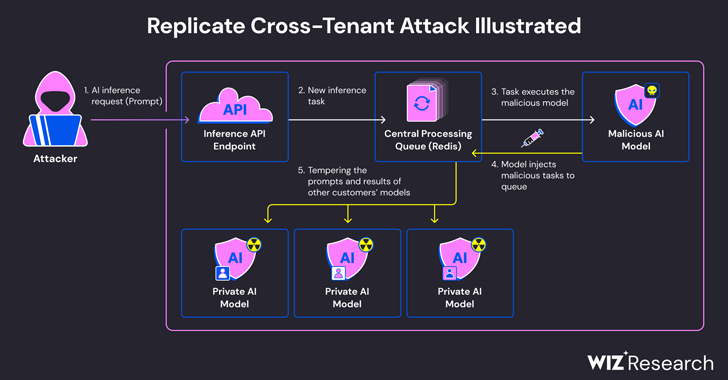

Sorun, yapay zeka modellerinin tipik olarak, bir saldırganın kötü amaçlı bir model aracılığıyla kiracılar arası saldırılar gerçekleştirmek için silah olarak kullanabileceği rastgele kod yürütmeye izin veren formatlarda paketlenmesinden kaynaklanıyor.

Replicate, daha sonra kendi kendine barındırılan bir ortamda veya Replicate için dağıtılabilen makine öğrenimi modellerini kapsayıcı hale getirmek ve paketlemek için Cog adlı açık kaynaklı bir araçtan yararlanır.

Wiz, sahte bir Cog konteyneri oluşturduğunu ve bunu Replicate’e yüklediğini, sonuçta bunu hizmetin altyapısında yükseltilmiş ayrıcalıklarla uzaktan kod yürütmek için kullandığını söyledi.

Güvenlik araştırmacıları Shir Tamari ve Sagi Tzadik, “Bu kod yürütme tekniğinin, şirketlerin ve kuruluşların yapay zeka modellerini güvenilmeyen kaynaklardan çalıştırdığı bir model olduğundan şüpheleniyoruz, ancak bu modeller potansiyel olarak kötü amaçlı kodlar olabilir.” dedi.

Şirket tarafından geliştirilen saldırı tekniği, daha sonra rastgele komutlar eklemek için Google Cloud Platform’da barındırılan Kubernetes kümesindeki bir Redis sunucu örneğiyle ilişkili önceden kurulmuş bir TCP bağlantısından yararlandı.

Dahası, merkezi Redis sunucusunun birden fazla müşteri isteğini ve yanıtlarını yönetmek için bir kuyruk olarak kullanılması nedeniyle, diğer sunucuların sonuçlarını etkileyebilecek sahte görevler eklemek amacıyla sürece müdahale edilerek kiracılar arası saldırıları kolaylaştırmak için kötüye kullanılabilir. müşterilerin modelleri.

Bu hileli manipülasyonlar yalnızca yapay zeka modellerinin bütünlüğünü tehdit etmekle kalmıyor, aynı zamanda yapay zeka destekli çıktıların doğruluğu ve güvenilirliği açısından da önemli riskler oluşturuyor.

Araştırmacılar, “Bir saldırgan, müşterilerin özel yapay zeka modellerini sorgulayarak, potansiyel olarak model eğitim sürecine dahil olan özel bilgileri veya hassas verileri açığa çıkarabilir” dedi. “Ek olarak, istemlerin ele geçirilmesi, kişisel olarak tanımlanabilir bilgiler (PII) dahil olmak üzere hassas verilerin açığa çıkmasına neden olabilir.

Ocak 2024’te sorumlu bir şekilde açıklanan eksiklik, o zamandan beri Replicate tarafından giderildi. Bu güvenlik açığının müşteri verilerinin tehlikeye atılması amacıyla istismar edildiğine dair hiçbir kanıt yok.

Açıklama, Wiz’in Hugging Face gibi platformlarda, tehdit aktörlerinin ayrıcalıkları artırmasına, diğer müşterilerin modellerine kiracılar arası erişim elde etmesine ve hatta sürekli entegrasyon ve sürekli dağıtımı devralmasına olanak verebilecek yamalanmış riskleri ayrıntılı olarak açıklamasından bir aydan biraz daha uzun bir süre sonra geldi. (CI/CD) boru hatları.

Araştırmacılar, “Kötü amaçlı modeller, özellikle hizmet olarak yapay zeka sağlayıcıları için yapay zeka sistemleri için büyük bir risk teşkil ediyor çünkü saldırganlar, kiracılar arası saldırılar gerçekleştirmek için bu modellerden yararlanabilir.”

“Saldırganlar, hizmet olarak yapay zeka sağlayıcılarında depolanan milyonlarca özel yapay zeka modeline ve uygulamasına erişebileceğinden potansiyel etki yıkıcıdır.”