Siber güvenlik araştırmacıları, OpenAI ChatGPT için mevcut olan üçüncü taraf eklentilerin, hassas verilere yetkisiz erişim elde etmek isteyen tehdit aktörleri için yeni bir saldırı yüzeyi görevi görebileceğini keşfetti.

Salt Labs tarafından yayınlanan yeni araştırmaya göre, doğrudan ChatGPT'de ve ekosistemde bulunan güvenlik kusurları, saldırganların kullanıcıların izni olmadan kötü amaçlı eklentiler yüklemesine ve GitHub gibi üçüncü taraf web sitelerindeki hesapları ele geçirmesine olanak tanıyor.

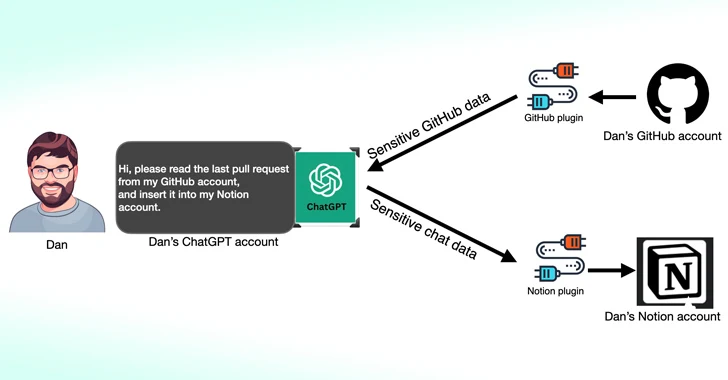

ChatGPT eklentileri, adından da anlaşılacağı gibi, güncel bilgilere erişmek, hesaplamaları yürütmek veya üçüncü taraf hizmetlerine erişmek amacıyla büyük dil modelinin (LLM) üzerinde çalışacak şekilde tasarlanmış araçlardır.

OpenAI, o zamandan beri üçüncü taraf hizmet bağımlılıklarını azaltırken ChatGPT'nin belirli kullanım durumları için özel olarak tasarlanmış versiyonları olan GPT'leri de tanıttı. 19 Mart 2024 itibarıyla ChatGPT kullanıcıları artık yeni eklenti yükleyemeyecek veya mevcut eklentilerle yeni görüşmeler oluşturamayacak.

Salt Labs tarafından ortaya çıkarılan kusurlardan biri, ChatGPT'nin kullanıcının gerçekten eklenti kurulumunu başlattığını doğrulamaması gerçeğinden yararlanarak bir kullanıcıyı isteğe bağlı bir eklenti yüklemesi için kandırmak amacıyla OAuth iş akışının kötüye kullanılmasıdır.

Bu, tehdit aktörlerinin mağdur tarafından paylaşılan ve özel bilgiler içerebilecek tüm verileri etkili bir şekilde ele geçirmesine ve sızdırmasına olanak tanıyabilir.

Siber güvenlik firması ayrıca, PluginLab ile ilgili tehdit aktörleri tarafından sıfır tıklamayla hesap ele geçirme saldırıları gerçekleştirmek üzere silah olarak kullanılabilecek ve bu kişilerin GitHub gibi üçüncü taraf web sitelerindeki bir kuruluşun hesabının kontrolünü ele geçirmelerine ve kaynak kod depolarına erişmelerine olanak tanıyabilecek sorunları da ortaya çıkardı.

“'auth.pluginlab[.]Güvenlik araştırmacısı Aviad Carmel, “ai/oauth/authorized' isteğin kimliğini doğrulamaz, bu da saldırganın başka bir üye kimliğini (diğer adıyla kurban) girip kurbanı temsil eden bir kod alabileceği anlamına gelir,” diye açıkladı güvenlik araştırmacısı Aviad Carmel. “Bu kodla, ChatGPT'yi açın ve kurbanın GitHub'ına erişin.”

Kurbanın üye kimliği “auth.pluginlab” uç noktası sorgulanarak elde edilebilir.[.]ai/members/requestMagicEmailCode.” Bu kusur kullanılarak herhangi bir kullanıcı verisinin tehlikeye atıldığına dair bir kanıt yoktur.

Kesem AI da dahil olmak üzere birçok eklentide, bir saldırganın kurbana özel hazırlanmış bir bağlantı göndererek eklentiyle ilişkili hesap bilgilerini çalmasına olanak tanıyan bir OAuth yönlendirme manipülasyon hatası da keşfedildi.

Bu gelişme, Imperva'nın ChatGPT'de herhangi bir hesabın kontrolünü ele geçirmek için zincirlenebilecek iki siteler arası komut dosyası çalıştırma (XSS) güvenlik açığını ayrıntılı olarak açıklamasından haftalar sonra geldi.

Aralık 2023'te güvenlik araştırmacısı Johann Rehberger, kötü niyetli aktörlerin, kullanıcı kimlik bilgilerini ele geçirebilecek ve çalınan verileri harici bir sunucuya aktarabilecek özel GPT'leri nasıl oluşturabileceğini gösterdi.

Yapay Zeka Asistanlarına Yeni Uzaktan Keylogging Saldırısı

Bulgular ayrıca, web üzerinden AI Asistanlarından şifrelenmiş yanıtlar almak için token uzunluğunu gizli bir araç olarak kullanan bir LLM yan kanal saldırısı hakkında bu hafta yayınlanan yeni araştırmayı da takip ediyor.

Ben-Gurion Üniversitesi ve Offensive AI Araştırma Laboratuvarı'ndan bir grup akademisyen, “LLM'ler, her bir jetonun oluşturulduğu sırada sunucudan kullanıcıya iletildiği bir dizi jeton (kelimelere benzer) halinde yanıtlar üretir ve gönderir.” dedi.

“Bu süreç şifrelenirken, sıralı token iletimi yeni bir yan kanalı açığa çıkarıyor: token uzunluğundaki yan kanal. Şifrelemeye rağmen, paketlerin boyutu tokenların uzunluğunu ortaya çıkarabilir ve potansiyel olarak ağdaki saldırganların çıkarım yapmasına olanak tanıyabilir. Özel AI asistan görüşmelerinde hassas ve gizli bilgiler paylaşılıyor.”

Bu, belirteç uzunluğundaki dizileri doğal dildeki cümle karşılıklarına (yani düz metin) çevirebilen bir LLM modelini eğiterek şifrelenmiş trafikteki yanıtları deşifre etmek için tasarlanmış bir belirteç çıkarım saldırısı aracılığıyla gerçekleştirilir.

Başka bir deyişle, temel fikir, bir LLM sağlayıcısı ile gerçek zamanlı sohbet yanıtlarını engellemek, her bir tokenin uzunluğunu anlamak için ağ paket başlıklarını kullanmak, metin bölümlerini çıkarmak ve ayrıştırmak ve yanıtı çıkarmak için özel LLM'den yararlanmaktır.

Saldırıyı gerçekleştirmenin iki temel ön koşulu, akış modunda çalışan bir AI sohbet istemcisi ve istemci ile AI sohbet robotu arasındaki ağ trafiğini yakalayabilen bir düşmandır.

Yan kanal saldırısının etkinliğini ortadan kaldırmak için, yapay zeka asistanları geliştiren şirketlerin, belirteçlerin gerçek uzunluğunu gizlemek için rastgele dolgu uygulaması, belirteçleri tek tek değil daha büyük gruplar halinde iletmesi ve yanıtların tamamını tek seferde göndermek yerine tek seferde göndermesi önerilir. jetonlu moda.

Araştırmacılar, “Güvenliği kullanılabilirlik ve performansla dengelemek, dikkatli düşünmeyi gerektiren karmaşık bir zorluktur” sonucuna vardı.