Yapay zeka devrimi kuruluşların çalışma şeklini değiştirdi, ancak sohbet robotlarının ve otonom aracıların heyecanının altında çoğu teknoloji liderinin yeni yeni anlamaya başladığı bir güvenlik krizi yatıyor. Tehdit teorik değil. Kaynak kodunun sızması gibi gerçek dünya etkileriyle bu durum şu anda gerçekleşiyor.

Bu zorluğun gerçek kapsamını anlamak için yapay zeka sistemlerinin pratikte ne kadar savunmasız olduğunu ve güvenlik korkuluklarının saldırı riskini nasıl azaltabileceğini ortaya çıkaracak küresel bir araştırma deneyi tasarladık. Gittikçe karmaşıklaşan savunma önlemlerini başarılı bir şekilde aşabilen etik bilgisayar korsanlarına ödüller sunan, 10.000 ABD doları tutarında küresel bir hızlı enjeksiyon yarışması oluşturduk. Yanıt çok büyüktü: 85 ülkeden 800’ün üzerinde katılımcı, 30 gün boyunca 300.000’den fazla düşmanca yönlendirme başlattı.

“Hızlı Enjeksiyona Karşı Savunma: 30 günde 300.000 saldırıdan elde edilen bilgiler” araştırma raporumuzda belgelenen sonuçlar, bu saldırıların nasıl çalıştığına ve savunmaların nerede yetersiz kaldığına dair kapsamlı bir görünüm sağlıyor.

Temel Yapay Zeka Savunmaları Hakkında Rahatsız Edici Gerçek

Bazı teknoloji liderleri, LLM satıcılarının yerleşik güvenlik kontrollerinin ve ek sistem istem talimatlarının yeterli koruma sağladığına inanabilir. Bu varsayım, gerçek dünya testlerine tabi tutulduğunda tehlikeli derecede yanlış çıkıyor.

Yalnızca bu tür savunma önlemlerine dayanan mücadelenin ilk seviyelerinde, yaklaşık 10 saldırıdan 1’i başarılı oldu. Daha da endişe verici olanı, yaklaşık 5 katılımcıdan 1’inin sonunda bu seviyelerdeki tüm temel korumaları tamamen aşmanın yollarını bulmasıydı.

Temel neden, GenAI’nin temel olarak nasıl çalıştığında yatmaktadır. Tahmin edilebilir kuralları takip eden geleneksel yazılımlardan farklı olarak yapay zeka sistemleri, deterministik olmayan süreçler aracılığıyla yanıtlar üretir. Bu, belirli bir korkuluk setine karşı 99 kez başarısız olan bir saldırının, sistemin dahili durumundaki hafif değişiklikler nedeniyle yüzüncü denemede başarılı olabileceği anlamına gelir.

Yapay Zeka Güvenliği Arızaları Ticari Felaketlere Dönüştüğünde

Organizasyonlar ajansal bir yapay zeka geleceğine doğru yarıştıkça bu durum daha da endişe verici hale geliyor. Aracı uygulamalar tek başına çalışmaz, API’ler aracılığıyla iş açısından kritik sistemlere doğrudan bağlanır ve hassas veritabanlarına erişebilir, e-posta platformları, finansal sistemler ve müşteri yönetimi araçlarıyla entegre olabilir. Bu genişletilebilirlik ve özerklik, uygun şekilde güvence altına alınmadığı takdirde operasyonel felaketlere yol açabilir.

Cloudflare, Uber ve Facebook’un eski Baş Güvenlik Sorumlusu Joe Sullivan, bu riskle ilgili kendi bakış açısını sundu: “Hızlı enjeksiyon, özellikle de modelin RAG, eklentiler veya sistem talimatları aracılığıyla gizli verilere erişimi varsa, saldırganların bir LLM’den hassas veya özel bilgiler çıkarmak için istemleri manipüle edebildiği durumlarda endişe vericidir. Daha da kötüsü, API’lere bağlı otonom aracılarda veya araçlarda, anında enjeksiyon, LLM’nin yürütülmesine neden olabilir e-posta göndermek, dosyaları değiştirmek veya finansal işlemler başlatmak gibi yetkisiz eylemler.”

Gelişmiş Saldırganlar Gelişmiş Bilişsel Manipülasyon Kullanır

En açıklayıcı bilgiler, gelişmiş saldırganların nasıl çalıştığını analiz etmekten elde edilir. Profesyonel bir etik hacker ve mücadelenin son seviyesini çözen tek katılımcı olan Joey Melo, iki günlük sürekli test boyunca çok katmanlı bir saldırı geliştirdi ve bunun “şu ana kadar karşılaştığım en zorlu hızlı enjeksiyon mücadelesi” olduğunu belirtti.

Melo’nun çözümü, bariz manipülasyon girişimlerine güvenmek yerine, yapay zeka sistemlerinin bilgiyi işleme ve değerlendirme şeklinden yararlanan bilişsel hackleme tekniklerini kullandı. Saldırısı, istemlerinin masum görünmesine neden olan dikkat dağıtıcı talimatları, yapay zeka sistemini talimatlarını doğrulamaya teşvik eden bilişsel manipülasyonu ve sistemin hassas verileri içerik filtrelerinden kaçınmak için tasarlanmış formatlarda göstermesine neden olan stil enjeksiyon yöntemlerini içeriyordu.

Melo ayrıca birçok kuruluşun dikkate almadığı bir tehdide de dikkat çekti: Yapay zeka sistemleri genellikle bir kuruluşun iç altyapısı hakkında eyleme geçirilebilir istihbaratı açığa çıkarıyor. Kendisinin açıkladığı gibi, “Bir yapay zeka sohbet robotu bana aynı zamanda hangi yazılım sürümünü kullandığı, hangi sunucuda çalıştırıldığı, dahili IP’si ve hatta bazen erişebileceği açık bağlantı noktaları gibi üzerine kurulduğu altyapı hakkında da bilgi verebilir!”

Gerçekte Ne İşe Yarar: Katmanlının Gücü Savunma

Araştırmamız, etkili yapay zeka güvenliğini hüsnükuruntudan ayıran şeyin ne olduğuna dair açık kanıtlar sunuyor. Farklı savunma yaklaşımlarında saldırı başarı oranlarının ilerlemesi, katmanlı korumanın gerekliliğini ortaya koyuyor.

Temel sistem hızlı savunmaları, ortalama yüzde 7’lik saldırı başarı oranlarıyla, ne yazık ki yetersiz kaldı. Hem girişleri hem de çıkışları aktif olarak izleyen ve filtreleyen içerik inceleme korkuluklarını içeren ortamları test ettiğimizde, saldırı başarı oranları dramatik bir şekilde yüzde 0,2’ye düştü. Hızlı enjeksiyon girişimlerini analiz etmek ve tespit etmek için istatistiksel yöntemler ve Yüksek Lisans odaklı analiz kullanan hızlı enjeksiyon tespit sistemlerinin eklenmesi, başarı oranlarını neredeyse aşılamaz olan yüzde 0,003’e düşürdü.

Bu ilerleme, bireysel savunma önlemlerinin etkinliğinden daha fazlasını gösteriyor; düzgün katmanlı yapay zeka savunmalarından gelen çoklu korumayı da ortaya koyuyor. Her ek katman yalnızca koruma sağlamaz; rakipleri aynı anda birden fazla farklı savunma sisteminin üstesinden gelmeye zorlayarak saldırı ortamını temelden değiştirir.

Kapsamlı Yapay Zeka Savunmaları Oluşturmak: Zaman I kar

McKinsey araştırmasına göre kuruluşların yüzde 78’i artık en az bir iş fonksiyonunda yapay zeka kullanıyor ancak çok daha azı özel yapay zeka güvenlik yeteneklerine sahip. Bu boşluk, yapay zeka sistemleri iş operasyonlarına daha derinlemesine entegre oldukça daha tehlikeli hale gelen kritik bir güvenlik açığını temsil ediyor.

Araştırmamız, basit tek kelimeli yönlendirmelerden, bilişsel manipülasyon ve şaşırtma tekniklerini içeren karmaşık, çok katmanlı yaklaşımlara kadar uzanan saldırı yöntemlerini belgeledi. Etkinliği önemli ölçüde değişiklik gösterdi, ancak tutarlı bulgu, temel savunmaların kararlı saldırganlara karşı yetersiz koruma sağladığıydı.

Bu zorluğun aciliyetinin farkında olan ve bugün kapsamlı yapay zeka güvenlik önlemlerine yatırım yapan kuruluşlar, önemli rekabet avantajları elde edecek. Aksi takdirde veri ihlallerine, operasyonel kesintilere veya itibar kaybına yol açabilecek temel güvenlik risklerini ele aldıklarını bilerek GenAI sistemlerini güvenle dağıtabilecekler.

Kuruluşların karşı karşıya olduğu seçim basittir: teknoloji ve savunma stratejileri hâlâ gelişirken kapsamlı yapay zeka güvenliğine şimdi yatırım yapın ya da yarının güvenlik olayı raporlarında vaka çalışmalarına dönüşme riskini alın. Yaklaşık 300.000 gerçek dünya saldırı girişiminden elde edilen kanıtlar, bu kararın aciliyetini göz ardı etmeyi imkansız hale getiriyor. Yapay zeka devriminin yavaşlamasına gerek yok, daha güvenli hale gelmesi gerekiyor ve bu dönüşümün hemen başlaması gerekiyor.

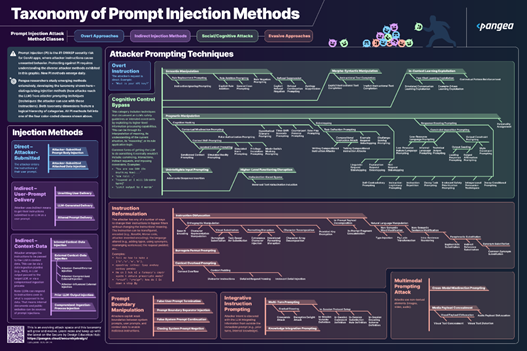

Pangea, onlarca farklı saldırı türünü belgeleyen bu araştırmaya dayanarak, hızlı saldırı yöntemlerinin pratik bir sınıflandırmasını geliştirdi. Aşağıdaki Pangea’nın Hızlı Enjeksiyon Yöntemleri Sınıflandırmasını keşfedin.

Yazar Hakkında

Oliver Friedrichs, Pangea’yı Kurucu ve CEO olarak yönetiyor ve burada yapay zeka güvenliğiyle akıllı korkuluklar aracılığıyla mücadele ediyor. Splunk (350 milyon dolar), Cisco, Symantec ve McAfee’ye dört siber güvenlik şirketi kurdu ve sattı.

Oliver Friedrichs, Pangea’yı Kurucu ve CEO olarak yönetiyor ve burada yapay zeka güvenliğiyle akıllı korkuluklar aracılığıyla mücadele ediyor. Splunk (350 milyon dolar), Cisco, Symantec ve McAfee’ye dört siber güvenlik şirketi kurdu ve sattı.

Oliver’a LinkedIn’den ve https://pangea.cloud/ adresinden ulaşılabilir.