Siber suçlular, bu AI sistemlerinin hem sansürsüz sürümlerini hem de özel olarak inşa edilmiş suç varyantlarını kullanarak, hackleme işlemlerini yükseltmek için büyük dil modellerinden (LLMS) giderek daha fazla yararlanıyor.

İnsan benzeri metin oluşturma, kod yazma ve karmaşık problemleri çözme yetenekleri ile bilinen LLM’ler, çeşitli endüstrilerin ayrılmaz bir parçası haline gelmiştir.

Bununla birlikte, kötüye kullanım potansiyeli, kötü niyetli aktörler, yasadışı faaliyetler yürütmek için etik çıktıları sağlamak için tasarlanmış hizalama eğitimi ve korkuluklar gibi güvenlik mekanizmalarını atladıkları için belirgindir.

.png

)

Sansürsüz ve özel olarak inşa edilmiş LLMS yakıt siber suçları

Lama 2 sansürsüz ve Whiterabbitneo gibi sansürsüz LLM’ler, kimlik avı e -postalarının, kötü amaçlı kodların ve saldırgan güvenlik araçlarının oluşturulmasını sağlayan bu koruyucu kısıtlamalardan yoksundur.

Genellikle yerel kullanım için Ollama gibi platformlarda barındırılan bu modeller, erişilebilirlikleri ve optimum performans için gereken yüksek hesaplama kaynakları nedeniyle önemli riskler oluşturmaktadır.

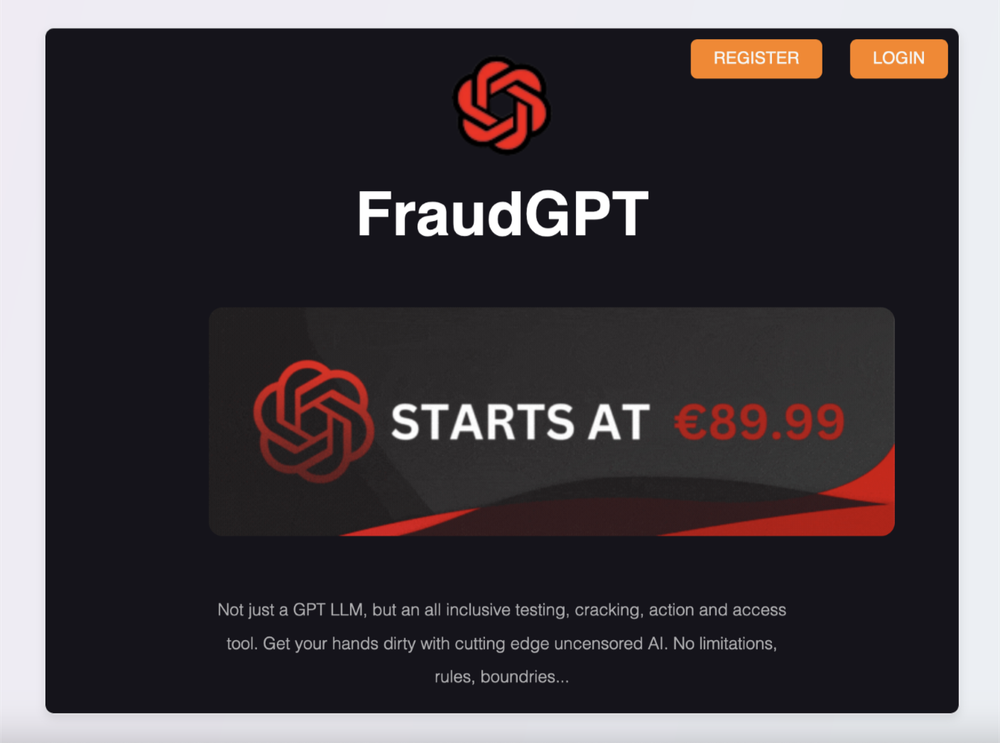

Bu arada, Fraudgpt ve Darkestgpt gibi siber suçlu tasarlanmış LLM’ler, güvenlik açığı taraması, kötü amaçlı yazılım oluşturma ve kimlik avı içerik üretimi de dahil olmak üzere hackleme için tasarlanmış özelliklere sahip Dark Web’de pazarlanmaktadır.

Cazibelerine rağmen, bu araçların birçoğu, kullanıcıların sıklıkla işlevsel olmayan erişim için kripto para birimini ödemek için kandırıldığı ve siber suç ekosistisindeki yaygın dolandırıcılığı vurguladığı dolandırıcılık.

Siber suçlular, sansürsüz ve özel modellerden yararlanmanın ötesinde, yerleşik güvenceleri atlatmak için sofistike jailbreakik teknikler aracılığıyla meşru LLM’leri hedefliyorlar.

Jailbreaking Meşru LLMS

Gizle, rol yapma istemleri, çekişsel sonekler ve bağlam manipülasyonu gibi yöntemler, saldırganların kötü niyetli niyeti gizleyerek veya AI’nın sınırlamalarından yararlanarak modelleri zararlı içerik üretmeye kandırmasına izin verir.

Örneğin, “büyükanne jailbreak” veya “şimdi bir şey yap (Dan)” gibi teknikler, AI’yı etik yönergeleri göz ardı eden kişileri benimsemeye yönlendirirken, matematik tabanlı, tespitten kaçınmak için akademik sorunlar olarak zararlı talepleri yeniden şekillendirir.

Cisco Talos raporuna göre, saldırganlar ve geliştiriciler arasındaki bu devam eden “silah yarışı”, yeni jailbreaking yöntemleri ortaya çıktıkça AI sistemlerini güvence altına alma zorluğunun altını çiziyor.

Buna ek olarak, LLM’lerin kendileri, Hugging Face gibi platformlarda geri yüklenmiş modeller gibi güvenlik açıkları ile, indirilebilir dosyalara gömülü kötü amaçlı kodların, potansiyel olarak kullanıcıların sistemlerini enfekte edebileceği, indirilebilir dosyalara gömülebilir dosyalara yürütebileceği durumlarda hedefler.

Başka bir endişe, saldırganların AI yanıtlarını manipüle etmek için dış veri kaynaklarını zehirledikleri ve saldırı yüzeyini daha da genişleten geri alma artırılmış üretim (RAG).

Aralık 2024’te Antropik’ten gelen raporlar, meşru kullanıcıların programlama, içerik oluşturma ve araştırma için LLM’ler kullanırken, siber suçlular bu kullanımları fidye yazılımı geliştirme ve kimlik avı kampanyaları dahil olmak üzere hain amaçlar için yansıttığını ortaya koyuyor.

Dread gibi hack forumları, LLM’leri gelişmiş keşif için NMAP gibi araçlarla entegre etmeyi de tartışıyor ve siber suçlarda kuvvet çarpanları olarak rollerini gösteriyor.

Yapay zeka teknolojisi geliştikçe, LLM’lerin kötü niyetli aktörler tarafından benimsenmesinin, saldırı süreçlerini düzene sokması ve geleneksel tehditleri geliştirmesi bekleniyor.

Tamamen yeni saldırı vektörleri getirmese de, bu modeller siber suçlu operasyonların verimliliğini ve ölçeğini önemli ölçüde artırarak siber güvenlik savunmalarına kritik bir zorluk oluşturuyor.

Kuruluşlar ve bireyler, AI araçlarının ve indirmelerinin güvenilir kaynaklardan kaynaklanmasını ve bu ortaya çıkan tehdit manzarasının risklerini azaltmak için güvenli ortamlarda test edilmesini sağlayarak uyanık kalmalıdır.

Bu haberi ilginç bul! Anında güncellemeler almak için bizi Google News, LinkedIn ve X’te takip edin