Yasal güvenlik, AI Güvenlik Komuta Merkezi’ni güncelledi. Vibe kodlama ve AI ilk geliştirme yazılımın nasıl oluşturulduğunu yeniden şekillendirirken, komut merkezi, ilişkili AI riskleri ile birlikte yazılım geliştirme yaşam döngüsü (SDLC) boyunca ne zaman, nerede ve AI tarafından oluşturulan kod, AI modelleri ve MCP sunucularının nasıl kullanıldığı konusunda görünürlük sunar.

Vibe kodlama ve AI kod asistanları, geliştiricilerin kod vermelerini sağlar. Ancak hız ile risk gelir: AI tarafından üretilen kod genellikle tüm uygulamayı etkileyen güvenlik açıkları ve sorunlar içerir. Buna ek olarak, mühendisler, bilinmeyen eğitim verileri veya güvenlik korkuluklarının eksikliği nedeniyle önemli risk oluşturan kurumsal politika dışındaki onaylanmamış veya düşük geri alınan AI modellerinden yararlanabilirler.

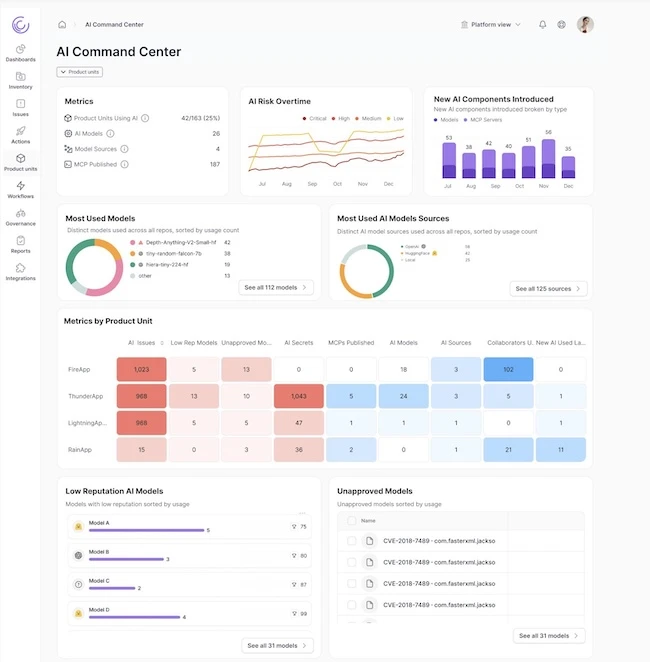

AI Güvenlik Komuta Merkezi, CISO’lar, APPSEC ekipleri ve ürün güvenlik ekiplerinin zaman içinde riski anlamasına ve uygulamalardaki AI güvenlik duruşlarını karşılaştırmasına izin veren AI ile ilgili risk ve metriklerin merkezi bir görünümünü sunar.

Legal’in AI Güvenlik Komuta Merkezi’ndeki temel özellikler ve yetenekler şunları içerir:

- AI kullanımına tam görünürlük: Kullanıcılar, Mühendislik ortamlarında AI modellerini ve MCP sunucularını ve düzeltilmesi gereken risk alanlarını anında görürler. Platform ayrıca yeni tanıtılan bileşenleri vurgular, en sık kullanılan modelleri izler ve bu görünümü her AI modelinin itibarının bağlamıyla zenginleştirir.

- Riskli ve yetkisiz AI model kullanımının tespiti: Düşük alıntılama AI modelleri veya kurumsal politika tarafından onaylanmayanlar, özellikle güvensiz kod tabanları konusunda eğitilmişlerse veya güvenlik korkuluklarından yoksunlarsa, risk tanıtmak için önemli bir fırsat yaratır. Bir mühendis güvenlik süreçlerini ve politikalarını atlamaya çalışsa bile, AI Güvenlik Komuta Merkezi, kullanımda olan modellerin derhal bir görünümünü sunar.

- Yapay zeka ile ilgili risklere gerçek zamanlı görünürlük: Yapay zekanın kullanılmasının ötesinde, yasal AI ile ilgili riskleri gerçek zamanlı olarak izler, en riskli AI sırları, politika ile en iyi AI riski ve AI riskindeki değişim zaman içinde değişir. Güvenlik ekipleri için bu, AI’nın kuruluşun güvenlik duruşu üzerindeki etkisini anlamak ve iletmek için net bir mekanizma sağlar.

- Takım ve uygulama düzeyinde risk metrikleri: AI kullanımı hızlanırken, geliştiricilerin bu araçlardaki uzmanlığı sınırlı olabilir. Yasal’ın yeni AI Heat haritası, en fazla AI güvenlik sorunlarını tanıtan ekipleri tespit etmeyi ve AI güvenliğini uygulama ekipleri arasında karşılaştırmayı kolaylaştırarak en çok eğitim veya diğer desteğin gerekli olduğunu belirlemeyi kolaylaştırır.

“2025, geliştiricilerin kodunda büyük bir değişim getirdi. AI Tools, uygulama ekiplerinin sunmasını daha hızlı hale getirdi, ancak birçok şirketin güvenlik risk seviyelerini artırdı” dedi. “Yapay zeka neredeyse her gelişim alanında yaygınlaştıkça, güvenlik ekiplerinin görünürlük ve sağlam bir risk anlayışından yoksun olduğunu sürekli olarak duyuyoruz. Bu son sürümün çok önemli bir uygulama boşluğunu doldurduğunu görmekten heyecan duyuyoruz.”