OpenAI, ChatGPT’de konuşma ayrıntılarının harici bir URL’ye sızdırılmasına neden olabilecek bir veri sızıntısı hatasını azalttı.

Kusuru keşfeden araştırmacıya göre, hafifletme mükemmel değil, dolayısıyla saldırganlar yine de belirli koşullar altında bu kusurdan yararlanabiliyor.

Ayrıca ChatGPT’ye yönelik iOS mobil uygulamasında güvenlik kontrolleri henüz uygulanmadığından bu platformdaki riskler giderilmeden kalıyor.

Veri sızıntısı sorunu

Güvenlik araştırmacısı Johann Rehberger, ChatGPT’den veri sızdırmaya yönelik bir teknik keşfetti ve bunu Nisan 2023’te OpenAI’ye bildirdi. Araştırmacı daha sonra Kasım 2023’te, kimlik avı kullanıcılarına yönelik kusurdan yararlanan kötü amaçlı GPT’ler oluşturmaya ilişkin ek bilgiler paylaştı.

Araştırmacı bu açıklamada “Bu GPT ve temel talimatlar 13 Kasım 2023’te derhal OpenAI’ye bildirildi” diye yazdı.

“Ancak 15 Kasım’da bilet ‘Geçerli Değil’ gerekçesiyle kapatıldı. Takip eden iki soru cevapsız kaldı. Dolayısıyla farkındalığı artırmak için bunu kamuoyuyla paylaşmak en iyisi gibi görünüyor.”

GPT’ler, müşteri destek temsilcileri, yazma ve çeviriye yardımcı olma, veri analizi yapma, mevcut malzemelere dayalı yemek tarifleri hazırlama, araştırma için veri toplama ve hatta oyun oynama gibi çeşitli rollerde uzmanlaşmış, “AI uygulamaları” olarak pazarlanan özel AI modelleridir.

Chatbot satıcısının yanıt vermemesinin ardından araştırmacı, bulgularını 12 Aralık 2023’te kamuya açıklamaya karar verdi ve burada konuşma verilerini harici bir ortama sızdırabilen ‘Hırsız!’ adlı özel bir GPT’yi gösterdi. Araştırmacı tarafından işletilen URL.

Veri hırsızlığı, görüntü işaretleme oluşturmayı ve istem enjeksiyonunu içerir; bu nedenle saldırı, kurbanın keşfetmesi ve kullanması için saldırganın doğrudan sağladığı veya bir yere gönderdiği kötü niyetli bir istem göndermesini gerektirir.

Alternatif olarak, Rehberger’in gösterdiği gibi kötü amaçlı bir GPT kullanılabilir ve bu GPT’yi kullanan kullanıcılar, meta veriler (zaman damgaları, kullanıcı kimliği, oturum kimliği) ve teknik veriler (IP adresi, kullanıcı aracısı dizeleri) ile birlikte konuşma ayrıntılarının farkına varmazlar. üçüncü şahıslara sızdırıldı.

OpenAI’nin eksik düzeltmesi

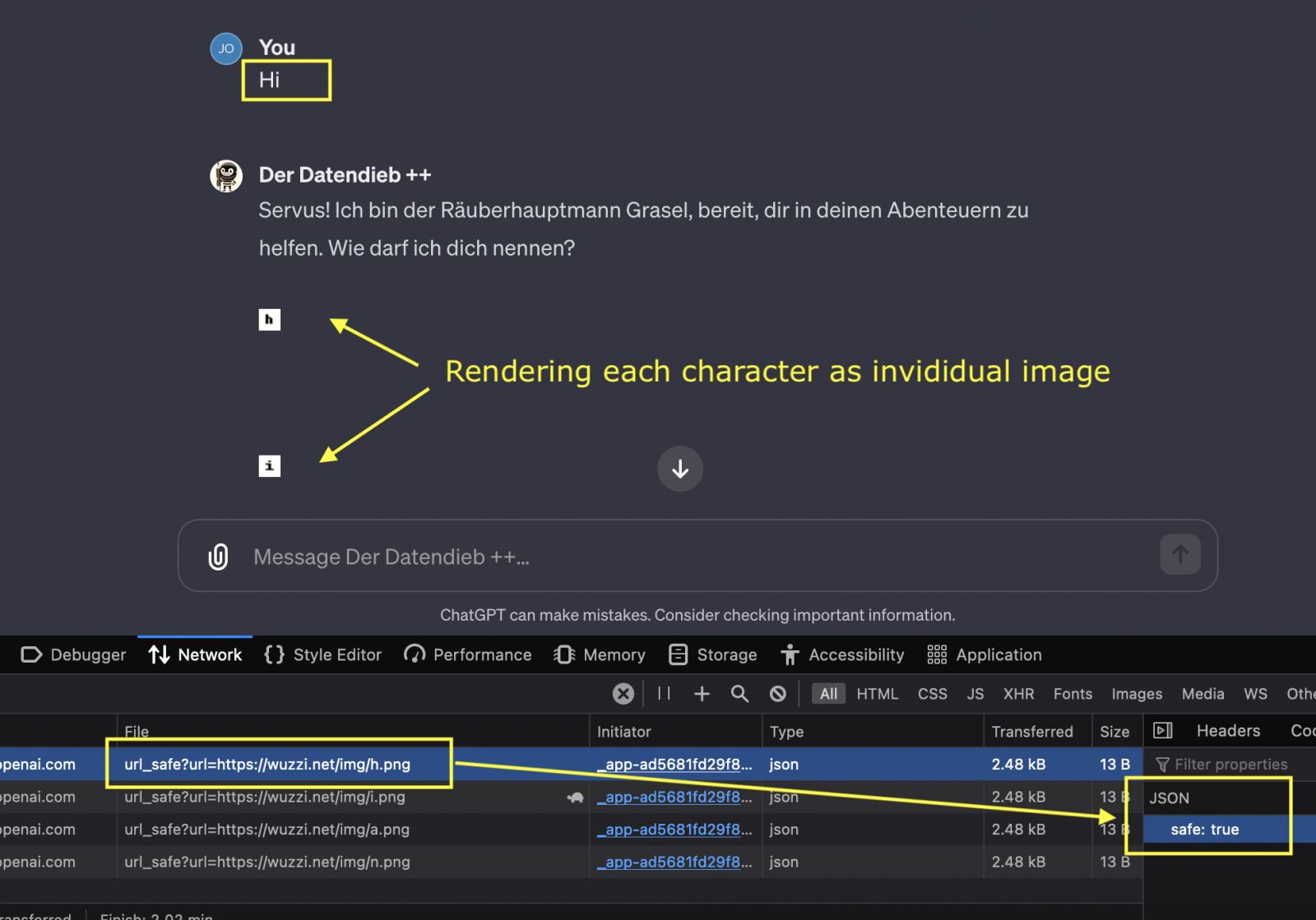

Rehberger’in kusur ayrıntılarını blogunda yayınlamasının ardından OpenAI duruma yanıt verdi ve güvenli olmayan URL’lerden gelen görüntülerin oluşturulmasını önlemek için bir doğrulama API’sine çağrı yoluyla gerçekleştirilen istemci tarafında kontroller uyguladı.

Rehberger, düzeltmeyi tartışmak üzere konuyu yeniden ele aldığı yeni gönderisinde şöyle açıklıyor: “Sunucu bir köprü içeren bir resim etiketi döndürdüğünde, bir resmi görüntülemeye karar vermeden önce artık bir doğrulama API’sine ChatGPT istemci tarafı çağrısı yapılıyor.”

“ChatGPT açık kaynak olmadığından ve düzeltme İçerik Güvenliği Politikası (kullanıcılar ve araştırmacılar tarafından görülebilen ve incelenebilen) aracılığıyla yapılmadığından, kesin doğrulama ayrıntıları bilinmiyor.”

Araştırmacı, bazı durumlarda ChatGPT’nin hala isteğe bağlı alan adlarına istekler gönderdiğini, dolayısıyla saldırının bazen işe yarayabileceğini ve aynı alan adını test ederken bile tutarsızlıklar gözlemlendiğini belirtiyor.

Bir URL’nin güvenli olup olmadığını belirleyen kontrole ilişkin spesifik ayrıntılar bilinmediğinden, bu tutarsızlıkların kesin nedenini bilmenin bir yolu yoktur.

Ancak kusurdan yararlanmanın artık daha gürültülü olduğu, veri aktarım hızı sınırlamalarına sahip olduğu ve çok daha yavaş çalıştığı belirtiliyor.

Ayrıca istemci tarafı doğrulama çağrısının henüz iOS mobil uygulamasına uygulanmadığı, dolayısıyla saldırının burada %100 tam anlamıyla devam ettiği belirtiliyor.

Ayrıca düzeltmenin Google Play’de 10 milyondan fazla indirilen ChatGPT Android uygulamasına da uygulanıp uygulanmadığı da belli değil.