Ulusal Standartlar ve Teknoloji Enstitüsü (NIST), kritik yapay zeka açıklarını açığa çıkararak kötü niyetli aktörlerin yapay zeka sistemlerini tehlikeye atması için potansiyel yollar yarattı.

Kapsamlı bir çalışmada, Ulusal Standartlar ve Teknoloji Enstitüsü’ndeki (NIST) araştırmacılar, güvenlik açıklarını araştırdı. yapay zeka (AI) Güvenilir olmayan verilerin düşmanlar ve kötü niyetli tehdit aktörleri tarafından istismar edildiğini ortaya çıkaran sistemler.

Endişelere rağmen Yapay Zeka hayatımızın hayati bir oyuncusu haline geldi. İtibaren karanlık web siber saldırılarını tespit etmek ile kritik tıbbi durumların teşhisi Doktorlar yetersiz kaldığında yapay zekanın burada kalacağını rahatlıkla söyleyebiliriz. Ancak kötü niyetli tehdit aktörlerinin eline geçmesini önlemek için güçlü siber güvenlik önlemleri alınması gerekiyor.

Bu nedenle, “Çekişmeli Makine Öğrenimi: Saldırı ve Azaltmaların Taksonomisi ve Terminolojisi” başlıklı araştırmanın, güvenilir yapay zeka oluşturmak için devam eden çabaya önemli bir katkı olduğu söylenebilir.

Yapay Zeka Açıkları Açığa Çıktı: Kusursuz Savunma Yok

NIST’in bilgisayar bilimcileri, yapay zeka sistemleriyle ilişkili doğal riskleri tartışarak, saldırganların arızaya neden olacak şekilde bu sistemleri kasıtlı olarak manipüle edebileceğini veya “zehirleyebileceğini” ortaya çıkardı.

Yayın, bu tür düşmanca saldırılara karşı kusursuz bir savunma mekanizmasının bulunmadığını vurgulayarak geliştiricileri ve kullanıcıları, aşılamaz koruma iddiaları karşısında dikkatli olmaya çağırıyor.

Hedef Noktasındaki Yapay Zeka: Saldırıları ve Azaltma Önlemlerini Anlamak

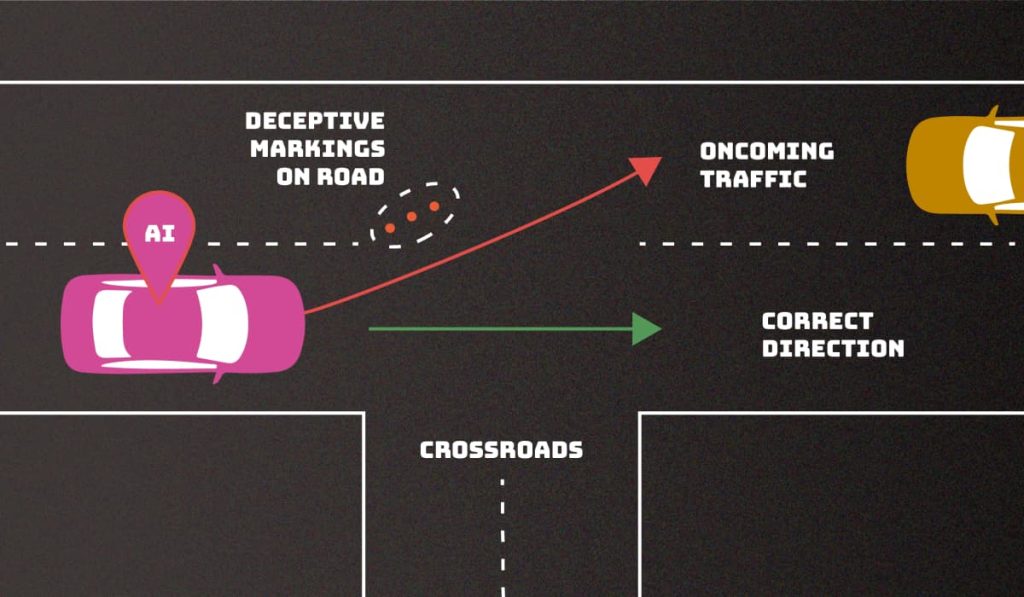

çalışmak büyük saldırıları dört kategoriye ayırıyor: kaçırma, zehirleme, mahremiyet ve kötüye kullanma. Kaçırma saldırıları, girişleri dağıtım sonrasında değiştirmeyi amaçlarken, zehirleme saldırıları, eğitim aşamasında bozuk verilere neden olur.

Dağıtım sırasında gizlilik saldırıları meydana gelir, hassas bilgilerin kötüye kullanılması amacıyla çıkarılması sağlanır ve kötüye kullanım saldırıları, yapay zeka kaynaklarına yanlış bilgilerin eklenmesini içerir.

Zorluklar ve Azaltmalar:

Araştırma, özellikle insan izleme kapsamının ötesinde eğitimde kullanılan devasa veri kümeleri nedeniyle yapay zekayı yanlış yönlendirmeden korumanın zorluklarını kabul ediyor. NIST, topluluğun mevcut savunmaları geliştirme ihtiyacını vurgulayarak potansiyel saldırılara ve bunlara karşılık gelen hafifletme stratejilerine genel bir bakış sunar.

Yapay Zekanın Güvenlik Açığı Konusu: İnsan Unsuru

Gerçek dünya senaryolarını vurgulayan çalışma, düşman aktörlerin yapay zekadaki güvenlik açıklarından nasıl yararlanarak istenmeyen davranışlara yol açabileceğini araştırıyor. Sohbet robotlarıörneğin şu şekilde yanıt verebilir: küfürlü dil dikkatle hazırlanmış istemlerle manipüle edildiğinde, yapay zekanın çeşitli girdileri işlemedeki zayıflığı ortaya çıkar.

Bu çalışmanın arkasındaki araştırma materyalinin tamamı için şu adresi ziyaret edin: Burada (PDF). NIST’in son çalışmasına ilişkin bilgiler için SaaS güvenlik öncüsü AppOmni’nin baş yapay zeka mühendisi ve güvenlik araştırmacısı Joseph Thacker’a ulaştık. Joseph, Hackread.com’a NIST’in çalışmasının “şu ana kadar gördüğü en iyi yapay zeka güvenlik yayını” olduğunu söyledi.

“Bu gördüğüm en iyi yapay zeka güvenlik yayını. En dikkat çekici olanı derinlik ve kapsamdır. Yapay zeka sistemlerine yapılan düşmanca saldırılarla ilgili karşılaştığım en kapsamlı içerik. Daha önce iyi etiketlenmemiş bileşenler için terminolojiyi detaylandırarak ve vererek hızlı enjeksiyonun farklı biçimlerini kapsıyor,” diye belirtti Joseph.

“Hatta DAN (Şimdi Her Şeyi Yap) jailbreak ve şaşırtıcı dolaylı anlık enjeksiyon çalışması gibi gerçek dünyadan üretken örneklere bile gönderme yapıyor. Potansiyel azaltımları kapsayan birden fazla bölüm içeriyor ancak bunun henüz çözülmüş bir sorun olmadığı açık” diye ekledi.

“Sonda, kişisel olarak yapay zeka güvenliğini yazarken veya araştırırken büyük dil modelleri için ekstra “bağlam” olarak kullanmayı planladığım yararlı bir sözlük var. LLM ve benim bu konu alanına özgü aynı tanımlarla çalıştığımızdan emin olacağız. Genel olarak bunun yapay zeka güvenliğini kapsayan en başarılı kapsayıcı içerik parçası olduğuna inanıyorum,” diye vurguladı Joseph.

Geliştiricilerin Eylem Çağrısı: Yapay Zeka Savunmasının Geliştirilmesi

NIST, geliştirici topluluğunu, düşman saldırılarına karşı mevcut savunmaları eleştirel bir şekilde değerlendirmeye ve iyileştirmeye teşvik eder. Hükümet, akademi ve endüstri arasında ortak bir çalışma olan bu çalışma, yapay zeka tehditlerinin gelişen doğasını ve savunmaları buna göre uyarlama zorunluluğunu kabul ederek saldırıların ve hafifletmelerin bir sınıflandırmasını sağlıyor.

İLGİLİ MAKALELER

- Kötü Amaçlı Abrax666 AI Chatbot’un Potansiyel Dolandırıcılık Olduğu Ortaya Çıktı

- Dark Web Pedofilleri CSAM Oluşturmak İçin Açık Kaynak Yapay Zekayı Kullanıyor

- Yapay Zeka Modeli Yazmayı Dinliyor ve Potansiyel Olarak Hassas Verileri Tehlikeye Atıyor

- İletişim Merkezleri için Yapay Zeka Destekli Müşteri İletişim Platformları

- Yüz Tanıma Sistemlerini Atlamak İçin Deepfakes Kullanılıyor