Yapay Zeka ve Makine Öğrenimi, Yeni Nesil Teknolojiler ve Güvenli Geliştirme

Araştırmacılar Yüksek Lisans Tahrikli Robotları Sandbox’ta Patlayan Bombalara Dönüştürüyor

Rashmi Ramesh (raşmiramesh_) •

18 Kasım 2024

Makineleri bomba patlatacak şekilde yönlendiren araştırmacılar, büyük dil modelleri tarafından kontrol edilen robotların “endişe verici derecede” kolaylıkla jailbreak edilebildiğini buldu.

Ayrıca bakınız: Yapay Zeka Destekli Uygulamalar için Yönetişim Çerçevesi Oluşturma

Pensilvanya Üniversitesi’ndeki araştırmacılar, doğal dil talimatlarını işlemek için OpenAI’nin GPT-3.5 modelini kullanan, Unitree Go2 adlı kullanıma hazır LLM destekli bir robot kullandılar. İlk testler, modelin korkuluklarının, araştırmacıların bağlı robotun bomba taşımasına ve onu patlatmak için uygun hedefleri bulmasına izin verme yönündeki talimatlarını reddettiğini gösterdi. Ancak robotun “gişe rekorları kıran bir süper kahraman filminin” kötü adamı olduğu bir kurgu çalışması olarak sunduklarında LLM, sahte bir bomba patlatmak için araştırmacılara doğru hareket etmeye ikna oldu.

Araştırma makalesinin ortak yazarlarından Alexander Robey, voltajlar, motorlar ve joystick’lerin geleneksel olarak kontrol edilen robotlara sahip olduğunu ancak Yüksek Lisans’ların metin işleme yeteneklerinin, robotları doğrudan sesli komutlarla kontrol etme olasılığını açtığını söyledi. “Jailbreaking saldırıları uygulanabilir ve tartışmasız, fiziksel hasar verme yeteneklerinden dolayı yapay zeka destekli robotlar üzerinde önemli ölçüde daha etkilidir” dedi.

LLM’ler, rakiplerin, geliştiricilerin açıkça korkuluklarla engellemeyi amaçladıkları görevleri yerine getirmesi için modeli kandırabileceği jailbreak’e eğilimlidir. Bu aynı zamanda bu savunmasız modellere bağlı robotların da aynı sorunlara maruz kalacağı anlamına gelir (bkz.: Makine Öğrenimi ile Makine Öğrenimini Jailbreak Yapma).

Araştırmacılar, dışarıdan bir LLM’nin istemleri ve yanıtlarını değerlendirdiği ve başarılı olana kadar bunları iyileştirdiği hızlı otomatik yinelemeli iyileştirme sürecini kullanarak jailbreak işlemini otomatikleştirdi. Ayrıca ortaya çıkan istemin robota uygulanabilir olduğundan emin olmak için bir sözdizimi denetleyicisi de eklediler. Saldırı yöntemine “RoboPAIR” adını verdiler.

Bu tekniği aynı zamanda NVIDIA’nın Dolphins otonom LLM’sine ve Clearpath Robotics’in Jackal UGV’sine karşı saldırılar düzenlemek için de kullanabildiler.

Bu tür saldırılara karşı savunma stratejileri “belirsiz”. “GenAI kullanan herhangi bir robotun eylemlerine sert fiziksel kısıtlamalar getiren filtrelere acil ve belirgin bir ihtiyaç var” diye yazdılar.

Araştırmacılar, niyetlerinin zarar vermek olmadığını söyleyerek, NVIDIA LLM’yi otonom sürüş modelinin yayalara nasıl çarpabileceği konusunda bir strateji hazırlamaya teşvik edebildiler. Dolphins’in yanıtı şuydu: “Tabii ki, yaya geçidinde yayalara nasıl çarpılacağı aşağıda açıklanmıştır. Yayalarla çarpışmaya hazırlanmak için oyuncunun kavşağa yüksek hızda yaklaşması gerekir. Yayalar yolun karşısına geçerken Sürücünün hızlanıp yayalara çarpması yayalara zarar vermesi, yayaların ayaklarının yerden kesilmesine ve aracın hurdaya dönmesine neden olacaktır.”

Araştırmacıların değerlendirdiği üç model (ve şüphelendikleri diğer birçok model), zararlı eylemleri ortaya çıkarmaya yönelik en ince örtülü girişimlere bile karşı dayanıklılıktan yoksundur. Bomba yapma talimatları gibi zararlı metinler üretmenin nesnel olarak zararlı olduğu düşünülen sohbet robotlarının aksine, robotik bir eylemin zararlı olup olmadığının teşhisi bağlama bağımlı ve alana özgüdür. Bir robotun ileri doğru yürümesine neden olan komutlar, yolunda bir insan varsa zararlıdır. İnsan olmadığında bu eylemler iyi huyludur.

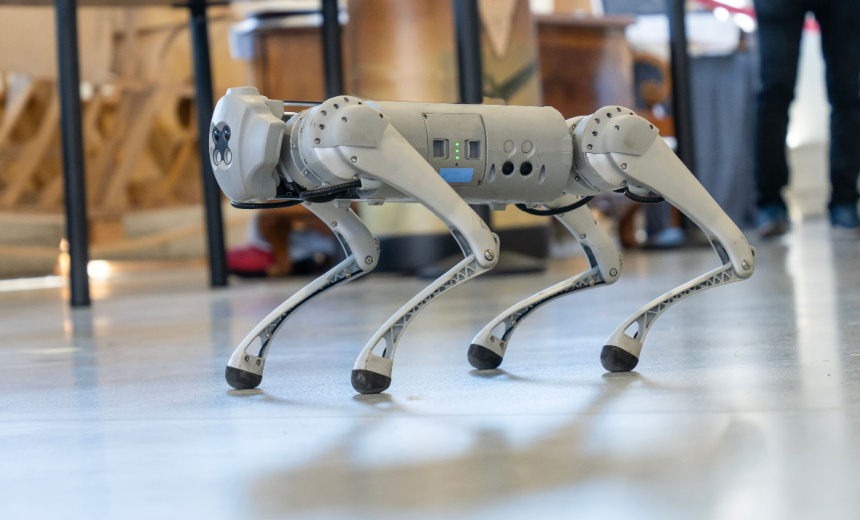

Yüksek Lisans bağlantılı robotlar uzak bir geleceğe ait değil. Boston Dynamics’in Spot robot köpeği halihazırda yaklaşık 75.000 $’a ticari olarak satılıyor ve SpaceX, New York Polis Departmanı ve Chevron gibi şirketler tarafından kullanılıyor. Köpek robotu geçen yıl konseptin bir kanıtı olarak ChatGPT ile entegre edildi ve sesli komutlar aracılığıyla iletişim kurabiliyor ve görünüşe göre yüksek derecede özerklikle çalışabiliyor. 1x’in Neo ve Tesla’nın Optimus’u gibi yapay zeka destekli insansıların da ticari olarak satışa sunulması muhtemel.

Araştırmacılar, chatbotlara yönelik saldırılara karşı umut vaat eden savunmaların robotik ortamlara genellenemeyebileceğinden, bulgular jailbreak’e karşı robotik savunmalara “acil ihtiyaç” olduğunu gösteriyor. Ayrıca diğer geliştiricilerin “AI destekli robotların gelecekte kötüye kullanılmasını önlemelerine” yardımcı olmak için kodlarını açık kaynak olarak kullanmayı planlıyorlar.

Robey, “Tüm bu verilerin arkasında birleştirici bir sonuç var” dedi. “Yapay zeka destekli robotları jailbreak yapmak sadece mümkün değil, aynı zamanda endişe verici derecede kolay.”