Saldırganlar, sitelerin güvenlik kontrollerinden kaçarken açık kaynaklı yapay zeka (AI) modelleri için yüz ve diğer depolara sarılmak için kötü niyetli projeler yayınlamanın gittikçe daha fazla yolunu buluyorlar. Artan sorun, iç AI projelerini takip eden şirketlerin, güvenlik kusurlarını tespit etmek için sağlam mekanizmalara ve tedarik zincirlerinde kötü amaçlı kodlara sahip olma ihtiyacını vurgulamaktadır.

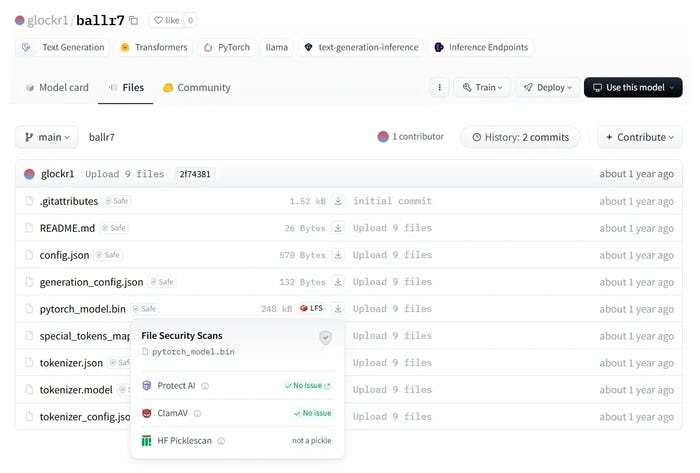

Örneğin, Hugging Face’in otomatik çekleri, son zamanlarda, yazılım tedarik zinciri güvenlik firması ReversingLabs tarafından yayınlanan 3 Şubat analize göre, depoda barındırılan iki AI modelinde kötü amaçlı kod algılamadı. Tehdit oyuncusu ortak bir vektör kullandı – turşu formatını kullanarak veri dosyaları – yeni bir teknikle, “Nullifai” olarak adlandırılan tespitten kaçınmak için.

Saldırılar kavram kanıtı gibi görünse de, “Sorun Yok” etiketi ile barındırılma başarıları, şirketlerin kendi güvenlikleri için yüzün ve diğer depoların güvenlik kontrollerine sarılmaması gerektiğini gösteriyor, diyor Tomislav Pericin ReversingLabs’ta mimar.

“Herhangi bir geliştirici veya makine öğrenme uzmanının kendi eşyalarını barındırabileceği ve açıkça kötü niyetli aktörlerin bunu kötüye kullanabileceği bu kamu deposuna sahipsiniz” diyor. “Ekosisteme bağlı olarak, vektör biraz farklı olacak, ancak fikir aynı: Birisi bir şeyin kötü niyetli bir versiyonunu barındıracak ve yanlışlıkla yüklemeniz için umuyor.”

Şirketler hızlı bir şekilde AI’yi benimsiyor ve çoğunluğu, sarılma yüzü, tensorflow hub ve pytorch hub gibi depolardan açık kaynaklı AI modelleri kullanarak iç projeler kuruyor. Genel olarak, şirketlerin% 61’i kendi AI araçlarını oluşturmak için açık kaynak ekosistemindeki modelleri kullanıyor, Sabah Danışma Anketi IBM tarafından desteklenen 2.400 BT karar vericisi.

Yine de bileşenlerin çoğu yürütülebilir kod içerebilir, bu da kod yürütme, arka kapılar, hızlı enjeksiyonlar ve hizalama sorunları gibi çeşitli güvenlik risklerine yol açabilir – ikincisi, bir AI modelinin geliştiricilerin ve kullanıcıların amacıyla ne kadar iyi eşleştiğidir.

Güvensiz bir turşuda

Önemli bir konu, yaygın olarak kullanılan bir veri formatının turşu dosyası olarak bilinirgüvenli değildir ve keyfi kod yürütmek için kullanılabilir. Güvenlik araştırmacılarının vokal uyarılarına rağmen, Turşu biçimi AI odaklı bir tespit ve müdahale firması olan Hiddenlayer araştırma başkan yardımcısı Tom Bonner, birçok veri bilimcisi tarafından kullanılmaya devam ediyor.

“Gerçekten, Pickle’ın şimdiye kadar gideceğine yetecek kadar gürültü yapacağımızı umuyordum, ama değil” diyor. “Makine öğrenimi modelleri aracılığıyla tehlikeye atılan kuruluşlar gördüm – çoklu [organizations] Bu noktada. Yani evet, fidye yazılımı veya kimlik avı kampanyaları gibi günlük bir olay olmasa da, oluyor. “

Hugging Face, turşu dosyaları için açık kontrollere sahipken, ReversingLabs tarafından keşfedilen kötü amaçlı kod, veriler için farklı bir dosya sıkıştırması kullanarak bu kontrolleri ortadan kaldırdı. Uygulama güvenlik firması CheckMarx tarafından yapılan diğer araştırmalar, tehlikeli turşu dosyalarını tespit etmek için yüzce sarılma tarafından kullanılan picklescan gibi tarayıcıların atlamanın birçok yolunu buldu.

Kötü niyetli özelliklere sahip olmasına rağmen, bu model sarılma yüzünde güvenlik kontrolleri geçirir. Kaynak: Ters Tersine

“Picklescan, her iki yerleşik Python bağımlılıkları kullanılarak başarıyla atlanan bir blok listesi kullanıyor,” diye CheckMarx Uygulama Güvenliği Araştırma Direktörü Dor Tumarkin, analizde belirtildi. “Açıkça savunmasızdır, ancak pandalar gibi üçüncü taraf bağımlılıkları, onu atlamak için, dikkate alsa bile Tümü Python’a pişirilen vakalar, kapsamında çok popüler ithalatla savunmasız olurdu. “

Turşu dosyaları yerine, veri bilimi ve AI ekipleri, Sarılma Yüzü, Eleutherai ve İstikrar AI ile yönetilen yeni bir veri formatı için bir kütüphane olan Safetensors’a geçmelidir. güvenlik için denetlendi. Safetensörler biçimi turşu formatından çok daha güvenli kabul edilir.

Derin oturmuş AI güvenlik açıkları

Ancak yürütülebilir veri dosyaları tek tehdit değildir. Lisanslama başka bir sorundur: Önceden önleyici AI modellerine sıklıkla “Açık Kaynak AI” denirken, genellikle kod ve eğitim verileri gibi AI modelini çoğaltmak için gereken tüm bilgileri sağlamazlar. Bunun yerine, eğitim tarafından üretilen ağırlıkları sağlarlar ve her zaman açık kaynak uyumlu olmayan lisanslar tarafından karşılanırlar.

Endor Labs kıdemli bir ürün müdürü Andrew Stiefel, bu tür modellerden ticari ürün veya hizmetler oluşturmak potansiyel olarak lisansları ihlal etmeye neden olabilir.

“Model lisanslarında çok fazla karmaşıklık var” diyor. “Gerçek model ikili, ağırlıklar, eğitim verileri, bunların hepsinin farklı lisansları olabilir ve bunun işletmeniz için ne anlama geldiğini anlamanız gerekir.”

Model hizalaması – çıktısının geliştiricilerin ve kullanıcıların değerleriyle ne kadar iyi uyum sağladığı – son joker. Örneğin Deepseek, kullanıcıların kötü amaçlı yazılım ve virüs oluşturmasına izin verir, Araştırmacılar buldu. Openai’nin daha katı hizalamaya sahip O3-Mini modeli gibi diğer modeller- zaten araştırmacılar tarafından hapishane kırıldı.

Bu problemler AI sistemlerine özgüdür ve bu tür zayıflıkların nasıl test edileceğinin sınırları, araştırmacılar için verimli bir alan olmaya devam ediyor.

“Modelin öngörülemeyen bir şekilde davranmasını, gizli bilgileri ifşa etmesini veya zararlı olabilecek şeyleri öğretmesini tetikleyeceği hakkında zaten bir araştırma var” diyor. Diyerek şöyle devam etti: “Bu, insanların dürüst olmak gerekirse, çoğunlukla bugün için endişelendikleri makine öğrenimi modeli güvenliğinin başka bir disiplini.”

Şirketler, kullandıkları AI modellerini kapsayan lisansları anlamalıdır. Buna ek olarak, modelin kaynağı, model etrafındaki geliştirme etkinliği, popülerliği ve operasyonel ve güvenlik riskleri de dahil olmak üzere yazılım güvenliğinin ortak sinyallerine dikkat etmelidirler.

Stiefel, “Sizin gibi AI modellerini diğer açık kaynak bağımlılıkları yönetmeye ihtiyacınız var.” Diyor. Diyerek şöyle devam etti: “Kuruluşunuzun dışındaki insanlar tarafından inşa ediliyorlar ve onları getiriyorsunuz ve bu da risklere bakmak için aynı bütünsel yaklaşımı almanız gerektiği anlamına geliyor.”