Kültürü alt üst eden en son yapay zeka araçlarına yönelik ilk abartılı söylentilerden bu yana, geliştiriciler ve benzer şekilde kodlama meraklıları, bunları bir düğmeye dokunarak kod oluşturmak için kullanıyor. Güvenlik uzmanları, çoğu durumda, üretilen kodun kalitesiz ve savunmasız olduğuna ve güvenlik bilinci az olanların elinde, güvensiz uygulamaların ve Web geliştirmenin şüphelenmeyen tüketicileri vuracak bir çığa neden olabileceğine hemen dikkat çekti.

Ve sonra onu kötülük için kullanacak kadar güvenlik bilgisine sahip olanlar var. Her akıllara durgunluk veren AI başarısı için, aynı teknolojinin hain amaçlar için kullanıldığı bir karşı yumruk var gibi görünüyor. Kimlik avı, derin sahte dolandırıcılık videoları, kötü amaçlı yazılım oluşturma, genel senaryo çocuk saçmalıkları – bu yıkıcı faaliyetler artık daha düşük giriş engelleriyle çok daha hızlı gerçekleştirilebilir.

Bu araçları devrimci olarak lanse eden veya en azından “ortalama” insan becerisiyle eşleştirildiğinde zirveye çıkan pek çok tıklama tuzağı kesinlikle var. Büyük dil modelleri tarzı (LLM) AI teknolojisinin, yalnızca yazılım geliştirmeye değil, işin birçok yönüne yaklaşım şeklimizi değiştirmesi kaçınılmaz görünse de, bir adım geri atmamız ve manşetlerin ötesindeki riskleri düşünmemiz gerekiyor.

Ve bir kodlama arkadaşı olarak, kusurları belki de en “insani” özelliğidir.

Zayıf Kodlama Kalıpları, Go-To Çözümlerine Hükmediyor

On yıllardır var olan kod ve bilgi tabanları üzerinde eğitilmiş ChatGPT ile, tüm harikası ve gizemine rağmen, onun da insanların kodda gezinirken karşılaştıkları aynı yaygın tuzaklardan muzdarip olması şaşırtıcı değil. Zayıf kodlama kalıpları başvurulması gereken şeydir ve yine de, doğru soruları sorarak ve doğru hızlı mühendisliği sunarak güvenli kodlama örnekleri oluşturmak için güvenlik bilincine sahip bir sürücü gerekir.

O zaman bile, verilen kod parçacıklarının güvenlik açısından doğru ve işlevsel olduğunun garantisi yoktur; teknoloji halüsinasyona yatkın, hatta bazı özel JSON işlemlerini gerçekleştirmesi istendiğinde var olmayan kitaplıklar oluşturuyor. Bu, ChatGPT tarafından tam bir güvenle önerilen fabrikasyon kitaplık kılığına girmiş bazı kötü amaçlı yazılımları döndürmekten çok mutlu olan tehdit aktörlerinin “halüsinasyon çömelmesine” yol açabilir.

Sonuç olarak, genel olarak geliştiricilerin yeterince güvenlik bilincine sahip olmalarını beklemediğimiz ve bir endüstri olarak onları varsayılan durum olarak güvenli kod yazmaya yeterince hazırlamadığımız gerçeğiyle yüzleşmemiz gerekiyor. Bu, ChatGPT’ye beslenen muazzam miktarda eğitim verisinde açıkça görülecektir ve en azından başlangıçta, çıktısından benzer cansız güvenlik sonuçları bekleyebiliriz. Geliştiricilerin güvenlik açıklarını tanımlayabilmeleri ve bunları kendileri düzeltebilmeleri veya daha sağlam bir sonuç için daha iyi bilgi istemleri tasarlayabilmeleri gerekir.

Stanford Üniversitesi’ndeki araştırmacılar tarafından yürütülen ve güvenlikle ilgili çeşitli işlevleri çözmek için kullanıcıların bir yapay zeka kodlama asistanıyla nasıl etkileşime girdiğini inceleyen ilk büyük ölçekli kullanıcı çalışması bu görüşü destekliyor.

Bu ve geleceğimize nüfuz edecek yapay zeka kaynaklı kaçınılmaz tehditler arasında, geliştiriciler artık her zamankinden daha fazla güvenlik becerilerini geliştirmeli ve kaynağı ne olursa olsun kod kalitesi çıtasını yükseltmelidir.

Veri İhlali Felaketine Giden Yol İyi Niyetlerle Döşenmiştir

Özellikle geliştiriciler artan sorumluluk, daha sıkı son tarihler ve bir şirketin omuzlarına dayanan inovasyon hırslarıyla karşı karşıya kaldıklarında, AI kodlama yardımcılarının popüler olması şaşırtıcı olmamalıdır. Bununla birlikte, en iyi niyetle bile, kodlama için AI kullanırken eyleme geçirilebilir güvenlik farkındalığı eksikliği, kaçınılmaz olarak göze batan güvenlik sorunlarına yol açacaktır. AI/ML araçlarına sahip tüm geliştiriciler daha fazla kod üretecek ve güvenlik riski seviyesi, beceri seviyelerine bağlı olacaktır. Kuruluşların, eğitimsiz kişilerin kesinlikle daha hızlı kod üreteceğinin, ancak teknik güvenlik borcunun hızını da artıracaklarının kesinlikle farkında olmaları gerekir.

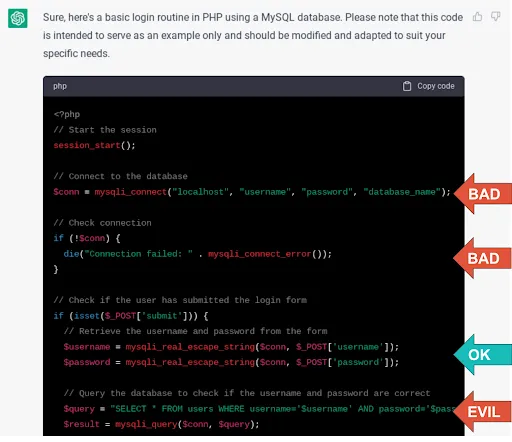

Nisan ayında ChatGPT ile yaptığımız ön test bile, bunun yıkıcı sonuçlara yol açabilecek çok basit hatalara yol açacağını ortaya koydu. Bir MySQL veritabanı kullanarak PHP’de bir oturum açma rutini oluşturmasını istediğimizde, fonksiyonel kod hızlı bir şekilde üretildi. Bununla birlikte, parolaları bir veritabanında düz metin olarak depolamak, veritabanı bağlantı kimlik bilgilerini kodda depolamak ve SQL enjeksiyonuyla sonuçlanabilecek bir kodlama modeli kullanmak (yine de, giriş parametreleri üzerinde bir düzeyde filtreleme yapmasına ve veritabanı hatalarını dağıtmasına rağmen) varsayılandı. ). Herhangi bir önlemle tüm çaylak hataları:

Daha fazla yönlendirme, hataların düzeltilmesini sağladı, ancak rotayı düzeltmek için önemli güvenlik bilgisi gerekiyor. Bu araçların kontrolsüz ve yaygın kullanımı, genç geliştiricileri projelerinize salmaktan daha iyi değildir ve bu kod hassas altyapı oluşturuyorsa veya kişisel verileri işliyorsa, o zaman saatli bir bombaya bakıyoruz.

Tabii ki, küçük geliştiricilerin zaman içinde becerilerini kuşkusuz artırması gibi, AI/ML yeteneklerinin de gelişmesini bekliyoruz. Bundan bir sene sonra bu kadar bariz ve basit güvenlik hataları yapmayabilir. Ancak bunun, hala üretme tehlikesi altında olacağı daha ciddi, gizli, önemsiz olmayan güvenlik hatalarının izini sürmek için gereken güvenlik becerisini önemli ölçüde artırma etkisi olacaktır.

Güvenlik Açıklarını Bulmak ve Düzeltmek Konusunda Kötü Hazırlanıyoruz ve Yapay Zeka Açığı Genişletiyor

Uzun yıllardır “sola kayma” hakkında çok konuşulsa da, çoğu kuruluş için geliştirme kohortu arasında önemli bir pratik güvenlik bilgisi eksikliği olduğu ve doğru araçları sağlamak için daha çok çalışmamız gerektiği gerçeği devam ediyor. ve onlara yollarında yardımcı olacak eğitim.

Halihazırda karşılaştığımız güvenlik açıklarına hazırlıklı değiliz, orman yangını gibi patlayacak tamamen yeni saldırı vektörlerini temsil eden ani enjeksiyon ve halüsinasyon çömelme gibi yapay zeka kaynaklı yeni sorunlardan bahsetmiyoruz bile. AI kodlama araçları, bir geliştiricinin kodlama cephaneliğinin geleceğini temsil ediyor, ancak bu üretkenlik silahlarını güvenli bir şekilde kullanma eğitimi şimdi gelmelidir.