AI yayıldıkça riskler de öyle. Güvenlik liderlerinden henüz tam olarak anlamadıkları sistemleri korumaları isteniyor ve bu bir sorun.

Paladin Global Enstitüsü’nden yeni bir rapor olan AI Tech Stack: Teknoloji ve siber politika için bir astar, AI sistemlerinin nasıl inşa edildiğini ve en büyük güvenlik risklerinin nerede yaşadığını bozuyor. CISOS için, gerçek dünya ortamlarında AI’nın nasıl güvence altına alınacağını düşünmeye başlamak için pratik bir yol sunar.

Basit ama güçlü bir model

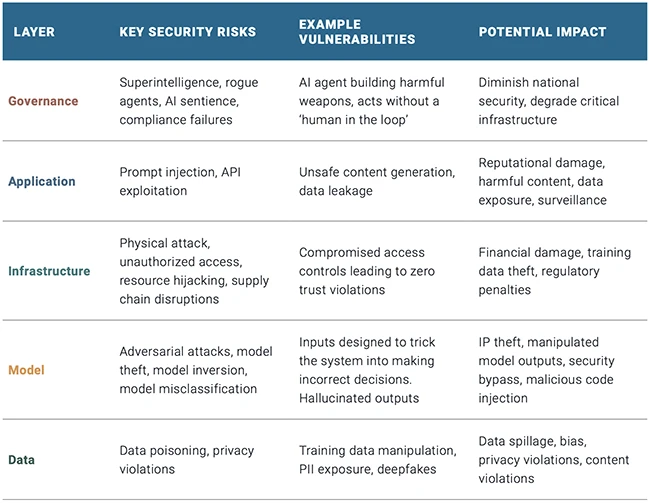

Rapor, AI Tech yığınını beş farklı ancak birbirine bağlı katman olarak tanımlamaktadır:

- Veri katmanı: AI sistemlerine güç veren hammadde.

- Model katmanı: Verileri işleyen algoritmalar ve makine öğrenimi modelleri.

- Altyapı katmanı: Modelleri çalıştıran hesaplama ve donanım ortamı.

- Uygulama katmanı: AI’yı kullanıcılara ve diğer sistemlere bağlayan arayüz.

- Yönetişim katmanı: Tüm yığının etrafını saran yasal, etik ve güvenlik çerçevesi.

Her katmanın kendi riskleri vardır. Daha da önemlisi, bir katmandaki riskler başkalarına doğru ilerleyebilir. Örneğin, zehirli bir veri kümesi (veri katmanı) bir modeli bozabilir, kötü çıktılara (model katmanı) yol açabilir ve sonunda bir kamusal olaya (yönetişim katmanı) neden olabilir.

Raporda, “Bir katman içindeki riskler sistem boyunca ilerleyebilir – zehirli bir eğitim veri kümesi bir modeli bozabilir, bu da konuşlandırılan uygulamalarda öngörülemeyen davranışlara ve nihayetinde kamusal sonuçlarla yönetişim başarısızlıklarına yol açabilir” diye uyarıyor.

Yapay zeka sağlamak, korumaları yığın boyunca gömmek ve bu katmanların birlikte nasıl çalıştığını anlamak anlamına gelir.

Verileri ve model katmanlarını önceliklendirin

Sınırlı kaynaklarınız varsa, hasarın en şiddetli olabileceği yerler: veri ve model katmanları. Bunlar herhangi bir AI sisteminin temelidir ve son derece savunmasızdırlar. Raporda şunları söylüyor: “Veri ve model katmanları AI güvenliğini doğru yapmanın en önemlisidir.”

Saldırganlar bunu biliyor. Veri zehirlenmesi, model hırsızlığı, düşmanca girdiler ve ters çevirme saldırıları AI davranışını manipüle edebilir veya hassas bilgileri çıkarabilir. Tek bir zehirli giriş model çıkışlarını eğebilir veya hatta yetkisiz erişime izin verebilir. AI modelleri genellikle büyük miktarlarda yapılandırılmamış veri ile inşa edildiğinden, bazıları hassas, ihlallerin tespit edilmesi zor ve düzeltilmesi daha da zor olabilir.

Raporda birkaç temel savunma önermektedir:

- Eğitim verilerine erişimi şifreleyin ve kısıtlayın.

- Veri maskeleme ve girdi sanitizasyonu kullanın.

- Model uç noktalarını güçlü kimlik doğrulama ve güvenlik duvarlarıyla koruyun.

“Veri katmanının şifreleme, erişim kontrolleri ve veri maskeleme yoluyla güvence altına alınması, veri ihlallerini önlemek, fikri mülkiyetin güvenliğini sağlamak, kullanıcı güvenini korumak ve düzenlemelere uymak için kritik öneme sahiptir” diyor.

Altyapı ve Uygulamalar: Mevcut korumaları genişletin

Model ve veri katmanları yeni stratejiler gerektirse de, altyapı ve uygulama katmanları daha tanıdık bir zemin sunar.

Birçok CISO zaten bulut iş yüklerini yönetiyor, API’leri güvenli ve kurumsal sistemler arasında en az ayrıcalığı zorluyor. Aynı uygulamalar burada, yeni bahislerle de geçerlidir. Örneğin, altyapı katmanındaki GPU kümeleri ve uzmanlaşmış AI yongaları, tedarik zinciri saldırıları veya kaynak kaçırma için yüksek değerli hedefler olabilir.

Bu arada uygulama katmanı, hızlı enjeksiyon ve API istismarı gibi tehditler getiriyor. “Hızlı enjeksiyon, API sömürüsü” ve “güvenli olmayan içerik üretimi, veri sızıntısı” raporda belirtilen riskler arasındadır.

Bu katmanları savunmak için rapor, AI’ya özgü ayar ile mevcut siber güvenlik çerçevelerinin inşa edilmesini önermektedir:

- Arayüzde TLS’den yararlanın.

- Sıkı rol tabanlı erişim kontrolleri uygulayın.

- İstemlerin veya API’lerin kötüye kullanılması için sürekli olarak izleyin.

Yönetişim katmanı: devam eden bir çalışma

Yığının çoğu teknik olsa da, yönetişim katmanı politika, etik ve gözetim üzerine odaklanır ve en az olgundur. Ancak bu, CISOS’un onu görmezden gelebileceği anlamına gelmez.

Yazarlar, “Yönetişim katmanı, AI güveni için en az olgun ama gerekli” diyor. “Farklı bir şey talep ediyor: katı düzenlemenin ötesine geçip dinamik protokol gelişimine doğru ilerlemek.”

Bu, kabul edilebilir kullanımın tanımlanmasını, insan gözetimini sağlamak ve AI’nın yetkisiz kararlar almak veya zararlı içerik oluşturmak gibi avantaj vakaları için hazırlanmayı içerir.

Rapor, TLS ve DNSSEC gibi erken internetin güvenliğini sağlayan örneklere atıfta bulunarak endüstri liderliğindeki, esnek standartlar (herkese uyan tek bir düzenleme değil) gerektiriyor. CISOS, özellikle açık kaynaklı modellerin ve üçüncü taraf AI araçlarının kullanımı konusunda kendi kuruluşları içinde yönetişim protokolleri oluşturarak burada rol oynayabilir.

Siloları değil sistemlerde düşün

Raporun en güçlü mesajlarından biri, sistem düzeyinde bir görünüme ihtiyaçtır. Çoğu siber güvenlik programı uç noktalar, ağlar veya veri merkezleri etrafında oluşturulmuştur. Ancak AI bu sınırlara saygı duymaz.

Raporda, “Kuruluşlar, AI yığınının her seviyesindeki benzersiz güvenlik açıklarını çözen sofistike, çok katmanlı güvenlik stratejileri geliştirmelidir” diyor.

Bu, çapraz işlevsel koordinasyon gerektirir. Veri ekibiniz eğitim boru hatlarına sahip olabilir. Geliştiriciler uygulamaları kontrol eder. Altyapı ele alıyor. Ancak her takım tek başına çalışıyorsa, AI riski çatlaklardan geçer. CISOS’un yığın çapında bir güvenlik stratejisini yönetmesi veya en azından koordine etmesi gerekecektir.