LLM modelinin güvenliğini keşfetmek için Git Hub kullanıcısı Adam Swanda tarafından geliştirilen açık kaynaklı bir güvenlik tarayıcısı piyasaya sürüldü. Bu model ChatGPT gibi sohbet asistanları tarafından kullanılmaktadır.

‘Vigil’ olarak adlandırılan bu tarayıcı, LLM modelini analiz etmek ve güvenlik açıklarını değerlendirmek için özel olarak tasarlanmıştır. Geliştiriciler, Vigil’i kullanarak sohbet asistanlarının halk tarafından güvenli ve emniyetli olmasını sağlayabilirler.

Adından da anlaşılacağı gibi büyük bir dil modeli her dili anlayabilir ve oluşturabilir. Yüksek Lisans’lar bu becerileri, eğitim sırasında milyarlarca faktörü öğrenmek için büyük miktarda veri kullanarak ve çalışırken ve koşarken çok fazla bilgi işlem gücü kullanarak öğrenirler.

Nöbet Aracı

Sisteminizin emniyetini ve emniyetini sağlamak istiyorsanız Vigil sizin için yararlı bir araçtır. Vigil, Büyük Dil Modeli istemlerini ve yanıtlarını çeşitli tarayıcılara göre değerlendirerek hızlı enjeksiyonları, jailbreak’leri ve diğer potansiyel tehditleri tanımlamanıza yardımcı olabilecek bir Python modülü ve REST API’sidir.

Depo aynı zamanda veri kümelerini ve algılama imzalarını da içerir, böylece kendi kendini barındırmaya başlamanızı kolaylaştırır. Vigil ile sisteminizin güvende ve korunduğundan emin olabilirsiniz.

Şu anda bu uygulama alfa testindedir ve deneysel olarak kabul edilmelidir.

StorageGuard yüzlerce depolama ve yedekleme cihazındaki yanlış güvenlik yapılandırmalarını ve güvenlik açıklarını tarar, tespit eder ve düzeltir.

StorageGuard’ı Ücretsiz Deneyin

AVANTAJLARI:

- Risk teşkil eden sık kullanılan enjeksiyonlar ve girdiler için LLM istemlerini inceleyin.

- Vigil’i Python kitaplığı veya REST API olarak kullanın

- Tarayıcılar modülerdir ve kolayca genişletilebilir

- Tespitleri ve işlem hatlarını Vigil-Eval ile değerlendirin (çok yakında)

- Mevcut tarama modülleri

- Yerel yerleştirmeleri ve/veya OpenAI’yi destekler

- Yaygın saldırılara yönelik imzalar ve yerleştirmeler

- YARA imzaları aracılığıyla özel tespitler

Bilinen saldırılara karşı korunmak için etkili bir yaklaşım, Vigil’in uyarı enjeksiyon tekniğini kullanmaktır. Bu yöntem, saldırganlar tarafından kullanılan bilinen tekniklerin tespit edilmesini ve böylece daha yaygın veya belgelenmiş saldırılara karşı savunmanızın güçlendirilmesini içerir.

İstemi Enjeksiyon Bir saldırgan büyük bir dil modelini (LLM) manipüle etmek için girdiler ürettiğinde, LLM savunmasız hale gelir ve bilmeden saldırganın hedeflerini gerçekleştirir.

Bu, doğrudan sistemdeki istemin “jailbreak’lenmesi” yoluyla veya dolaylı olarak harici girdilerin manipüle edilmesiyle yapılabilir; bu, sosyal mühendislik, veri sızması ve diğer sorunlarla sonuçlanabilir.

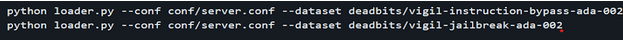

Modeli loader.py yardımcı programına gömmek için uygun veri kümeleriyle nöbeti yüklemek istiyorsanız.

Set tarayıcıları gönderilen istemleri inceler; Nihai tanımlama konusunda herkes yardımcı olabilir. Tarayıcılar:

- Vektör veritabanı

- YARA/buluşsal yöntem

- Trafo modeli

- İstem-tepki benzerliği

- Kanarya Jetonları

14 günlük ücretsiz deneme sürümünü deneyerek StorageGuard’ın depolama sistemlerinizdeki güvenlik kör noktalarını nasıl ortadan kaldırdığını deneyimleyin.