Büyük bir dil modeli (LLM) ve üretken yapay zekanın bir örneği olarak ChatGPT’nin risk ve getirisini dengelemek, bu kadar güçlü bir aracın zarar verme potansiyeline ilişkin bir risk değerlendirmesi yapmakla başlar. Aşağıdakileri göz önünde bulundur.

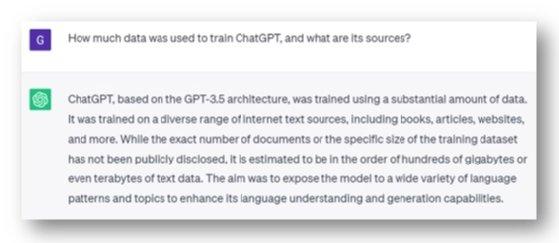

ChatGPT eğitimi

İtalya ve Almanya, ChatGPT manşetlerine girdi: “OpenAI’nin kişisel verileri kullanıcıları ve bireyleri bilgilendirmeden işlediği iddia ediliyor ve AI modellerini eğitmek için kullanılan kapsamlı veri toplamanın yasal dayanağı olmayabilir.” ChatGPT’ye göre, OpenAI’nin eğitim verilerinin kamu malı olduğunu iddia edebileceği çok çeşitli internet kaynakları üzerinde eğitildi. Bu argüman geçerli olmayabilir.

Örneğin, Clearview AI bir zamanlar Kanada kolluk kuvvetlerine ve özel sektör kuruluşlarına yüz tanıma hizmetleri sunuyordu. Bununla birlikte, Kanada Gizlilik Komiseri ve birkaç eyalet mahremiyet ofisi, bireylerin (ve çocukların) herkesin erişebileceği çevrimiçi görüntülerini, bilgileri veya rızaları olmadan orijinal görüntüleri ile ilgisi olmayan şekillerde kullanarak toplayarak federal ve eyalet mahremiyet yasalarını ihlal ettiğini tespit etti. amaç. Başka bir deyişle, bazı verilerin herkese açık olması onları herkes için ücretsiz yapmaz. Özel nitelikli kişisel verilerin kullanılmasına yönelik yeni bir amaç için yetki verilmeyeceğinden bu durum ihlal olarak görülmüştür.

Eğitim verilerinin kasıtlı olarak bozulmasından kaynaklanan ve ChatGPT’nin yanıtlarını etkileyecek güvenlik riski de vardır.

Cevap: Bağlı kalmama sonuçları olan daha katı düzenlemeler? Artan yapay zeka şeffaflığı mı? Eğitim veri süreçlerinin gözetimi? Teknoloji sahipleri ve kamu çıkar grupları arasında dengelenmiş daha büyük işbirliği? Üretken yapay zekanın toplumsal riskleriyle ilgili bir Al Jazeera makalesinde detaylandırıldığı üzere: “ChatGPT’nin OpenAI CEO’su Sam Altman, bir Senato alt komitesinin üyeleri önünde ifade verdi… kendi şirketinde ve diğerlerinde yaratılmakta olan ve giderek daha güçlü hale gelen yapay zeka teknolojisini düzenleme ihtiyacı hakkında. Google ve Microsoft gibi.”

ChatGPT istemleri

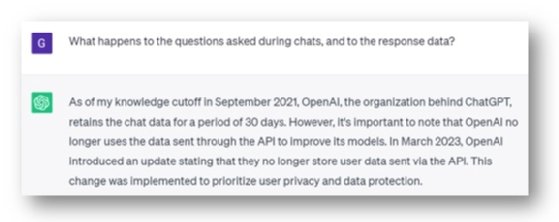

Open AI (ChatGPT oluşturucu), bir zamanlar sohbet verilerini 30 gün boyunca sakladı ve bunların bir kısmı modellerini geliştirmek için kullanıldı. ChatGPT’ye göre OpenAI, “kullanıcı gizliliğine ve veri korumasına öncelik vermek için” Mart 2023’ten itibaren bunu yapmayı bıraktı.

Ayrıca, Mart 2023’ten önce toplanan sohbet verileri, 30 günlük bir saklama politikasına tabiydi. Not: OpenAI’nin veri kullanımı ve saklama politikaları, ChatGPT’den gelen bir cevaba bağlı olarak değil, uygun bir siber risk değerlendirmesinin parçası olarak incelenmelidir.

Başka bir siber güvenlik riski, bir kullanıcının hassas kurumsal verileri analiz için ChatGPT’ye göndermesi gibi, hassas kurumsal verileri bilinmeyen bir varlığa vermeye benzer. Bu bir ihlaldir ve üçüncü taraf riski, ihlalin kapsamını daha da kötüleştirir. Riskler, verilerin uygun durum tespiti yapılmadan bir üçüncü taraf sistemine aktarılmasını ve bunun için uygun şekilde izlenen sistem düzeyinde yetkililerin atanmamasını içerir.

Peki ya platform olarak OpenAI kullanan üçüncü taraf araçlar? Bu soyutlama, platform ile araç arasındaki çelişkili politikalar ve sohbet ve yanıt depolama yaklaşımlarındaki farklılıklar gibi riskleri artırır. Bu, yalnızca OpenAI’de değil, soyutlama aracında da durum tespiti yapmak anlamına gelir. Ayrıca, herhangi bir düzeyde gönderildikten sonra istemin değiştirilmesi veya başka bir şekilde yeniden yönlendirilmesi gibi güvenlik riski de vardır, bu da istenmeyen eylemlerin geri döndürülmesine veya gerçekleştirilmesine neden olur.

Cevap: Kurumsal veri güvenliği politikalarını güncelleyin ve iletin. Uygunluklarından emin olmak için erişim kontrollerini kontrol edin. Üçüncü taraf durum tespiti süreçlerini geliştirin/uygulayın. Ayrıca, genel bulut ile özel bulut arasındaki fark gibi, genel sohbet robotları da şirketlerde ChatGPT’lerin yeteneklerinin daha güvenli bir şekilde piyasaya sürülmesini sağlamak için özel sohbet robotlarına dönüşebilir.

ChatGPT yanıtları

ChatGPT, savunmasız bir insan hedefle banka hesaplarının anahtarlarını teslim etmek veya ulusal kimlik ayrıntılarını ifşa etmek için güven oluşturacak kalitede e-posta veya telefon görüşmeleri yapmak için nahoş türler tarafından kullanılabilir. ChatGPT, bir görüşmenin meşru olup olmadığını belirlemeyi zorlaştırarak en büyük siber risklerden biri olan sosyal mühendisliği kolaylaştırır.

Bugün, siber güvenlik farkındalık kursları, kimlik avı e-postalarını tanımlamanın bir yolu olarak yazım, dilbilgisi ve konuşma anormalliklerini kontrol etmeyi öğretiyor. Telefon görüşmeleri için bu eğitim, arayanın kimlik bilgilerinin sorulmasını ve bunların doğrulanmasını kapsayabilir. Bununla birlikte, ortalama bir insan için, tipik kırmızı bayraklar ortaya çıkmazsa, kaç tanesi bu konuşmaların güvenilir olduğuna yanlış bir şekilde inanmaya yönlendirilebilir?

Ayrıca, özellikle bir güvenlik ortamında uygulandığında ChatGPT yanıtlarına aşırı bağımlılık riski vardır, bu da eğitim verilerini ve daha önce ortaya çıkan acil riskleri artırır. Bu nedenle, yanıtları doğrulama olmaksızın eyleme geçirmek, bir kuruluşu yeni güvenlik risklerine maruz bırakabilir.

Cevap: E-postalar için bir kırmızı bayrak anahtar olmaya devam ediyor: kaynak e-posta etki alanı. Telefon numaralarını kontrol edin ve arayanın kimliğini doğrulayın. Ayrıca, kurumsal siber güvenlik farkındalık eğitimi, karşılıklı etkileşimli yapay zeka araçlarını kapsamalıdır. Kritik senaryolarda, üzerinde işlem yapmadan önce ChatGPT yanıtlarını doğrulayın. Eleştirel düşünme her zamankinden daha önemli.

Çözüm

Bu makale, ChatGPT kullanımından kaynaklanan üç grup siber güvenlik sorununu inceledi. ChatGPT’nin yeni ortaya çıkan doğası, hızlı bir şekilde değişmesinin ve değişmeye devam etmesinin beklendiği anlamına gelir. Bu değişikliklere ayak uyduramamak, daha fazla risk getirecek ve bazı kontrollerin yararlılığını yitirmesine neden olacaktır. Her zaman olduğu gibi, kontrol etkinliği için risk kontrolü, özellikle hızla gelişen ortamlarda sık sık gözden geçirilmektedir.

Eski Google CEO’su Eric Schmidt, günümüzün yapay zeka sistemlerinin yakında sıfır gün istismarlarını gerçekleştirebileceği ve ABD’nin yapay zeka dünyasına hazırlıksız olduğu konusunda uyarıyor. Nihayetinde, yeni nesil yapay zeka araçlarını kullandığımız için – kurumsal ve bağımsız – yepyeni bir siber güvenlik sorunları dünyası var. Bilmediğimiz çok şey olsa da, üretken yapay zeka henüz emekleme aşamasındayken bu yeni tehditler karşısında proaktif olmak en iyisidir.

Guy Pearce, ISACA Gelişen Trendler Çalışma Grubu’nun bir üyesidir.