Çalışanların ChatGPT gibi büyük dil modellerine (LLM’ler) hassas iş verileri ve gizlilikle korunan bilgiler göndermesi, yapay zeka (AI) hizmetlerinin verileri modellerine dahil edebileceği ve bu bilgilerin daha sonraki bir tarihte alınabileceği endişelerini artırıyor hizmet için uygun veri güvenliği yoksa.

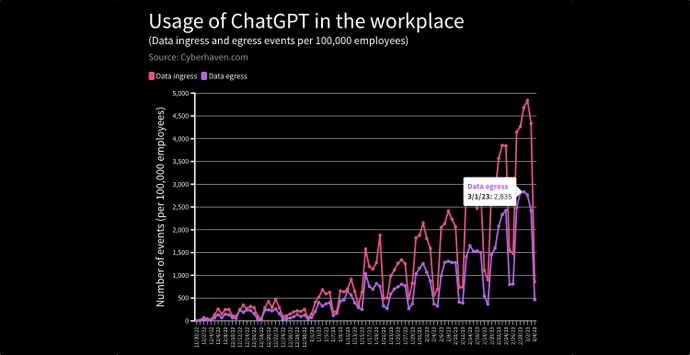

Yakın tarihli bir raporda, veri güvenliği hizmeti Cyberhaven, müşteri şirketlerindeki 1,6 milyon çalışanın %4,2’sinin ChatGPT’ye veri girme isteklerini, gizli bilgilerin, müşteri verilerinin, kaynak kodunun veya düzenlenmiş bilgilerin şirkete sızdırılması riski nedeniyle tespit etti ve engelledi. LLM.

Bir vakada, bir yönetici firmanın 2023 strateji belgesini kesip ChatGPT’ye yapıştırdı ve ondan bir PowerPoint destesi oluşturmasını istedi. Başka bir durumda, bir doktor hastanın adını ve tıbbi durumunu girdi ve ChatGPT’den hastanın sigorta şirketine bir mektup yazmasını istedi.

Cyberhaven CEO’su Howard Ting, daha fazla çalışan üretkenlik araçları olarak ChatGPT ve diğer yapay zeka tabanlı hizmetleri kullandıkça, riskin artacağını söylüyor.

“Şirket içinden buluta büyük bir veri geçişi oldu ve bir sonraki büyük değişim, verilerin bu üretken uygulamalara taşınması olacak” diyor. “Ve bu nasıl oynanır [remains to be seen] — Sanırım, oyun öncesindeyiz; ilk vuruşta bile değiliz.”

OpenAI’nin ChatGPT’sinin ve temel AI modelinin (Gerative Pre-trained Transformer veya GPT-3) ve diğer LLM’lerin artan popülaritesi ile şirketler ve güvenlik uzmanları, modellere eğitim verileri olarak alınan hassas verilerin yeniden ortaya çıkabileceği konusunda endişelenmeye başladı. doğru sorgular tarafından istendiğinde. Bazıları harekete geçiyor: Örneğin JPMorgan, çalışanların ChatGPT kullanımını kısıtladı ve Amazon, Microsoft ve Wal-Mart’ın tümü, üretken yapay zeka hizmetlerini kullanırken dikkatli olmaları için çalışanlara uyarılar yayınladı.

Hukuk firması Seyfarth Shaw’un ortaklarından Karla Grossenbacher, daha fazla yazılım firması uygulamalarını ChatGPT’ye bağladığından, LLM’nin kullanıcıların – veya şirketlerinin – farkında olduğundan çok daha fazla bilgi topluyor olabileceği ve onları yasal risk altına sokabileceği konusunda uyardı. Bloomberg Yasası sütunu.

“İhtiyatlı işverenler – çalışan gizlilik anlaşmalarına ve politikalarına – çalışanların yapay zeka sohbet robotlarına veya ChatGPT gibi dil modellerine gizli, özel veya ticari sır bilgilerine atıfta bulunması veya bunlara girmesine ilişkin yasaklar ekleyecektir” diye yazdı. “Diğer taraftan, ChatGPT çok çeşitli çevrimiçi bilgi konusunda eğitildiğinden, çalışanlar araçtan ticari markalı, telif hakkıyla korunan veya başka bir kişi veya kuruluşun fikri mülkiyetindeki bilgileri alıp kullanabilir ve bu da işverenler için yasal risk oluşturabilir.”

Risk teorik değildir. Haziran 2021 tarihli bir makalede, Apple, Google, Harvard Üniversitesi ve Stanford Üniversitesi dahil olmak üzere şirketler ve üniversitelerin bir Who’s Who listesinden bir düzine araştırmacı, “eğitim verisi çıkarma saldırılarının” kişisel olarak kelimesi kelimesine metin dizilerini başarılı bir şekilde kurtarabileceğini buldu. tanımlanabilir bilgiler (PII) ve LLM’den GPT-2 olarak bilinen eğitim belgelerindeki diğer bilgiler. Araştırmacılar makalede, aslında, bir LLM’nin birebir verileri ezberlemesi için yalnızca tek bir belgenin gerekli olduğunu belirtti.

GPT’nin Beynini Seçmek

Gerçekten de, bu eğitim verisi çıkarma saldırıları, makine öğrenimi araştırmacıları arasındaki en önemli düşmanca endişelerden biridir. MITRE’nin Yapay Zeka Sistemleri için Düşman Tehdit Manzarası (Atlas) bilgi tabanına göre, “makine öğrenimi çıkarımı yoluyla sızma” olarak da bilinen saldırılar, hassas bilgiler toplayabilir veya fikri mülkiyeti çalabilir.

Şu şekilde çalışır: Üretici bir AI sistemini belirli öğeleri hatırlayacak şekilde sorgulayan bir saldırgan, modeli sentetik veriler oluşturmak yerine belirli bir bilgi parçasını hatırlaması için tetikleyebilir. GitHub’ın Yardımcı Pilotunun belirli bir geliştiricinin kullanıcı adını ve kodlama önceliklerini hatırladığı bir örnek de dahil olmak üzere GPT-2’nin halefi olan GPT-3 için bir dizi gerçek dünya örneği mevcuttur.

GPT tabanlı tekliflerin ötesinde, diğer yapay zeka tabanlı hizmetler, risk oluşturup oluşturmadıklarına dair soruları gündeme getirdi. Örneğin, otomatik transkripsiyon hizmeti Otter.ai, ses dosyalarını metne dönüştürerek konuşmacıları otomatik olarak tanımlar ve önemli kelimelerin etiketlenmesine ve ifadelerin vurgulanmasına izin verir. Şirketin bu bilgileri kendi bulutunda barındırması gazeteciler için endişe yarattı.

Otter.ai Kıdemli Uyumluluk Yöneticisi Julie Wu’ya göre şirket, kullanıcı verilerini gizli tutmayı ve güçlü uyumluluk denetimleri uygulamayı taahhüt ettiğini söylüyor.

Dark Reading’e “Otter, SOC2 Tip 2 denetimini ve raporlarını tamamladı ve kişisel verileri korumak için teknik ve organizasyonel önlemler alıyoruz” dedi. “Konuşmacı kimliği hesaba bağlıdır. Bir konuşmacının adını eklemek, Otter’ı gelecekteki kaydettiğiniz veya hesabınıza aktardığınız konuşmalar için konuşmacıyı tanıması için eğitecektir”, ancak konuşmacıların hesaplar arasında tanımlanmasına izin vermez.

API’ler Hızlı GPT Benimsemesine İzin Veriyor

ChatGPT’nin popülaritesi birçok şirketi şaşırttı. Bir yıl önce yayınlanan son rakamlara göre 300’den fazla geliştirici, uygulamalarını güçlendirmek için GPT-3 kullanıyor. Örneğin, sosyal medya şirketi Snap ve alışveriş platformları Instacart ve Shopify, mobil uygulamalarına sohbet işlevi eklemek için API aracılığıyla ChatGPT kullanıyor.

Cyberhaven’den Ting, şirketinin müşterileriyle yaptığı görüşmelere dayanarak, notlar ve sunumlar oluşturmaktan güvenlik olaylarını önceliklendirmeye ve hastalarla etkileşime geçmeye kadar her şey için kullanılmak üzere üretken yapay zeka uygulamalarına geçişin yalnızca hızlanmasını bekliyor.

Müşterilerinin ona şunları söylediğini söylüyor: “Bak, geçici bir önlem olarak şu anda bu uygulamayı engelliyorum, ancak yönetim kurulu bana bunu yapamayacağımızı zaten söyledi. Çünkü bu araçlar, kullanıcılarımızın daha üretken olmasına yardımcı olacak. — rekabet avantajı var — ve rakiplerim bu üretken yapay zeka uygulamalarını kullanıyorsa ve ben kullanıcılarımın kullanmasına izin vermiyorsam, bu bizi dezavantajlı duruma düşürür.”

İyi haber şu ki, riskli taleplerin çoğundan az sayıda çalışan sorumlu olduğundan, eğitimin belirli bir şirketten veri sızıntısı olup olmadığı üzerinde büyük bir etkisi olabilir. Cyberhaven’den Ting, ChatGPT’ye hassas veri gönderme olaylarının %80’inden çalışanların %1’inden daha azının sorumlu olduğunu söylüyor.

“Biliyorsunuz, iki tür eğitim vardır: Bir çalışanı işe alırken olduğu gibi sınıf eğitimi var ve ardından biri gerçekten veri yapıştırmaya çalışırken bağlam içi eğitim var” diyor. “Her ikisinin de önemli olduğunu düşünüyorum, ancak ikincisinin gördüğümüzden çok daha etkili olduğunu düşünüyorum.”

Buna ek olarak, OpenAI ve diğer şirketler, LLM’nin kişisel bilgilere ve hassas verilere erişimini sınırlamak için çalışmaktadır: Kişisel ayrıntıların veya hassas kurumsal bilgilerin sorulması, şu anda ChatGPT’nin uyma konusunda itirazda bulunduğu hazır beyanlara yol açmaktadır.

Örneğin, “Apple’ın 2023 stratejisi nedir?” ChatGPT şu yanıtı verdi: “Bir AI dil modeli olarak, Apple’ın gizli bilgilerine veya gelecek planlarına erişimim yok. Apple oldukça gizli bir şirkettir ve genellikle stratejilerini veya gelecek planlarını yayınlamaya hazır olana kadar halka açıklamazlar. onlara.”