Yakın zamanda yapılan bir keşifte araştırmacılar, siber suçluların odaklarını modern yapay zekaya (AI) güç veren sistemlere çevirdiğini keşfetti. Ekim 2025 ile Ocak 2026 arasında, özel bir balküpü (güvenlik uzmanları tarafından bilgisayar korsanlarını yakalamak için kurulan bir tuzak) 91.403 saldırı oturumu kaydetti.

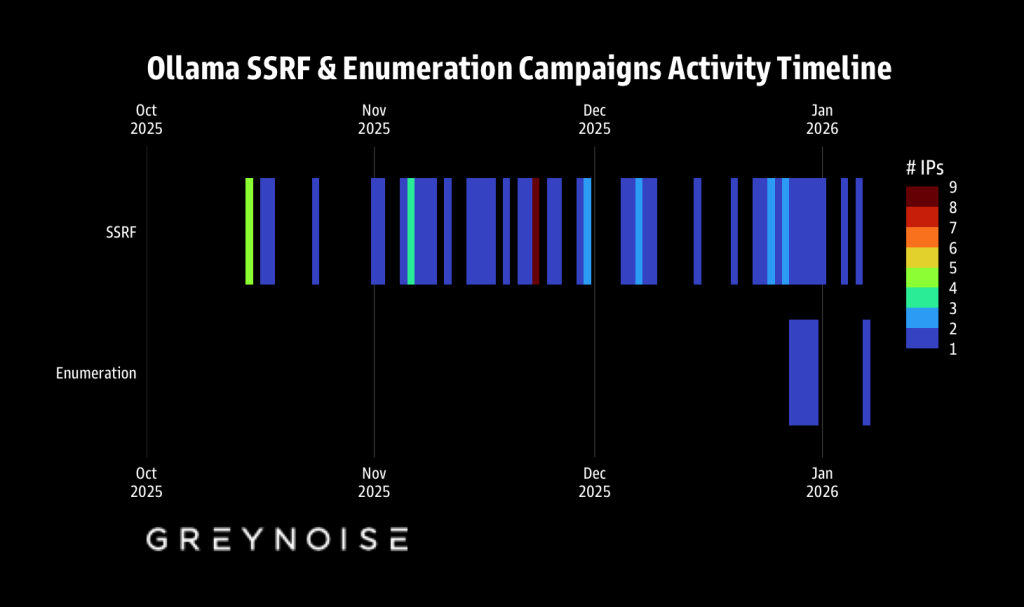

Bu soruşturma, yem görevi görmesi için Ollama adlı popüler bir yapay zeka aracının sahte kurulumlarını kuran araştırma firması GreyNoise tarafından yürütüldü. Araştırma, iş başında sadece tek bir grup olmadığını, her biri büyüyen yapay zeka dünyasından yararlanmanın farklı bir yolunu bulmaya çalışan iki ayrı kampanyanın aktif olduğunu ortaya koyuyor.

Ev Telefonu Hilesi

İlk grup saldırgan, Sunucu Tarafı İstek Sahteciliği (SSRF) olarak bilinen bir yöntem kullandı. Basitçe söylemek gerekirse bu, bir bilgisayar korsanının bir şirketin sunucusunu, bilgisayar korsanının kendi bilgisayarıyla bağlantı kurması için kandırdığı bir hiledir. Araştırmacılar, saldırganların özellikle Ollama ve Twilio’yu (popüler bir mesajlaşma servisi) hedef aldığını belirtti.

“Kötü amaçlı bir kayıt URL’si” göndererek, AI sunucusunu kendi sistemlerine “telefonla telefon etmeye” zorlayabilirler. GreyNoise’un blog gönderisine göre, bu etkinliğin yalnızca 48 saat içinde 1.688 oturumla “Noel’de dramatik bir artış” yaşadığını belirtmekte fayda var. Bunlardan bazıları güvenlik araştırmacıları veya ödül arayan ödül avcıları olsa da zamanlama, BT ekipleri tatildeyken sınırları zorladıklarını gösteriyor.

Yapay Zeka Modelleri İçin Bir İsabet Listesi Oluşturmak

İkinci kampanya daha da endişe verici. 28 Aralık 2025’ten itibaren iki özel dijital adres (45.88.186.70 Ve 204.76.203.125) 73’ten fazla farklı yapay zeka uç noktasında büyük, metodik bir arama başlattı. Araştırma sırasında araştırmacılar, hangi yapay zeka modellerine ulaşabileceklerini görmek için yalnızca on bir günde 80.469 oturum oluşturduklarını buldu.

Araştırmacılara göre bunlar, henüz bir şeyleri bozmaya çalışmadıkları için muhtemelen keşif yapan profesyonel aktörlerdi. Ayrıca aktörlerin Anthropic (Claude), Meta (Llama), xAI (Grok) ve DeepSeek gibi büyük isimlerin modellerini test ederek “hedef listeleri oluşturduklarını” belirttiler.

“Saldırı, hem OpenAI uyumlu API formatlarını hem de Google Gemini formatlarını test etti. Her ana model ailesi araştırma listesinde yer aldı: OpenAI (GPT-4o ve çeşitleri), Anthropic (Claude Sonnet, Opus, Haiku), Meta (Llama 3.x), DeepSeek (DeepSeek-R1), Google (Gemini), Mistral, Alibaba (Qwen) ve xAI (Grok).”

Gri Gürültü

Daha ayrıntılı incelemeler, bu saldırganların “Amerika Birleşik Devletleri’nde kaç eyalet var?” gibi basit ve masum sorular kullandıklarını ortaya çıkardı. sadece hangi modellerin yanıt vereceğini görmek için.

Sistemlerinizi Nasıl Korursunuz?

GreyNoise’daki araştırmacılar, bu sistemleri güvende tutmak için şirketlerin yapay zeka modellerinin yalnızca güvenilir kaynaklardan indirilmesine izin vermesi gerektiğini öne sürüyor. Aynı basit soruları tekrar tekrar soran hızlı taleplere karşı dikkatli olmak da önemlidir. Bu saldırıların ölçeği çok büyük; 27 ülkedeki 62 kaynak IP’yi içeriyor; bu da bilgisayar korsanlarının bir sonraki büyük hamlelerini planladıklarının açık bir işareti.

Yapay Zeka Risklerine İlişkin Uzman Uyarıları

Güvenlik ekipleri bu bulguları çok daha geniş bir riskin erken uyarısı olarak görüyor. Zenity Güvenlik Stratejisi Başkan Yardımcısı Chris Hughes, bakış açısını yalnızca Hackread.com ile paylaştı ve modelleri araştırmak bir endişe kaynağı olsa da, acil tehlikenin AI ajanlarının şirket sistemleriyle nasıl etkileşimde bulunduğunda yattığını belirtti.

Hughes, “Bu, saldırganların yapay zeka sistemlerini hedef aldığına dair ilk kamuoyu onayı olsa da kesinlikle son olmayacak” dedi. Bu araştırmalardan elde edilen bilgilerin muhtemelen gelecekteki saldırılar için kullanılacağını açıkladı. Yapay zeka araçlarının kurumsal sistemlere veya bulut ortamlarına uygun gözetim olmadan erişmesi durumunda daha büyük riskin ortaya çıkacağı konusunda uyardı.

“Saldırganlar modelleri araştırmaktan aracıları kullanmaya doğru ilerledikçe, yalnızca model merkezli güvenliğe odaklanan kuruluşlar, geleceğini hiç tahmin etmedikleri olaylara yanıt verecek” diye ekledi.

(Unsplash’ta Egor Komarov’un fotoğrafı)