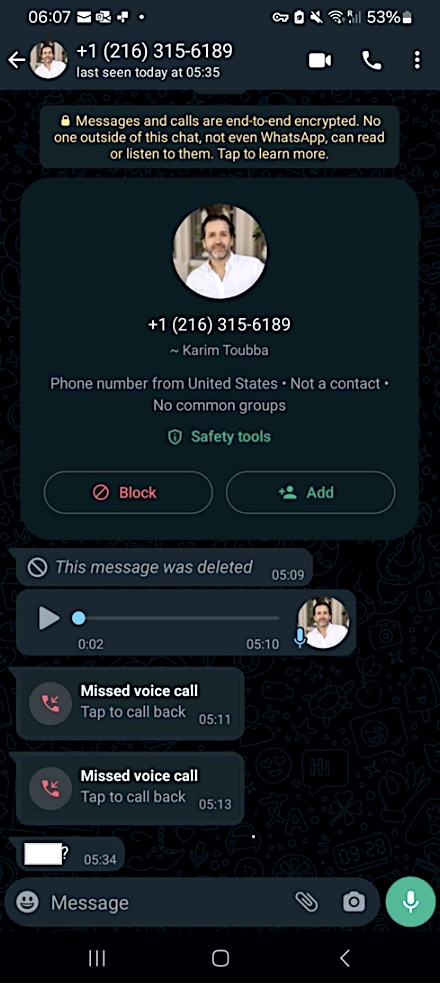

LastPass bu hafta, tehdit aktörlerinin, şirketin İcra Kurulu Başkanı Karim Toubba’nın kimliğine bürünmek için derin sahte ses kullanarak sesli kimlik avı saldırısında çalışanlarından birini hedef aldığını açıkladı.

Bununla birlikte, insanların %25’i AI ses kimliğine bürünme dolandırıcılığının hedefi olmuş veya yakın zamanda yapılan küresel bir araştırmaya göre LastPass çalışanı, saldırganın WhatsApp’ı kullanması nedeniyle bu tuzağa düşmemiş ya da bunu yapan birini tanıyor. çok nadir iş kanalı.

LastPass istihbarat analisti Mike Kosak, “Bizim durumumuzda, bir çalışanımız WhatsApp aracılığıyla CEO’muzun kimliğine bürünen bir tehdit aktöründen bir dizi çağrı, mesaj ve derin sahte ses içeren en az bir sesli mesaj aldı.” dedi.

“İletişim girişimi normal iş iletişim kanallarının dışında olduğundan ve çalışanın bir sosyal mühendislik girişiminin (zorunlu aciliyet gibi) birçok özelliğinin varlığına ilişkin şüphesi nedeniyle, çalışanımız haklı olarak mesajları görmezden geldi ve olayı yöneticimize bildirdi. Böylece hem tehdidi azaltacak hem de hem içeride hem de dışarıda taktikle ilgili farkındalığı artıracak adımlar atabildik.”

Kosak, saldırının başarısız olduğunu ve LastPass üzerinde herhangi bir etkisinin olmadığını sözlerine ekledi. Ancak şirket yine de diğer şirketleri, yapay zeka tarafından oluşturulan deepfake’lerin yönetici kimliğine bürünme dolandırıcılık kampanyalarında kullanıldığı konusunda uyarmak için olayın ayrıntılarını paylaşmayı tercih etti.

Bu saldırıda kullanılan deepfake ses, muhtemelen LastPass CEO’sunun halka açık ses kayıtları üzerinde eğitilmiş deepfake ses modelleri kullanılarak oluşturuldu ve bu muhtemelen YouTube’da mevcuttur.

Deepfake saldırıları artıyor

LastPass’ın uyarısı, ABD Sağlık ve İnsani Hizmetler Bakanlığı’nın (HHS) geçen hafta siber suçluların hedeflerini aldatmak için sosyal mühendislik taktikleri ve yapay zeka ses klonlama araçlarını kullanarak BT yardım masalarını hedef almasıyla ilgili yayınlanan uyarının ardından geldi.

Sesli deepfake kullanımı aynı zamanda tehdit aktörlerinin arayanın kimliğini uzaktan doğrulamayı çok daha zorlaştırmasına olanak tanıyarak yöneticilerin ve şirket çalışanlarının kimliğine büründükleri saldırıların tespit edilmesini çok zorlaştırıyor.

HHS, sağlık sektöründeki kuruluşların BT yardım masalarını hedef alan saldırılara özel tavsiyeler paylaşsa da, aşağıdakiler CEO kimliğine bürünme dolandırıcılığı girişimleri için de büyük ölçüde geçerlidir:

- Parola sıfırlama ve yeni MFA cihazları isteyen çalışanların doğrulanması için geri arama yapılmasını zorunlu kılın.

- Şüpheli ACH değişikliklerini izleyin.

- Ödeme yapan web sitelerine erişimi olan tüm kullanıcıları yeniden doğrulayın.

- Hassas konularda şahsen yapılan talepleri değerlendirin.

- Denetçilerin istekleri doğrulamasını zorunlu kılın.

- Sosyal mühendislik tekniklerini belirleyip raporlamak ve arayanların kimliklerini doğrulamak için yardım masası personelini eğitin.

Mart 2021’de FBI ayrıca bir Özel Sektör Bildirimi (PIN) yayınladı. [PDF] AI tarafından oluşturulan veya manipüle edilen ses, metin, görüntü veya video dahil olmak üzere derin sahtekarlıkların giderek daha karmaşık hale geldiği ve büyük olasılıkla bilgisayar korsanları tarafından “siber ve yabancı etki operasyonlarında” yaygın olarak kullanılacağı konusunda uyardı.

Ek olarak Europol, Nisan 2022’de deepfake’lerin yakında siber suçlu gruplarının CEO dolandırıcılığı, delilleri tahrif etme ve rıza dışı pornografi oluşturma amacıyla rutin olarak kullandığı bir araç haline gelebileceği konusunda uyardı.