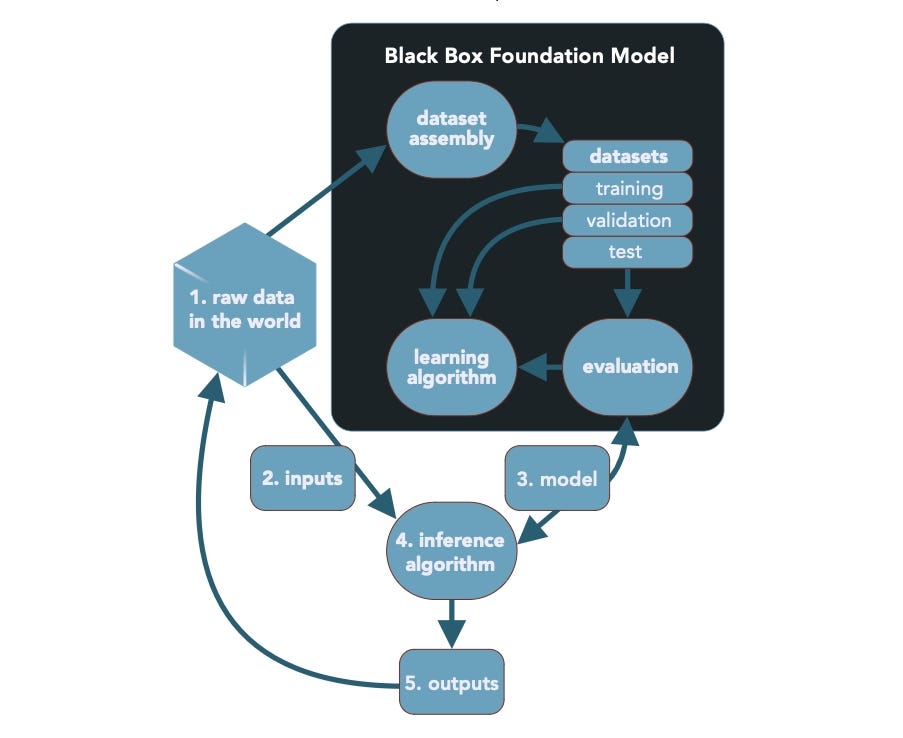

Büyük dil modellerinin (LLM’ler) güvenlik sorunlarının çoğu basit bir gerçeğe dayanmaktadır: Tüm LLM’lerin kalbi bir kara kutudur.

Yüksek Lisans’ın son kullanıcıları genellikle sağlayıcıların modellerini eğitmek için kullanılan verileri nasıl toplayıp temizledikleri hakkında çok fazla bilgiye sahip değildir ve bilgi hacmi çok büyük olduğundan model geliştiricileri genellikle veriler üzerinde yalnızca yüzeysel bir değerlendirme yapar. Berryville Makine Öğrenimi Enstitüsü’nün (BIML) Yüksek Lisans’larla ilişkili 81 riski tanımlayan yeni bir raporuna göre, yapay zekanın (AI) kararları nasıl aldığına ilişkin bu görünürlük eksikliği, Yüksek Lisans’ların oluşturduğu risklerin dörtte birinden fazlasının temel nedenidir. .

“Büyük Dil Modellerinin Mimari Risk Analizi” başlıklı raporun amacı, CISO’lara ve diğer güvenlik uygulayıcılarına, makine öğrenimi (ML) ve yapay zeka modellerinin, özellikle de LLM’lerin ve sonraki teknolojilerin oluşturduğu riskler hakkında bir düşünme yöntemi sağlamaktır. BIML’in kurucu ortağı Gary McGraw, “büyük multimodal modellerin (LMM’ler) oluşturulması sayesinde bu riskleri kendi uygulamalarında tanımlayabiliyorlar” diyor.

McGraw, “Kara kutudakiler, siz risklerin ne olduğunu bile bilmeden Google, Open AI, Microsoft ve Meta tarafından sizin adınıza alınan risk kararlarıdır” diyor. “Kara kutuyu açıp bazı soruları yanıtlamanın çok yararlı olacağını düşünüyoruz.”

Rekabetçi Yapay Zeka için Ortak Bir Dil

İşletmeler yapay zeka modellerini benimsemek için acele ettikçe, bu modellerin riskleri ve güvenliği giderek daha önemli hale geldi. BIML’deki araştırmacılar Rakip yapay zeka ve makine öğrenimi güvenliği kaosuna düzen getirmeye çalışan tek grup onlar değil. Ocak ayı başında ABD Ulusal Standartlar ve Teknoloji Enstitüsü (NIST) şunları yayınladı: Son sürüm Yapay zekaya yönelik tehditleri tartışmak için ortak bir dil oluşturmaya odaklanan “Çekişmeli Makine Öğrenimi: Saldırı ve Azaltmaların Taksonomisi ve Terminolojisi”.

NIST belgesi yapay zeka ortamını iki geniş kategoriye ayırıyor: tahminlerde bulunmak için kullanılan modeller (PredAI) ve yüksek lisans öğrenimi gibi içerik oluşturmak için kullanılan modeller (GenAI). NIST’e göre, tahmine dayalı yapay zeka modelleri tipik tehdit üçlüsünden (gizlilik, bütünlük ve kullanılabilirlik) muzdaripken, üretken yapay zeka sistemleri aynı zamanda sorgulara veya kaynaklara erişen hızlı enjeksiyon gibi kötüye kullanımlarla da uğraşmak zorunda.

NIST’in bilgisayar güvenliği bölümünde araştırma ekibi yöneticisi ve NIST raporunun ortak yazarlarından Apostol Vassilev, daha fazla araştırmacının alana girmesi nedeniyle ortak bir terminoloji bulmanın önemli olduğunu söylüyor.

“Şirketler artık üretken yapay zekayı ana ürün gruplarına dahil etti ve bu yeni teknoloji dalgası yakında kitlesel pazara ulaşacak” diyor. “Dolayısıyla, insanların neye bulaştıklarını ve bu yeni olguya en iyi nasıl hazırlanabileceklerini önceden bilmeleri için makine öğreniminde neler olup bittiğini anlamak önemlidir.”

NIST’e göre araştırmacılar, son iki yılda çevrimiçi yayıncılık platformu ArXiv’de çekişmeli makine öğrenimi üzerine 5.000’den fazla makale yayınladı. Önceki on yılda, 2011 ile 2020 arasında 3.500’den az makale yayınlandı.

Yüksek Lisans’ın Kara Kutusu

BIML’den McGraw, GenAI ve diğer birçok makine öğrenimi modelinin oluşturulmasının büyük bir kısmının analitik hacklemelerden kaynaklandığını söylüyor. Büyük veri modelleri, geliştiricilerin veya makine öğrenimi uzmanlarının görevi gerçekleştirmek için açık bir programın nasıl yazılacağını bilmeden, girdiler ve çıktılar arasında ilişki kurmak için verileri kullanacak şekilde bir makineyi eğitmekle ilgilidir.

Yüksek Lisans oluşturma adımlarının çoğu bilinmiyor ve potansiyel olarak bilinemez. Kaynak: BIML

“Yapabileceğiniz tek şey, büyük bir ‘ne’ yığını elde etmek ve bir makineyi ‘ne’ olacak şekilde eğitmektir; makine öğrenimi de bunun içindir” diyor. “Sorun şu ki, bunu büyük bir ‘ne’ yığınıyla yaptığımızda, nasıl çalıştığını hala bilmiyoruz. Yani bu büyük ‘ne’ yığınının nereden geldiğini anlamak için yapabileceğimiz her şey, o kadar iyi olur ‘olacak.”

BIML makalesinde” araştırmacılar bunun üzerine inşa etti enstitünün genel makine öğrenimi raporunda daha önce tanımlanan 78 risk. BIML’den McGraw, araştırmacıların LLM’lerin karşılaştığı 81 risk tespit ettiğini ve 23’ünü doğrudan kara kutu sorunlarıyla ilgili olarak sınıflandırdığını söylüyor.

“Makine öğrenimine karşı değiliz” diyor. “Bebeği atın demiyoruz [with the bath water]. Neden o bebeği fırçalamıyorsun diyoruz. Dur bir dakika, bize tam olarak söyle, küveti nereden aldın?”

Yüksek Lisans mimarisinin büyük bir kısmı kara kutu içinde olduğunda savunmaların oluşturulması neredeyse imkansız olduğundan hükümet düzenlemelerine ihtiyaç vardır. McGraw, düzenleyicilerin bu modellerin kullanıcıları için değil, kara kutu ve LLM temel modelleri için kurallar oluşturmaya odaklanması gerektiğini söylüyor.

“[T]BIML araştırmacıları makalede, LLM temel modelleri oluşturan şirketlerin dünyaya getirdikleri risklerden sorumlu tutulmaları gerektiğini belirtiyor. “Ayrıca, LLM’lerin kullanımını kontrol etmeden kullanımlarını kontrol ederek kısıtlamaya çalışmanın da mümkün olduğuna inanıyoruz. tasarım ve uygulama aptallıktır.”

Daha İyi Savunma, Daha İyi Politika

Savunmalar temel olsa da saldırılar da temeldir çünkü saldırganlar hedeflerine yapay zekayı hedeflemekten ziyade geleneksel bir siber saldırıyla daha kolay ulaşabilirler. Koruma AI’nın başkanı ve kurucusu Daryan Dehghanpisheh, yapay zeka modellerini hedef alan saldırganların genellikle üç şeyden birinin peşinde olduğunu söylüyor: Modeli kandırmak, modelin fikri mülkiyetini çalmak veya modelden veri çıkarmak veya manipüle etmek istiyorlar.

“Eğer ben kötü oyuncuysam ve bu üç şeyden herhangi birini başarmak istiyorsam, bunu yapmanın çok daha kolay yolları olduğunu düşünüyoruz” diyor. “Bir şirketin ML veya AI mühendislerini avlamak, dışarı çıkıp tüm LinkedIn profillerini kazımak… ve sonra başka bir varlık gibi görünüp onlara sosyal mühendislik yapmak.”

Modelleri savunmak da çok zordur. NIST’ten Vassilev, esasen LLM’lerin çevresine korkuluklar koymaya çalışan mevcut yaklaşımların atlatılmasının kolay olduğunu çünkü kötü niyetli istemlerin eninde sonunda herhangi bir kural dizisini atlayabileceğini söylüyor.

“Mevcut olan hafifletici önlemlerin neredeyse tamamının sınırlı ve eksik olduğu ortaya çıktı” diyor. “Daha iyi savunma hatları ve kendimizi nasıl koruyacağımıza dair daha iyi teknikler bulana kadar bir süre hücumcular ve savunmacılar arasında bir kedi-fare oyunu oynayacağız.”