Çoğu kuruluş güçlü AI modeli yönetişime olan ihtiyacı anlasa da, birçoğu hala benimsenmeyi ve riski artırabilecek boşlukları kapatmaya çalışıyor. 300’den fazla AI uygulayıcısı ve karar vericinin yeni bir Anaconda anketinin bulguları, açık kaynaklı araçlar, tutarsız model izleme ve parçalanmış AI araç zincirlerinin neden olduğu operasyonel zorluklardaki güvenlik endişelerini vurgulamaktadır.

Doğrulamaya rağmen güvenlik endişeleri yüksek kalır

Açık kaynaklı yazılım AI gelişiminin merkezinde yer alır, ancak dikkatle yönetilmesi gereken tedarik zinciri riskleri getirir. Katılımcıların çoğu, güvenlik ve uyumluluk için Python paketlerini doğrulamak için süreçlere sahiptir. Bunlar, otomatik güvenlik açığı taramalarından dahili paket kayıtlarının ve manuel incelemelerin korunmasına kadar değişir.

Buna rağmen, katılımcıların yüzde 39’u tarafından belirtilen güvenlik en yaygın AI kalkınma riski olmaya devam etmektedir. Kuruluşların neredeyse üçte ikisi, güvenlik endişeleri nedeniyle AI dağıtımlarında gecikmelerle karşılaşmıştır ve birçoğu, sorunu gidermek için harcanan bağımlılık sorunlarının verimliliğe dönüştüğünü bildirmektedir. Çoğu takım güvenlik açıklarını giderebileceklerinden emin olsa da, olayların sıklığı mevcut yaklaşımların AI projelerinin ölçeğine ve karmaşıklığına ayak uydurmak için yeterli olmadığını göstermektedir.

Yönetişimi geliştirmek için en önemli öncelikler sorulduğunda, en yaygın yanıt, geliştirme ve güvenlik iş akışlarını birleştiren daha iyi entegre araçlardı. Katılımcılar ayrıca model bileşenlerine ve ek ekip eğitimine daha iyi görünürlük ihtiyacına dikkat çekti.

Model izleme kuruluşlar arasında eşit değil

Anket, model soyunun izlenmesinin önemi konusunda güçlü bir farkındalık buldu, kuruluşların yüzde 83’ü temel modellerin kökenlerini belgelediklerini ve yüzde 81’inin model bağımlılıklarının kayıtlarını tuttuğunu bildirdi. Bununla birlikte, bu belgelerin tümü kapsamlı değildir ve beş katılımcıdan neredeyse birinin resmi bir belgesi yoktur.

Performans izleme benzer bir boşluk gösterir. Ankete katılanların yüzde 70’inin model sürüklenmesini veya beklenmedik davranışları tespit etmek için mekanizmalara sahipken, yüzde 30’unun üretimde resmi bir izlemesi yoktur. Ortak uygulamalar arasında otomatik performans izleme, anomaliler için uyarı sistemleri ve periyodik manuel incelemeler bulunmaktadır. Daha olgun ekipler ayrıca A/B test ve yeniden eğitme programları kullanır, ancak bu yaklaşımlar evrensel olmaktan uzaktır.

Tutarlı izleme eksikliği, hem uyumluluğu hem de performansı etkileyen kör noktalar bırakabilir. Yapay zeka üretim ortamlarına daha da derinlemesine geçtikçe, sürüklenmeyi tespit etme ve yanıtlama yeteneği kritik bir yönetişim işlevi haline gelecektir.

Parçalanmış araç zincirleri yönetişim ilerlemesini yavaşlatıyor

Kuruluşların sadece yüzde 26’sı, son derece birleşik bir AI geliştirme araç zincirine sahip olduğunu bildirmektedir. Geri kalanı kısmen birleşik ve parçalanmış kurulumlar arasında bölünür, küçük ama dikkate değer bir kısım, araç zincirlerini oldukça parçalanmış olarak tanımlar.

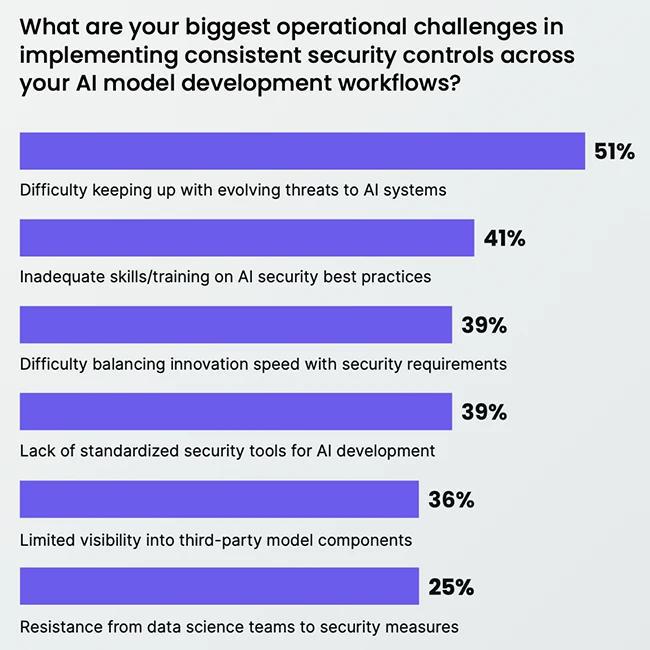

Parçalanma, görünürlük boşlukları yaratarak, çaba çaba harcayarak ve tutarsız güvenlik kontrolleri getirerek yönetişimi zorlaştırabilir. Ayrıca, takımların gözetim olmadan onaylanmamış araçlar kullandığı Gölge BT riskini de artırır. Yönetişim süreçleri farklı sistemlere katmanlandığında, yavaş ve hantal olabilirler, bu da ekipleri onları atlamaya teşvik eder.

Anket, araçların ve süreçlerin birleştirilmesinin de kültürel bir zorluk olduğunu göstermektedir. Veri bilimi ekiplerinden güvenlik önlemlerine direniş, katılımcıların yüzde 25’inin kilit bir konu olarak gösterilmiştir. Yönetişimi günlük iş akışlarına yerleştiren entegre platformlar bu sürtünmeyi azaltabilir ve yeniliği gözetim ile hizalamaya yardımcı olabilir.