Gennomis’te büyük bir veri sızıntısı olayı, tarafından yürütülen bir platform Güney Koreli AI firması AI-Nomis, AI tarafından üretilmemiş AI tarafından üretilen içeriğin riskleri hakkında ciddi endişeler getirdi.

Bilgileriniz için Gennomis, kullanıcıların metin istemlerinden sınırsız görüntüler oluşturmasına, AI kişileri oluşturmasına ve 45’ten fazla sanatsal stil ve kullanıcı tarafından oluşturulan görüntüleri satın almak ve satmak için bir pazar ile yüz değiştirme gerçekleştirmesine olanak tanıyan AI destekli bir görüntü oluşturma platformudur.

Hangi veriler ortaya çıktı?

Hackread.com ile paylaşılan VPNmentor’un raporuna göre, siber güvenlik araştırmacısı Jeremiah Fowler, 93.485 görüntü ve JSON dosyalarını kapsayan şaşırtıcı 47.8 gigabayt veri içeren halka açık bir veritabanı ortaya çıkardı.

Bu bilgi, rahatsız edici bir açıklama koleksiyonu ortaya çıkardı AI tarafından üretilen malzemeyüz sarılmış görüntüler ve reşit olmayan bireyler gibi görünen tasvirler. Maruz kalan kayıtların sınırlı olarak incelenmesi, reşit olmayanların potansiyel sömürüsü hakkında kırmızı bayraklar yetiştiren AI tarafından üretilen görüntüler de dahil olmak üzere pornografik içerik yaygınlığı gösterdi.

Olay bildirilmiş Bu karanlık ağ pedofilleri, çocuk cinsel istismarı malzemesi üretmek için açık kaynaklı AI araçlarını kullanıyor (CSAM). Veri sızıntısı da aylar sonra gelir

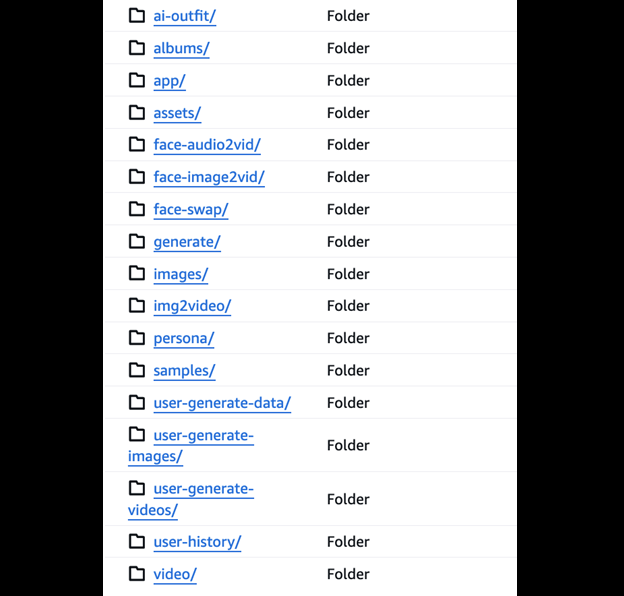

Fowler bildirilmiş Ariana Grande ve Michelle Obama gibi figürler de dahil olmak üzere çocuk olarak tasvir edilen ünlülerin yanı sıra açık durumlarda küçükleri tasvir eden çok sayıda görüntüyü görmek. Veritabanı ayrıca, oluşturulan görüntülere komut istemlerini ve bağlantılarını kaydeden JSON dosyaları da içeriyordu ve platformun iç çalışmalarına bir göz attı.

Sonrası ve tehlikeler

Fowler, veritabanının şifre koruması veya şifreleme gibi temel güvenlik önlemlerinden yoksun olduğunu, ancak olay için Gennomis veya AI-Nomis tarafından yanlış bir şey ifade etmediğini açıkça belirtti. Derhal şirkete sorumlu bir açıklama bildirimi gönderdi ve Gennomis ve AI-Nomis web siteleri çevrimdışı olduktan sonra veritabanı silindi. Ancak, veritabanındaki “Face Swap” etiketli bir klasör, açıklama bildirimini göndermeden önce kayboldu.

Bu olay, artan sorunun olduğunu vurgulamaktadır.buruşturmak” veya Derin dip Pornografi, yapay zeka, rıza olmadan gerçekçi açık görüntüler oluşturmak için kullanılır. Fowler, çevrimiçi olarak DeepFakes’in tahmini% 96’sının pornografik olduğunu, rıza göstermeyen kadınların% 99’unun pornografik olduğunu belirtti.

Maruz kalan verilerin gasp, itibar hasarı ve intikam senaryolarında kötüye kullanılması potansiyeli önemlidir. Ayrıca, bu pozlama, platformun çocukları içeren açık içeriği açıkça yasaklayan belirtilen yönergelerle çelişmektedir.

Fowler, veri maruziyetini AI görüntü oluşturma endüstrisindeki istismar potansiyeli ile ilgili bir “uyandırma çağrısı” olarak nitelendirerek daha fazla geliştirici sorumluluğuna duyulan ihtiyacı vurguladı. Özellikle küçükleri içerenler, kötüye kullanımı önlemek ve hesap verebilirliği kolaylaştırmak için kimlik doğrulaması ve filigran teknolojilerinin önemini vurgulayan ve vurgulamak için tespit sistemlerinin uygulanmasını savunmaktadır.