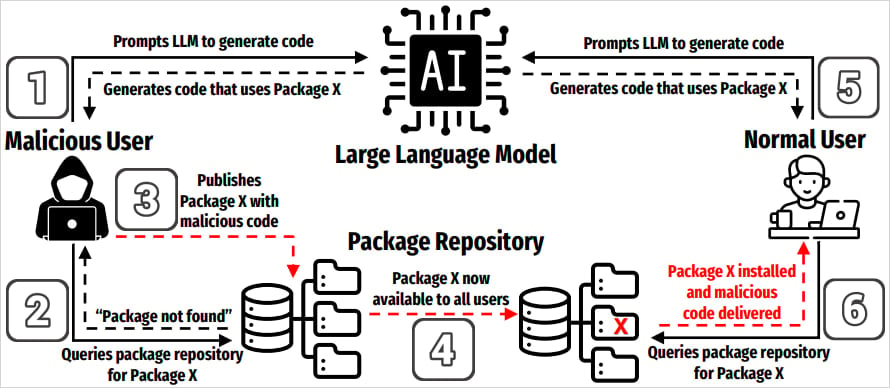

‘Slopsquatting’ adlı yeni bir tedarik zinciri saldırıları sınıfı, kodlama için üretken AI araçlarının artan kullanımından ve modelin var olmayan paket adlarını “halüsinasyon” yapma eğiliminden ortaya çıkmıştır.

Slopsquatting terimi, güvenlik araştırmacısı Seth Larson tarafından, geliştiricileri popüler kütüphanelere yakından benzeyen isimler kullanarak kötü niyetli paketler yüklemeye kandıran bir saldırı yöntemi olan yazım hattında bir dönüş olarak icat edildi.

Typosquatting’in aksine, slopsquatting yazımlara güvenmez. Bunun yerine, tehdit aktörleri, kodlama örneklerinde AI modelleri tarafından yaygın olarak oluşturulan PYPI ve NPM gibi dizinlerde kötü niyetli paketler oluşturabilirler.

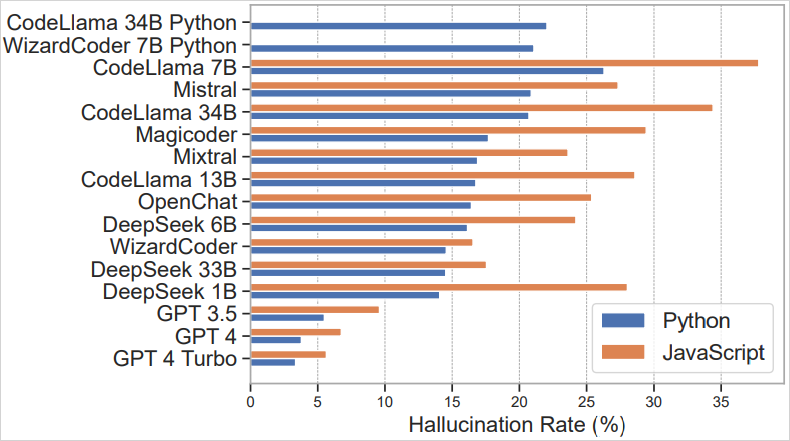

Mart 2025’te yayınlanan paket halüsinasyonları hakkında bir araştırma makalesi, incelenen vakaların yaklaşık% 20’sinde (576.000 üretilen python ve javascript kodu örnekleri) önerilen paketlerin mevcut olmadığını göstermektedir.

Durum, Codellama, Deepseek, WizardCoder ve Mistral gibi açık kaynaklı LLM’lerde daha kötüdür, ancak Chatgpt-4 gibi ticari araçlar hala yaklaşık%5 oranında halüsinasyonludur, bu da önemlidir.

Kaynak: arxiv.org

Çalışmada kaydedilen benzersiz halüsinasyonlu paket isimlerinin sayısı büyükken, 200.000’i aşan, bunların% 43’ü benzer istemlerde sürekli olarak tekrarlandı ve% 58’i on koşu içinde en az bir kez daha ortaya çıktı.

Çalışma, bu halüsinasyonlu paket adlarının% 38’inin gerçek paketlerden esinlendiği,% 13’ünün yazım hatalarının sonuçları olduğunu ve geri kalanının% 51’i tamamen imal edildiğini gösterdi.

Saldırganların bu yeni saldırıdan yararlanmaya başladıklarına dair hiçbir işaret olmamasına rağmen, açık kaynaklı siber güvenlik şirketi soketinden araştırmacılar, halüsinasyonlu paket isimlerinin yaygın, tekrarlanabilir ve anlamsal olarak akla yatkın olduğu konusunda uyardılar ve kolayca silahlandırılabilecek öngörülebilir bir saldırı yüzeyi yaratıyorlar.

“Genel olarak, halüsinasyonlu paketlerin% 58’i on koşu boyunca bir kereden fazla tekrarlandı, bu da halüsinasyonların çoğunluğunun sadece rastgele gürültü değil, modellerin belirli istemlere nasıl tepki verdiğine dair tekrarlanabilir eserler olduğunu gösteriyor.”

“Bu tekrarlanabilirlik, saldırganlara değerlerini artırarak az sayıda model çıktısını gözlemleyerek uygulanabilir slopsquatting hedeflerini tanımlamayı kolaylaştırıyor.”

Kaynak: arxiv.org

Bu riski azaltmanın tek yolu, paket adlarını manuel olarak doğrulamak ve AI tarafından oluşturulan bir kod snippet’inde belirtilen bir paketin gerçek veya güvenli olduğunu varsaymaktır.

Bağımlılık tarayıcıları, kilitli donanımlar ve paketleri bilinen, güvenilir sürümlere sabitlemeye kadar hash doğrulamasını kullanmak, güvenliği artırmanın etkili bir yoludur

Araştırma, AI “sıcaklık” ayarlarının (daha az rastgelelik) düşürülmesinin halüsinasyonları azalttığını göstermiştir, bu nedenle AI destekli veya vibe kodlamasına giriyorsanız, bu dikkate alınması gereken önemli bir faktördür.

Nihayetinde, üretim ortamlarında çalıştırmadan veya dağıtmadan önce AI tarafından üretilen kodu her zaman güvenli, izole bir ortamda test etmek ihtiyatlı olacaktır.

14 metrelik kötü niyetli eylemlerin analizine dayanarak, saldırıların% 93’ünün ve bunlara karşı nasıl savunulacağının arkasındaki en iyi 10 MITER ATT & CK tekniklerini keşfedin.