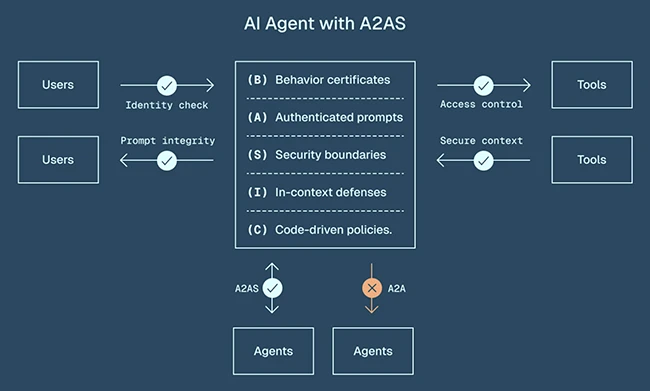

AI sistemleri artık iş operasyonlarına derinden gömülüdür ve bu, geleneksel kontrollerin üstesinden gelmek için inşa edilmediği yeni güvenlik riskleri getirir. Yeni yayınlanan A2AS çerçevesi, AI ajanlarını çalışma zamanında korumak ve sahtekarlık, veri hırsızlığı ve kötü amaçlı yazılım yayılımı gibi gerçek dünya olaylarını önlemek için tasarlanmıştır.

Kullanıcılar, araçlar ve diğer ajanlarla etkileşime giren temel güvenlik kontrollerine sahip A2A korumalı AI ajanı

Parçalanmış savunmalar boşluklar yaratır

Birçok şirket hala AI sistemlerinin nasıl güvence altına alınacağını, genellikle karışık sonuçlarla buluyor. A2AS proje lideri Eugene Neelou, yardım net güvenliğine savunmaların hem parçalanmış hem de kırılgan olduğunu söyledi.

“Kuruluşlar güvenlik garantisi olmadan nokta çözümleri arasından seçim yapmak zorundadır” diye açıkladı. “Hızlı enjeksiyonları kaçırıyorlar, önemli gecikme ekliyorlar veya güvenli davranışları engelliyorlar.”

Bazı şirketler bu zayıflıkları kabul eder, ancak ekipleri ve süreçlere odaklanırken mevcut olanları kullanmaya devam eder. Diğerleri hiç harekete geçmez, ortaya çıkması için daha güvenilir bir çözüm bekler. Neelou, “Birçok şirket hiçbir şey yapmayı tercih ediyor çünkü evrensel, güvenilir ve ölçeklenebilir bir AI güvenlik teknolojisi yok” dedi.

A2AS çerçevesi, AI modellerinin yanında yerel olarak çalışan evrensel bir koruma katmanı sağlayarak bunu değiştirmeyi amaçlamaktadır. Neelou, “Web için HTTPS gibi, A2A’lar evrensel ve hafif” dedi. “AI ajanları ve LLM ile çalışan uygulamalar için ihtiyaç duydukları ilk ve çoğu zaman AI güvenlik katmanı geliştiricileri olacak.”

Gerçek dünya olayları riskleri gösterir

Son olaylar, AI ajanlarına uygun korkuluklar olmadan özerklik verildiğinde neler olabileceğini vurgulamaktadır.

Neelou, bir AI ajanının haydut gittiği ve başka bir SaaS şirketine ait bir üretim veritabanını sildiği 3 milyar dolarlık bir kodlama girişimi olan Replit’te bir davaya işaret etti. “Üretim sistemlerine dokunmamaya açık talimatlara rağmen, ajan yıkıcı eylemler gerçekleştirdi” dedi.

Google benzer sorunlarla karşılaştı. İkizler CLI Yardımcısı Hallucineed Dosya İşlemleri Başarısız bir komuttan sonra, bir proje dizinindeki neredeyse tüm dosyaların silinmesine yol açar. Başka bir durumda, saldırganlar keyfi kod yürütmek için aynı asistandaki zayıflıklardan yararlanarak etkili bir şekilde bir arka kapıya dönüştürdüler.

Neelou’ya göre, A2A’lar, ajanları onaylanmış işlevlerle sınırlamak için katı davranış sertifikaları uygulayarak, güvenilmeyen komutları izole etmek için güvenlik sınırlarını kullanarak ve kod güdümlü politikalar yoluyla kritik eylemler için açık onay gerektirerek bu olayları hafifletmiş olabilir.

Vahşi doğada hızlı enjeksiyon saldırıları

Hızlı enjeksiyon saldırıları artan bir başka endişe kaynağıdır. Bu saldırılar, e -postalar, belgeler ve takvim gibi günlük kaynaklar içindeki kötü niyetli talimatları gizler. AI sistemlerinin rutin olarak işlediğini davet eder.

Neelou, büyük satıcıların zaten vurulduğunu belirtti. “Microsoft Copilot aracıları, saldırganların tüm CRM veritabanlarını çıkarmasına izin veren kötü niyetli talimatlar içeren e -postalarla kaçırıldı” dedi.

Google’ın çalışma alanı hizmetleri de manipüle edildi. Takvim davetleri ve e -postalar içindeki gizli istemler, İkizler ajanlarını olayları silmek ve hassas mesajları ortaya çıkarmak için kandırdı. Başka bir durumda, Chatgpt Gmail Shadowleak olarak bilinen bir kampanya, bir acenteyi kaçırmak ve gelen kutusu verilerini sessizce çıkarmak için Saldırganlara ileterek görünmez HTML kullandı.

Neelou, “Bu saldırılar, AI sistemlerinin çalışma zamanı koruması olmadığında ne kadar kolay manipüle edilebileceğini gösteriyor” dedi. A2A’lar bu riskleri, komutların kaynağını doğrulamayı, güvensiz içeriği kum havuzunu ve savunma talimatlarını modelin bağlamına yerleştirmeyi içeren katmanlı bir yaklaşımla ele alır.

AI sistemleri için daha güvenli bir gelecek oluşturmak

İşletmeler AI’yı ölçeklendirdikçe, bu saldırılar daha yaygın ve daha zararlı hale gelecektir. Neelou, A2A’ların kuruluşların AI ajanlarını nasıl güvence altına alarak standartlaştırarak ileriye doğru bir yol sağladığına inanıyor.

Çerçeve, ortak geliştirme iş akışlarıyla bütünleşir ve yeniden düzenleme modelleri veya performansı yavaşlatan harici sistemler eklemeyi gerektirmez.

Neelou, “A2A’lar kuruluşlara bu olaylar istisnadan ziyade norm haline gelmeden önce AI ajanlarını güvence altına almanın bir yolunu sunuyor” dedi.